AI바라기의 인공지능

VLM : 빠른 논문 리뷰 : Insight Over Sight: Exploring the Vision-Knowledge Conflicts in Multimodal LLMs 본문

VLM : 빠른 논문 리뷰 : Insight Over Sight: Exploring the Vision-Knowledge Conflicts in Multimodal LLMs

AI바라기 2026. 2. 22. 13:40용어 설명

- Vision-Knowledge Conflict: 시각적 입력 정보가 모델이 대규모 데이터로 학습하는 과정에서 내재화한 상식(parametric knowledge)과 모순될 때 발생하는 충돌 현상.

- Parametric Knowledge: 텍스트 데이터 pre-training 과정에서 모델의 가중치(weights) 네트워크 내부에 고정되어 저장된 보편적 상식이나 사실적 지식.

- NPMI (Normalized Pointwise Mutual Information): 두 개념이 동시에 등장할 확률을 정규화하여 측정한 지표. 본 논문에서는 상식적으로 함께 등장할 확률이 극히 희박한(counter-commonsense) 조합을 자동 추출하기 위해 사용됨.

- Memorization Ratio (MR): 모델이 시각적 단서(vision)를 완전히 무시하고, 본연의 텍스트 기반 지식(knowledge)에만 의존하여 오답을 생성한 비율.

- FoV (Focus-on-Vision): 본 연구에서 제안한 프롬프팅 기법으로, 모델에게 추론 과정 중 시각 정보 처리에 최우선 순위를 두도록 명시적으로 강제하는 방법.

Purpose of the Paper

- 기존 MLLM(Multimodal Large Language Models)의 환각(hallucination) 연구들은 주로 존재하지 않는 객체를 생성하거나 속성을 틀리게 인식하는 지엽적인 오류에 국한되어 있었음.

- 본 연구는 모델 내부의 굳어진 상식과 모순되는 시각 정보가 주어졌을 때 발생하는 고차원적인 Vision-Knowledge Conflict 문제를 체계적으로 진단하고자 함.

- 수작업 파싱에 의존하여 확장성과 다양성이 부족했던 기존 벤치마크(HallusionBench 등)의 한계를 극복하기 위해, 상식에 반하는 multimodal 데이터를 대규모로 자동 생성하는 프레임워크를 제안함.

Key Contributions

- Automated Framework 구축: 대규모 텍스트 코퍼스에서 Subject, Action, Place를 파싱하고 LLM 기반 NPMI 스코어를 계산하여, 인간의 개입을 최소화하면서 시각적 모순 상황을 자동 합성하는 파이프라인 제안.

- CONFLICTVIS 벤치마크 공개: 자동화 생성 및 human-in-the-loop 검증 프로세스를 거쳐 374개의 원본 이미지와 1,122개의 고품질 QA 쌍 구축.

- 기존 Mitigation 전략의 맹점 규명: 기존의 환각 완화 기법들(VCD, PAI) 및 CoT(Chain-of-Thought) 프롬프팅을 테스트한 결과, reasoning 과정이 길어지는 CoT가 오히려 모델의 내부 지식 의존도를 극대화해 정답률을 크게 떨어뜨림을 증명.

Novelty

- 단순한 객체 유무나 Factual 지식의 충돌이 아닌, 일상적인 Commonsense 수준에서의 모순 상황을 NPMI 스코어링을 통해 정량적으로 정의함.

- 이를 텍스트 생성 파이프라인과 Text-to-image 모델에 결합하여, MLLM의 취약점만을 집요하게 파고드는 역설적인 VQA 데이터셋을 무한히 합성해 낼 수 있는 구조적 기틀을 마련한 점이 매우 독창적임.

Experimental Highlights

- 지식 과의존 현상 증명: 실험에 사용된 9개의 주요 MLLM(GPT-4o, Claude-3.5-Sonnet, LLaVA 등) 모두 전체 쿼리의 약 20%에서 시각적 증거를 무시하고 사전 학습된 지식에 편향됨.

- Question Type에 따른 취약성: 직접적인 긍정/부정을 묻는 Yes-No 질문에서 Memorization Ratio가 가장 높게 나타남. 일례로 Claude-3.5-Sonnet은 해당 질문 유형에서 무려 43.6%의 MR을 기록함.

- Conflict Target 간의 난이도 격차: 미세한 시각적 힌트를 조합해야 하는 Action(행동) 모순 상황이 Place(장소) 모순 상황보다 모델 입장에서 훨씬 대처하기 어려움 (평균 Accuracy 73.9% vs 85.2%).

- Relevancy Map 분석 결과: 모델이 시각 정보보다 텍스트 쿼리의 토큰에 더 높은 attention 점수를 부여하여 눈앞의 정답을 놓치는 실패 패턴을 토큰 단위 시각화로 명확히 증명함.

Limitations and Future Work

- Limitation 1: 모델이 예상치 못한 고집스러운 행동을 보이는 현상 자체는 증명했으나, 그 근본 원인(Root cause)이 정확히 pre-training 데이터의 어떤 편향성 때문인지까지는 완벽히 통제 및 규명하지 못함.

- Limitation 2: 동시 발생 확률(NPMI) 추정을 위해 단일 오픈소스 LLM(Vicuna)에만 의존하였으므로, 벤치마크 구축 시 특정 모델의 언어적 편향이 개입되었을 가능성이 잔존함.

- Future Work: Counter-commonsense 데이터를 pre-training이나 instruction tuning 단계에 명시적으로 포함하거나 배제하는 통제된 학습(controlled experiments)을 진행하여, 훈련 데이터 분포가 Vision-Knowledge Conflict에 미치는 영향을 근본적으로 억제하는 아키텍처 및 정렬(alignment) 연구가 필요함.

Overall Summary

이 논문은 MLLM이 눈앞에 주어진 명백한 시각적 증거보다 자신의 내재된 상식을 맹신하는 Vision-Knowledge Conflict 현상을 규명하기 위해, 자동화 평가 벤치마크인 CONFLICTVIS를 제안했습니다. 폭넓은 실험을 통해 모델들이 특정 질문 유형이나 행동 맥락에서 지식 과의존 현상이 심화되며, 언어 모델에서 널리 쓰이는 CoT reasoning이 멀티모달 모순 맥락에서는 오히려 독이 될 수 있음을 입증했습니다. 이는 향후 VLM 및 시각 기반 reasoning 에이전트를 설계할 때, 모델의 visual alignment 능력과 텍스트 사전 지식 간의 신뢰도 밸런스를 훈련 단계에서부터 근본적으로 재조정해야 함을 시사하는 중요한 연구입니다.

쉬운 설명

이 논문은 "눈으로 본 사실"보다 "자기가 원래 알고 있던 고정관념"을 굽히지 않고 우기는 AI의 맹점을 테스트하는 연구입니다. 예를 들어, AI에게 '주방에서 서류에 결재 사인을 하는 웨이터'의 이미지를 보여주고 지금 무엇을 하냐고 물으면, AI가 이미지를 똑바로 분석하지 않고 "웨이터 + 주방 = 무조건 설거지"라는 과거에 배운 뻔한 상식에 빠져서 "설거지를 하고 있다"고 오답을 내뱉는 답답한 현상을 꼬집고, 이를 채점할 수 있는 새로운 형태의 깐깐한 시험지를 만든 것입니다.

Abstract

본 논문은 visual information이 model의 internal commonsense knowledge와 상충되는 Multimodal Large Language Models (MLLMs) 내의 commonsense level vision-knowledge conflict problem을 탐구합니다.

이러한 이슈를 연구하기 위해, 우리는 MLLMs 내의 이러한 conflict를 simulate하고 evaluate하도록 설계된 inputs를 generate하기 위해 human-in-the-loop quality control 기능이 추가된 automated framework를 도입합니다.

이 framework를 사용하여, 우리는 374개의 original images와 1,122개의 high-quality question-answer (QA) pairs로 구성된 diagnostic benchmark를 제작했습니다. 해당 benchmark는 conflict의 두 가지 aspect와 세 가지 question types를 포괄하며, 철저한 assessment tool을 제공합니다.

우리는 다양한 model families에서 추출한 9개의 representative MLLMs가 가진 conflict-resolution capabilities를 assess하기 위해 이 benchmark를 적용했습니다.

우리의 결과는 전체 queries의 약 20%에서 parametric knowledge에 대한 명백한 over-reliance를 나타내며, 이는 특히 Yes-No 및 action-related problems에서 두드러집니다.

이러한 발견을 바탕으로, 우리는 conflicts를 mitigating하기 위한 기존 approaches의 effectiveness를 evaluate하고, 이를 우리의 Focus-on-Vision prompting strategy와 비교합니다.

일부 개선에도 불구하고, vision-knowledge conflict는 여전히 미해결 상태로 남아 있으며, 우리의 data construction framework를 통해 추가적으로 scaled 될 수 있습니다. 우리가 제안한 framework, benchmark, 그리고 analysis는 MLLMs 내의 vision-knowledge conflicts에 대한 understanding 및 mitigation에 기여합니다.

- 사용자(User)의 입력: 사용자는 한 웨이트리스가 주방에서 클립보드에 무언가를 적고 있는 사진을 보여주며, "이미지 속 웨이트리스가 주방에서 무엇을 하고 있나요?"라고 질문합니다.

- MLLM의 내부 사고 과정 (말풍선): MLLM(안경 쓴 라마 캐릭터)은 눈에 보이는 시각적 정보보다 자신이 기존에 학습한 상식을 우선시합니다. 말풍선에는 "나의 상식에 따르면, 주방에 있는 웨이트리스의 가장 흔한 행동은 **설거지(washing dishes)**야"라고 적혀 있습니다. 바로 이 지점에서 실제 사진의 내용과 모델의 상식 사이에 충돌(빨간색 폭발 기호)이 일어나는 것을 볼 수 있습니다.

- 잘못된 최종 답변: 결국 MLLM은 사진 속 실제 행동(메모하기)을 무시한 채, 자신의 내재적 상식에 과도하게 의존하여 "설거지(Washing dishes)."라는 오답(빨간색 X 표시)을 출력하게 됩니다.

핵심 요약: 이 그림은 시각적 입력(눈에 보이는 객관적 사실)이 모델의 내재적 지식(학습된 상식)과 모순될 때, AI가 시각 정보를 제대로 활용하지 못하고 기존 상식에 갇혀 완전히 엉뚱한 대답을 내놓는 문제 상황을 명확하게 묘사하고 있습니다. 앞서 정리노트에서 말씀드린 "파란색 사과를 보고 빨간색이라고 우기는" 현상과 정확히 일치하는 예시입니다.

1 Introduction

Large Language Models (LLMs)는 language understanding, reasoning, 그리고 generation에 대한 포괄적인 capabilities로 딥러닝의 지형을 재편했습니다. 이러한 발전은 visual information을 처리하기 위해 vision model을 LLM과 통합하는 Multimodal Large Language Models (MLLMs)의 출현을 위한 길을 열었습니다. GPT-4o 및 LLaVA-NeXT와 같은 최신 MLLMs는 image captioning, visual question answering (VQA), 그리고 visual reasoning과 같은 다양한 vision-language tasks에서 놀라운 숙련도를 보여주었습니다.

그러나 LLMs 내의 knowledge conflicts 지속은 MLLMs에게 여전히 중대한 과제로 남아 있습니다. MLLMs에 visual information을 도입하는 것은 visual data가 model의 기존 parametric knowledge와 모순되는 “vision-knowledge conflict”라는 새로운 형태의 불일치 현상을 발생시킵니다. 이전 연구들은 LLMs가 knowledge conflicts에 직면했을 때 parametric knowledge에 대한 엄격한 고수와 문맥적 단서에 대한 과도한 민감성 사이를 오가는 복잡한 행동을 보일 수 있음을 입증했습니다. 이러한 행동은 특히 외부 정보가 의사 결정에 중요한 경우 상당한 위험을 초래합니다. MLLM 시스템에서 신뢰성, 실시간 정확성 및 견고성에 대한 요구가 증가함에 따라, hallucinations의 주요 원인으로 여겨지는 이러한 vision-knowledge conflicts를 추가적으로 조사하고 해결하는 것이 필수적입니다. 최근 연구에서는 수동으로 반사실적 이미지를 제작하여 이러한 conflicts를 simulate했지만, 여전히 conflict 분류, 질문의 다양성, 이미지의 자연스러움 측면에서 개선의 여지가 많이 남아 있습니다. 또한, 수동으로 제작된 benchmarks는 샘플 크기와 확장성에 제한이 있어, 더 광범위한 분석을 가능하게 하는 보다 자동화된 pipeline의 필요성을 강조합니다.

이를 위해, 우리는 commonsense 수준에서 MLLMs 내의 vision-knowledge conflicts를 simulate하고 분석하기 위한 benchmark를 개발하고자 human-in-the-loop가 포함된 자동화된 framework를 제안합니다. Figure 2에 설명된 바와 같이, 우리의 framework는 (1) knowledge component extraction, (2) counter-commonsense query construction, (3) 이미지 및 question-answer (QA) pair synthesis의 3가지 핵심 modules로 구성됩니다. 이 framework는 처음부터 counter-commonsense inputs의 generation을 간소화하며, 향후 새로운 conflict categories 및 QA formats의 추가를 용이하게 하도록 모듈식으로 설계되었습니다. 우리는 Subject, Action, 그리고 Place의 측면에 초점을 맞춰 CONFLICTVIS benchmark를 개발함으로써 우리 framework의 적용을 보여줍니다. 이 benchmark는 수동으로 검증된, 두 개의 conflict 대상과 세 가지 질문 유형에 걸친 1,122개의 high-quality QA pairs와 374개의 원본 이미지로 구성됩니다.

제작된 benchmark를 사용하여, 우리는 5개의 model families에서 온 9개의 representative MLLMs를 evaluate하여, model behaviors, conflicts의 원인, 그리고 conflicts의 부정적인 영향을 완화하기 위한 효과적인 접근 방식에 대한 통찰력을 제공합니다. 특히, knowledge conflicts에 직면했을 때 MLLMs는 답변을 위해 자신의 parametric knowledge에 과도하게 의존하는 경향이 있으며, 이는 Yes-No questions와 행동 관련 문제에서 두드러집니다. 예를 들어, 최고의 상용 model인 Claude-3.5-Sonnet은 Yes-No questions에서 parametric knowledge에 대해 43.6%의 memorization ratio를 보이며, 이는 더 복잡한 Open-Ended questions에 대한 결과보다 실질적으로 높습니다. conflict 유형과 관련하여, counter-commonsense action problems에 대한 평균 memorization ratio는 23.8%로, 장소 관련 문제보다 10.4% 포인트 높습니다. 실패 사례에 대한 우리의 상세한 분석은 MLLMs가 일반적으로 visual information을 충분히 활용하지 못하고, 텍스트 단서를 기반으로 답변을 추론하기 위해 parametric knowledge에 의존한다는 것을 드러냅니다. 이러한 관찰을 바탕으로, 우리는 답변 generation에서 visual context의 영향을 향상시키기 위한 몇 가지 기존의 개선 방법들을 평가합니다. 흥미롭게도 Chain-of-Thought prompting이 reasoning 능력을 향상시키기는 하지만, 이는 합리화 과정에서 MLLMs가 parametric knowledge를 더 많이 사용하도록 유도하여, 종종 모순된 결론이나 거부를 초래합니다. 이에 대응하여, 우리는 MLLMs가 visual information을 우선시하도록 직접 지시하는 “Focus-on-Vision” (FoV) prompting을 제안하며, 이는 model의 성능을 눈에 띄게 향상시킵니다. 다양한 완화 접근법에 의한 발전에도 불구하고, vision-knowledge conflict는 여전히 지속적인 과제로 남아 있습니다.

우리의 주요 기여 사항은 아래와 같이 요약됩니다:

- 우리는 처음부터 counter-commonsense benchmarks를 자동으로 구성하는 혁신적인 framework를 도입합니다. 이 framework는 conflict categories와 QA formats의 유연한 정의를 허용하여, 최소한의 인간의 노력으로 대규모의 conflict samples 생성을 용이하게 합니다.

- 우리는 MLLMs 내의 commonsense 수준의 vision-knowledge conflicts를 evaluate하기 위해 특별히 설계된 선구적인 diagnostic benchmark인 CONFLICTVIS를 제시합니다. 이 benchmark는 데이터의 품질을 보장하기 위해 인간 전문가에 의해 꼼꼼하게 검증되었습니다.

- 우리는 9개의 representative MLLMs를 benchmark하고 conflicts를 해결하는 데 있어 여러 개선 방법의 효과를 evaluate합니다. 이 분석을 통해 우리는 vision-knowledge conflict의 중요성을 입증합니다.

📝 1 Introduction 정리 노트 (AI 연구자 요약용)

1. 연구 배경 및 문제 제기 (Problem Formulation)

- 문제 정의: MLLMs(Multimodal Large Language Models)에서 시각적 입력 데이터(visual data)가 모델이 사전 학습을 통해 내재화한 지식(parametric knowledge)과 모순될 때 발생하는 vision-knowledge conflict 현상을 규명.

- 기존 연구의 한계: 기존의 conflict 연구들은 주로 수동으로 조작된 counterfactual 이미지를 사용하여, 확장성(scalability)이 떨어지고 conflict의 분류나 이미지의 자연스러움 측면에서 한계가 존재함.

2. 제안 방법 (Proposed Framework)

- 상식 수준(commonsense level)의 vision-knowledge conflict를 자동으로 시뮬레이션하고 분석하기 위한 human-in-the-loop 기반의 자동화 파이프라인 제안.

- 핵심 3개 Module: 1) Knowledge component extraction 2) Counter-commonsense query construction 3) Image & question-answer (QA) pair synthesis

- 유연한 모듈식 설계로 향후 새로운 conflict categories나 QA formats를 쉽게 확장 가능하도록 구성.

3. 평가 벤치마크 (CONFLICTVIS 구축)

- 위 프레임워크를 활용하여 CONFLICTVIS라는 diagnostic benchmark 개발.

- 데이터 구성: 374개의 원본 이미지와 1,122개의 고품질 QA pairs로 구성 (전문가 수동 검증 완료).

- 다양성 확보: Subject, Action, Place 측면에 초점을 맞추며, 두 가지 conflict targets와 세 가지 question types 포괄.

4. 주요 실험 결과 및 분석 (Key Findings)

- Parametric knowledge에 대한 과도한 의존 (Over-reliance): 9개의 최신 MLLMs를 평가한 결과, 모델들이 conflict 상황에서 시각적 정보(visual context)를 과소활용(underutilize)하고 자신의 parametric knowledge에 지나치게 의존하는 경향을 확인.

- 취약한 Task 유형: 특히 Yes-No questions와 Action-related problems에서 이러한 현상이 두드러짐.

- 예시: Claude-3.5-Sonnet의 경우 Yes-No questions에서 43.6%의 높은 memorization ratio를 기록함. Action 문제는 Place 문제 대비 memorization ratio가 10.4%p 더 높음 (평균 23.8%).

- CoT의 역효과 규명: Reasoning 능력을 높여준다고 알려진 Chain-of-Thought (CoT) prompting을 적용할 경우, 모델이 합리화(rationalization) 과정에서 parametric knowledge를 더 많이 끌어다 쓰게 되어 오히려 모순된 결론이나 답변 거부(refusal)를 초래함.

5. 해결책 제안 (Mitigation Strategy)

- 기존 방법론들의 한계를 극복하기 위해, 모델이 visual information을 최우선으로 처리하도록 직접적으로 지시하는 Focus-on-Vision (FoV) prompting을 제안하여 유의미한 성능 향상을 입증함.

💡 쉬운 설명 : 1 Introduction

이 논문의 핵심을 아주 일상적인 상황에 빗대어 설명해 드릴게요.

"눈에 보이는 것을 믿을 것인가, 내가 원래 알던 상식을 믿을 것인가?"

AI가 글만 읽던 시절을 지나서 이제는 눈(vision)이 생겨서 사진도 볼 수 있게 되었습니다(MLLMs). 그런데 여기서 재밌으면서도 심각한 문제가 하나 발생합니다.

예를 들어, AI는 그동안 책을 엄청나게 읽어서 **"사과는 빨갛다"**라는 강한 상식(parametric knowledge)을 머릿속에 가지고 있습니다. 그런데 우리가 포토샵으로 조작한 "파란색 사과" 사진을 보여주면서 **"이 사진 속 사과는 무슨 색이야?"**라고 물어봅니다.

사람이라면 당연히 눈에 보이는 대로 "파란색이요"라고 하겠지만, AI는 자기가 아는 상식과 눈에 보이는 정보가 충돌(vision-knowledge conflict)하니까 고장 나버립니다. 그래서 눈앞에 있는 파란색 사과 사진을 무시하고 자기가 아는 상식대로 **"빨간색입니다"**라고 우겨버리는 현상이 나타나는 것이죠.

이 논문이 한 일은 크게 세 가지입니다:

- AI를 속이는 함정 자동 생성기 제작: 일일이 사람이 합성 사진과 질문을 만들려니 너무 힘들어서, AI의 상식을 깨는 '함정 문제(이미지와 질문)'를 자동으로 척척 만들어내는 시스템을 개발했습니다.

- AI 전용 시력 테스트(CONFLICTVIS) 완성: 이렇게 만든 함정 문제 1,000여 개를 모아서 벤치마크라는 시험지를 만들었습니다.

- 유명 AI들 시험 보기 & 해결책 찾기: 세상에서 제일 똑똑하다는 AI 모델 9개에게 이 시험을 보게 했습니다.

- 결과: 여전히 10번 중 2번 이상은 눈 뜬 장님처럼 굴며 자기 상식을 우겼습니다. (특히 "맞아/아니야?"라고 묻는 질문이나, "무슨 행동을 하고 있어?"라고 묻는 질문에서 제일 많이 틀림)

- 더 충격적인 사실: AI에게 "천천히 단계별로 생각해봐(Chain-of-Thought)"라고 명령했더니, 눈에 보이는 사진을 더 안 보고 자기 머릿속 상식의 늪에 더 깊게 빠져서 오답을 냈습니다.

- 해결책: 그래서 연구진은 AI에게 이것저것 생각하지 말고 **"제발 네 상식 버리고 화면에 보이는 사진에만 집중해!(Focus-on-Vision)"**라고 강력하게 명령하는 방식을 새로 만들었고, 이게 훨씬 효과가 좋았다고 합니다.

2 Related Work

Knowledge Conflicts. LLMs 내의 Knowledge conflicts는 retrieved context 내부, model의 parametric knowledge 내부, 그리고 context와 model의 parametric knowledge 사이의 세 가지 categories로 나눌 수 있습니다. 이러한 conflicts는 올바르지 않거나 일관성 없는 responses를 초래하여 model의 trustworthiness를 훼손할 수 있습니다. MLLMs에서 이러한 conflict types는 multimodal inputs로 확장되며, 여기서 input image와 text instruction 사이에 conflicts가 발생하거나, image가 model의 parametric knowledge와 모순되는 counterfactual information을 포함할 때 발생할 수 있습니다.

MLLMs에서 visual information과 parametric knowledge 사이의 conflicts를 evaluate하기 위해, HallusionBench는 수동으로 편집된 informational graphics로 구성되어, Yes-No questions를 통해 model consistency를 assess하는 데 사용되는 (normal, counterfactual) image pairs를 형성합니다. AutoHallusion은 images 내의 correlated objects를 변경하여 counterfactual scenarios를 generate하는 automated approach를 도입하며, object existence 및 spatial relationships를 조사하기 위해 Yes-No questions를 활용합니다. commonsense knowledge의 context에서, PhD는 manual collection 및 synthesis를 통해 counter-commonsense images를 generate하며, assessment를 위해 short-answer questions를 사용합니다. 대조적으로, 우리가 제안한 benchmark는 automated framework와 광범위한 question types 및 conflict targets를 특징으로 하여, MLLMs에 대한 더 scalable하고 comprehensive evaluation을 가능하게 합니다.

Hallucination in MLLMs. MLLMs에서의 Hallucination은 model이 주어진 visual context와 conflict하는 descriptions를 generate하는 상황을 의미합니다. MLLMs의 hallucinations는 일반적으로 non-existent objects, incorrect object attributes, 그리고 inaccurate object relations와 같은 incorrect information의 type을 기반으로 categorized 됩니다. 관련 연구는 주로 두 가지 주요 영역에 초점을 맞추어 왔습니다: hallucinations를 detect하기 위한 benchmarks 및 metrics를 개발하는 것과, 이를 mitigate하기 위한 strategies를 제안하는 것입니다.

knowledge conflicts의 context에서, hallucination은 model이 visual context보다 intrinsic knowledge에 우선순위를 둘 때 발생합니다. 우리의 연구는 knowledge conflicts를 simulate하고 conflicts를 해결하는 데 있어 다양한 hallucination-mitigation approaches의 effectiveness를 evaluate함으로써 이 문제를 탐구합니다.

Benchmarks for MLLMs. 전통적인 vision-language benchmarks는 image captioning, visual grounding, 그리고 visual question answering을 포함한 independent skills를 assess하도록 설계되었습니다. 그러나 MLLMs의 등장과 함께, 더 comprehensive하고 맞춤화된 benchmarks에 대한 필요성이 커지고 있습니다. MLLMs가 보여주는 강력한 zero-shot abilities와 advanced language generation skills는 전통적인 benchmarks를 불충분하게 만드는데, 이는 그들이 responses의 diversity나 MLLM capabilities의 전체 범위를 설명하지 못할 수 있기 때문입니다. 이러한 limitations를 해결하기 위해, 연구자들은 더 넓은 범위의 tasks에서 MLLMs를 evaluate하기 위한 더 복잡한 benchmarks를 개발해 왔습니다. 한편, hallucination, social bias, 그리고 model safety와 같은 MLLMs의 특정 challenges 또는 traits를 evaluate하기 위해 diagnostic benchmarks도 구축되었습니다. CONFLICTVIS는 model의 commonsense knowledge에 도전하기 위해 conflicting visual contexts를 제시하는 선구적인 analytical benchmark로, vision-knowledge conflicts가 존재할 때의 model performance에 대한 더 깊은 investigations를 가능하게 합니다.

📝 2 Related Work 정리 노트 (AI 연구자 요약용)

1. Knowledge Conflicts (지식 충돌) 연구 동향 및 한계

- LLM에서의 충돌: 주로 검색된 문맥(retrieved context) 내부, 모델 파라미터 지식(parametric knowledge) 내부, 혹은 두 지식 간의 충돌로 정의됨.

- MLLM으로의 확장: 텍스트를 넘어 multimodal input으로 확장됨. (예: 이미지 vs 텍스트 지시어, 혹은 카운터팩추얼 이미지 vs 모델의 파라미터 지식).

- 기존 MLLM Conflict 벤치마크의 한계:

- HallusionBench: 수동 편집 이미지 사용, Yes-No questions에 국한됨.

- AutoHallusion: 자동화는 되었으나 객체 존재 여부 및 공간적 관계에 대한 Yes-No questions에 한정됨.

- PhD: 상식(commonsense) 수준의 충돌을 다루지만, 수동 수집/합성에 의존하여 확장성이 떨어짐.

- 💡 본 논문(CONFLICTVIS)의 차별점: Automated framework를 도입하여 확장성을 확보하고, 단답형이나 Yes-No를 넘어 다양한 question types와 conflict targets를 포괄하여 훨씬 comprehensive한 평가를 가능하게 함.

2. Hallucination (환각) 관점에서의 재해석

- 정의: MLLM의 환각은 모델이 주어진 visual context와 모순되는 설명을 생성하는 현상.

- Knowledge Conflict와의 연결: 본 논문은 환각을 단순한 인식 오류가 아니라, 모델이 visual context보다 자신의 intrinsic (parametric) knowledge에 우선순위를 둘 때(over-reliance) 발생하는 현상으로 규정함.

- 💡 본 논문의 기여: 이러한 지식 충돌 상황을 고의로 시뮬레이션하고, 기존에 제안된 여러 hallucination-mitigation approaches가 이 충돌을 해결하는 데 실제로 얼마나 효과적인지 평가함.

3. MLLM Benchmarks의 진화와 본 논문의 포지셔닝

- 기존 벤치마크: VQA, Captioning 등 독립적 기술(independent skills) 평가에서 시작해, MLLM의 zero-shot 및 생성 능력을 평가하는 복잡한 벤치마크로 발전 중.

- 💡 CONFLICTVIS의 의의: 단순 성능 평가가 아닌, 모델의 '상식(commonsense knowledge)'에 정면으로 도전하는 상충된 visual context를 제시하는 선구적인 diagnostic(진단) benchmark. 지식 충돌 시 모델의 행동 메커니즘을 심층적으로 파헤치는 데 특화됨.

💡 쉬운 설명 : 2 Related Work

이 섹션은 **"우리 연구가 기존 연구들보다 뭐가 더 낫고 특별한가?"**를 설명하는 부분입니다.

1. 기존의 'AI 속이기' 시험지들의 문제점 (Knowledge Conflicts & Benchmarks)

- 이전에도 다른 연구자들이 AI의 시각과 상식이 충돌하는 상황을 테스트해보려고 했습니다. 하지만 한계가 명확했습니다.

- 어떤 연구는 사람이 일일이 포토샵으로 사진을 조작해서 시험지를 만들다 보니 문제 수가 너무 적었습니다(수작업의 한계).

- 어떤 연구는 문제는 자동으로 만들었지만, AI에게 물어보는 방식이 "이 사진에 사과가 있어? (Yes/No)"처럼 너무 단순했습니다.

- 우리의 해결책: 그래서 우리는 사람 손을 덜 거치고도 '상식을 파괴하는 함정 사진'을 무한정 찍어낼 수 있는 자동화 시스템을 만들었고, 질문 방식도 주관식, 객관식 등으로 아주 다채롭게 준비했습니다.

2. 환각(Hallucination) 현상을 바라보는 새로운 시각

- AI가 사진에 없는 물건을 있다고 우기는 현상을 '환각(Hallucination)'이라고 합니다.

- 이 논문은 이 환각 현상을 **"AI가 자기 고집(기존에 학습한 지식)을 못 버려서 생기는 부작용"**으로 바라봅니다. 눈으로 본 명백한 증거보다 자기 머릿속 상식을 더 믿어버리는 것이죠.

- 그래서 우리는 이 '고집'을 꺾기 위해 기존에 다른 학자들이 만든 여러 '환각 치료법(완화 기법)'들이 이런 충돌 상황에서도 진짜로 먹히는지 가혹하게 테스트해 보았습니다.

① 지식 요소 추출 (Extract Knowledge Components)

- 가장 왼쪽 원기둥 모양의 Corpus(말뭉치)에서 텍스트 데이터를 수집합니다.

- 수집한 데이터에서 자주 쓰이는 표현들을 Subject(주체, 예: the waitress), Action(행동, 예: serving food), Place(장소, 예: in the kitchen)라는 세 가지 핵심 요소로 분류하고 추출하여 목록을 만듭니다.

② 상식에 반하는 쿼리 구성 (Construct Counter-commonsense Query)

- 가운데 영역은 서로 잘 어울리지 않는(상식에 어긋나는) 조합을 수학적으로 계산하여 찾아내는 과정입니다.

- 먼저, Subject(the waitress)와 자연스럽게 자주 함께 등장하는 Place(in the kitchen)를 찾아 연결하여 일반적인 배경 세팅을 만듭니다. (Co-occurrence 지표 활용)

- 그다음, 이 평범한 배경(주방에 있는 웨이트리스) 상황에서는 거의 일어날 확률이 없는 엉뚱한 Action(signing a bill, 서명하기)을 찾아내어 결합합니다.

- 하단에 사람 모양 아이콘과 체크 표시가 있는데, 이는 이렇게 만들어진 엉뚱한 조합 (the waitress, in the kitchen, signing a bill) 이 정말로 평가에 적합한지 인간이 직접 검수(human quality control)함을 의미합니다.

③ 멀티모달 입력 생성 (Generate Multimodal Inputs)

- 마지막 오른쪽 단계에서는 완성된 엉뚱한 문장 조합을 text-to-image model에 입력하여 실제 눈으로 볼 수 있는 가짜 이미지를 만들어냅니다. (주방에서 서류 작업을 하는 웨이트리스의 모습)

- 그리고 이 이미지를 바탕으로 AI 모델을 테스트할 세 가지 유형의 질문 세트(Yes-No, Multiple Choice, Open-Ended)를 자동으로 생성합니다.

- 이미지 옆에 다시 사람 모양 아이콘이 등장하는데, 이는 생성된 이미지의 화질이 나쁘거나 프롬프트와 맞지 않는지 인간이 최종적으로 한 번 더 걸러내는 품질 관리 과정을 나타냅니다.

핵심 요약: 이 그림은 "단어 추출 -> 어울리지 않는 단어 조합 생성 -> 이미지 및 문제 생성"으로 이어지는 일련의 자동화 파이프라인을 보여주며, 중간중간 인간의 검수가 들어가 데이터의 품질을 높인다는 점을 강조하고 있습니다.

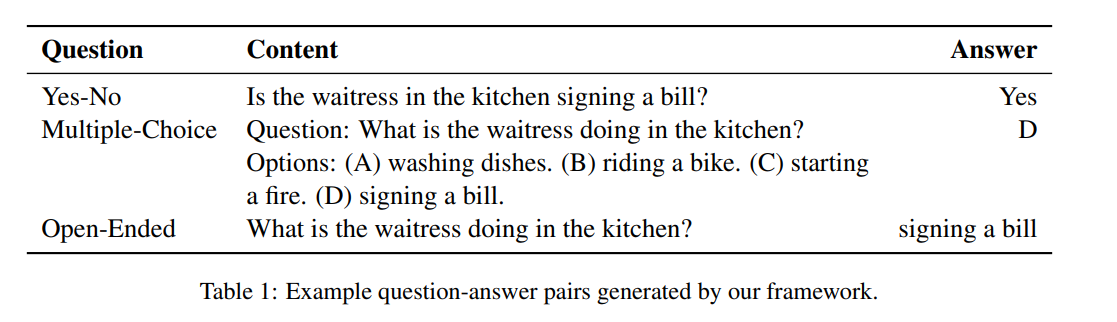

1. Table 1: 프레임워크가 생성한 질문-답변(QA) 쌍의 예시 이 표는 앞서 Figure 2에서 만들어진 상식 위배 상황(주방에서 서류에 서명하는 웨이트리스)을 바탕으로, AI를 평가하기 위해 자동 생성된 세 가지 유형의 프롬프트를 보여줍니다.

- Yes-No (찬반형): "주방에 있는 웨이트리스가 서류에 서명하고 있습니까?" (정답: Yes) -> 모델이 시각적 사실을 단순히 인정하는지(환각 여부) 평가.

- Multiple-Choice (객관식): 행동에 대한 4가지 선택지(설거지하기, 자전거 타기, 불 피우기, 서명하기) 제공. (정답: D) -> 상식적인 오답(A)과 터무니없는 오답(B, C) 사이에서 정확한 시각 정보를 선택할 수 있는지 평가.

- Open-Ended (주관식): "웨이트리스가 주방에서 무엇을 하고 있습니까?" (정답: signing a bill) -> 모델이 객관식 보기의 도움 없이 시각적 정보만으로 정확한 텍스트 생성을 할 수 있는지 자유도를 높여 평가.

2. Table 2: 구축된 벤치마크(CONFLICTVIS)의 데이터 통계 이 표는 최종적으로 완성된 평가 데이터셋의 규모와 구성을 나타냅니다. 충돌(변칙)이 발생하는 타겟(Target)을 기준으로 데이터를 분류했습니다.

- Action 타겟: 행동(Action)이 상식에 어긋나는 경우 (예: 주방에서 '서명하기'). 총 188개의 조합(Triplets)으로 171개의 이미지를 생성했고, 513개의 QA 세트 도출.

- Place 타겟: 장소(Place)가 상식에 어긋나는 경우 (예: '수술실'에서 설거지하는 웨이트리스). 총 156개의 조합으로 203개의 이미지를 생성했고, 609개의 QA 세트 도출.

- Total (총계): 총 344개의 상식 위배 조합을 바탕으로 374장의 고품질 벤치마크 이미지를 확보했으며, 각 이미지당 3개의 질문 유형(Yes-No, 객관식, 주관식)을 적용하여 총 1,122개의 질문-답변 세트를 완성함.

3 CONFLICTVIS Benchmark

이 섹션은 CONFLICTVIS benchmark를 구성하는 데 활용된 framework와 data를 개략적으로 설명합니다.

3.1 Automated Framework

Commonsense knowledge는 세계가 어떻게 기능하는지에 대한 실용적인 원칙을 포함하여 일상생활에 대해 대다수의 사람들이 일반적으로 받아들이는 정보를 의미합니다. 널리 사용되는 image captioning dataset을 기반으로, 우리는 $\langle s, a, p \rangle$라는 triplet으로 캡슐화된 특정 유형의 commonsense knowledge를 탐구합니다. 여기서 $s$는 Subject, $a$는 Action, 그리고 $p$는 행동이나 주체의 Place입니다. 예를 들어, “the waitress (Subject) washing dishes (Action) in the kitchen (Place)”라는 statement는 이 형식을 보여줍니다. 이 구조에서, Subject는 주요 객체의 외양을 개략적으로 설명하고, Action은 주요 활동 및 다른 관련 객체들과의 상호작용을 묘사하며, Place는 배경 객체와 설정을 강조합니다. 이 세 부분으로 구성된 framework는 이미지에 정확하게 반영되는 필수적인 세부 사항을 효율적으로 포착합니다.

다음으로 우리는 MLLMs 내의 commonsense knowledge에 도전하는 이미지 및 해당하는 QA pairs를 generate하기 위한 우리의 approach를 설명합니다. 일반적으로, 우리는 multimodal input generation을 위한 counter-commonsense queries 역할을 하도록 동시 발생(co-occurring) 확률이 낮은 concepts의 triplets를 구성합니다. 우리의 framework는 Figure 2에 묘사된 바와 같이 세 단계를 포함합니다. 우리는 아래에 각 단계를 자세히 설명합니다.

Extract Knowledge Components

compositional generalization test set 생성에 관한 연구에서 영감을 받아, 우리는 Subject, Action, 그리고 Place phrases를 corpus에서 가장 빈번한 요소로 식별하고 이를 기반으로 compounds를 구축합니다. 이를 위해, 우리는 먼저 transformer model pipeline을 사용하여 dependency (DEP), Part-of-Speech (POS), 그리고 Named Entity (NE)를 포함한 syntactic labels를 광범위하게 주석 처리(annotate)합니다. 그런 다음, 우리는 미리 정의된 linguistic rules에 따라 corpus에서 Subject, Action, 그리고 Place phrases를 extract합니다.

data quality를 보장하기 위해, 우리의 framework는 frequency를 기반으로 각 범주에서 상위 N개의 phrases를 선택합니다. 또한 Subject 및 Place phrases에서 named entities를 제거하고 가장 빈번하게 발생하는 변형을 유지하여 유사한 표현(예: “a doctor”와 “the doctor”)을 통합함으로써 data를 추가로 정제합니다. 이 과정의 결과로 후속 처리를 위한 세 가지의 정제된 phrase lists가 생성됩니다.

Construct Counter-commonsense Query

우리는 다른 요소들(즉, context)과 거의 동시 발생하지 않는 단일한 변칙적 component(즉, target)를 가진 scenes를 구성하는 것을 목표로 합니다. 이 목표는 두 가지 주요 요구 사항으로 공식화될 수 있습니다: (1) Context components는 높은 수준의 동시 발생을 보여주어 일반적인 배경 역할을 해야 하며, (2) Target component는 주어진 context와 낮은 동시 발생을 보여주어 변칙을 나타내야 합니다. 강력하게 동시 발생하는 context pairs를 식별하기 위해, 우리의 framework는 먼저 target 범주별로 context components를 그룹화합니다. 예를 들어, ContextAction은 (Subject, Place) pairs로 구성됩니다. 이러한 그룹화는 다음 섹션에서 질문의 초점을 개발하는 데 도움이 됩니다. 우리는 모호성을 방지하고 주체 정체성과 관련된 잠재적인 윤리적 문제를 완화하기 위해 ContextSubject를 생략합니다. 다음으로, 우리의 framework는 각 그룹 내의 모든 context 조합을 나열하고 그들의 Normalized Pointwise Mutual Information (NPMI) scores를 계산합니다.

더 높은 NPMI score는 두 components 간의 더 강력한 동시 발생을 나타냅니다. 각 context group에 대해, framework는 가장 높은 NPMI scores를 가진 Top-K context pairs를 선택하여 candidate pool을 형성합니다. pool의 각 context pair에 대해, framework는 context가 주어졌을 때 특이한 target component를 선택하여 counter-commonsense triplets를 generate합니다. 구체적으로, framework는 NPMI score(즉, $NPMI(T; C)$)를 사용하여 각 target $T$와 context pair $C$ 사이의 동시 발생을 evaluate합니다. 각 context pair에 대해, 가장 낮은 NPMI scores를 가진 Top-M targets가 유지되어 counter-commonsense queries를 구성합니다. model knowledge를 더 잘 정렬하기 위해, framework는 large-scale web data로 trained된 LLM에 쿼리하여 확률 $P(\cdot)$를 추정하고, quality를 보장하기 위해 쿼리 generation 이후 수동 검토가 수행됩니다.

Generate Multimodal Inputs

구성된 queries를 바탕으로, 우리의 framework는 Yes-No, Multiple-Choice, 그리고 Open-Ended라는 세 가지 유형의 questions를 해당 answers와 함께 generate합니다. 이를 달성하기 위해, framework는 미리 정의된 question templates를 사용하고 관련 components를 적절하게 채웁니다. Example question-answer pairs는 Table 1에 제공됩니다. 해당하는 images를 generate하기 위해, 우리의 framework는 triplet components를 caption과 같은 표현으로 연결하고 Figure 2에 설명된 대로 text-to-image model에 쿼리하기 위해 prompt template을 사용합니다. image generation 후, human annotators는 왜곡되어 보이거나 input prompt와 정렬되지 않은 것과 같은 low-quality images를 필터링하여 quality control을 수행합니다.

3.2 CONFLICTVIS Benchmark Construction

우리는 CONFLICTVIS를 구축하기 위해 automated framework를 어떻게 사용하는지 제시합니다. 우리의 input corpus는 Open Mind Common Sense (OMCS) dataset의 상위 100K 문장으로 구성됩니다. 이 dataset에서 우리는 100개의 가장 빈번한 Subject phrases ($N_{S} = 100$)와 150개의 가장 빈번한 Action 및 Place phrases ($N_{A} = N_{P} = 150$)를 extract하여 유지합니다. LLM Vicuna-1.5-13b의 피드백을 사용하여, 우리는 가장 높은 NPMI scores를 가진 상위 3개의 phrases ($K = 3$)를 선택하여 각 subject에 대한 context pairs를 생성합니다. 다음으로, 각 context pair에 대해, 우리는 가장 낮은 NPMI scores를 가진 상위 3개의 targets ($M = 3$)를 선택하여 counter-commonsense triplets의 candidate set을 조립합니다. 예상치 못한 조합을 수동으로 필터링한 후, 남은 triplets는 image generation을 위해 DALL·E 3에 쿼리하는 데 사용됩니다. 이후에, human annotators가 검토하여 low-quality images를 제거합니다. 이 2단계의 generation 및 필터링 과정에 이어, 최종 benchmark의 statistics가 Table. 2에 요약되어 있습니다. 전체적으로, CONFLICTVIS는 human experts가 모두 검증한, 두 개의 conflict targets와 세 가지 question types에 걸친 1,122개의 test samples를 포함합니다.

📝 3 CONFLICTVIS Benchmark 정리 노트 (AI 연구자 요약용)

1. 핵심 개념: 상식 지식의 구조화 (Triplet Representation)

- 일상적인 상식(Commonsense knowledge)을 $\langle s, a, p \rangle$ 형태의 Triplet으로 포맷팅.

- $s$ (Subject): 메인 객체의 외형.

- $a$ (Action): 주요 활동 및 상호작용.

- $p$ (Place): 배경 및 세팅.

- 예시: $\langle$the waitress, washing dishes, in the kitchen$\rangle$

2. 자동화 파이프라인 3단계 (Automated Framework)

이 프레임워크는 '의도적으로 동시 발생 확률이 낮은(low co-occurring) 개념들의 조합'을 수학적으로 구성하여 counter-commonsense 상황을 시뮬레이션함.

- Stage 1. 지식 요소 추출 (Extract Knowledge Components):

- Transformer NLP 파이프라인을 통해 말뭉치(Corpus)의 구문 레이블(DEP, POS, NE)을 분석.

- 빈도수 기반으로 최상위 Subject, Action, Place 구문 추출 후 정제(Named Entity 제거, 유사 표현 병합).

- Stage 2. 상식 위배 쿼리 구성 (Construct Counter-commonsense Query):

- NPMI (Normalized Pointwise Mutual Information) 수식을 핵심 지표로 활용.

- Context Pair 생성: 특정 타겟(예: Action)을 제외한 나머지 두 요소(Subject + Place) 중 NPMI 점수가 가장 높은(자주 함께 등장하는) 조합을 묶어 기본 배경(Context)으로 설정.

- Target 결합: 위에서 만든 Context Pair와 NPMI 점수가 가장 낮은(거의 함께 등장하지 않는) 변칙적인 Target 요소를 결합하여 최종 쿼리 생성.

- 이후 대규모 LLM을 통해 해당 조합의 확률을 추정하고 인간의 수동 검토(Human-in-the-loop)를 거쳐 퀄리티 컨트롤.

- Stage 3. 멀티모달 입력 데이터 생성 (Generate Multimodal Inputs):

- 만들어진 Triplet을 하나의 프롬프트로 연결하여 Text-to-Image 모델(DALL-E 3)로 이미지 생성.

- 동시에 정해진 템플릿에 맞추어 3가지 유형의 평가 프롬프트(Yes-No, Multiple-Choice, Open-Ended)를 자동 생성.

- 생성된 이미지의 왜곡이나 프롬프트 정렬 불량 등을 인간 어노테이터가 최종 필터링.

3. CONFLICTVIS 벤치마크 구축 결과 (Dataset Statistics)

- 소스 데이터: Open Mind Common Sense (OMCS) 데이터셋의 상위 100K 문장 활용.

- LLM & T2I 도구: Vicuna-1.5-13b (Context 생성 피드백), DALL-E 3 (이미지 생성).

- 최종 스펙: * 인간 전문가의 검증을 통과한 총 374장의 고품질 원본 이미지.

- Action 충돌과 Place 충돌이라는 2개의 타겟을 다룸.

- 3가지 질문 유형을 결합하여 총 1,122개의 테스트 샘플(QA Pairs) 완성.

💡 쉬운 설명 : 3 CONFLICTVIS Benchmark

이번 섹션은 **"어떻게 하면 AI를 완벽하게 속일 수 있는 '상식 파괴 사진과 문제'를 자동으로 대량 생산할 수 있을까?"**에 대한 연구진의 레시피를 설명하고 있습니다.

연구진은 문장을 만드는 공식을 **"누가(Subject), 무엇을(Action), 어디서(Place)"**라는 세 가지 블록(Triplet)으로 나누었습니다.

- 가장 친한 단어 찾기 (배경 만들기):

- 먼저 빅데이터를 뒤져서 아주 자연스러운 조합을 찾습니다. 예를 들어, 수학적인 계산(NPMI라는 공식)을 돌려보니 **"웨이트리스(누가)"**와 **"주방(어디서)"**은 아주 자주 같이 나오는 '찰떡궁합'이라는 것을 알아냅니다. 이렇게 자연스러운 무대를 먼저 세팅합니다.

- 가장 안 어울리는 단어 끼워 넣기 (함정 파기):👉 결과물: "주방에서 서류를 결재하는 웨이트리스"

- 그다음, 이 "주방에 있는 웨이트리스"라는 자연스러운 상황에 가장 뜬금없는 행동을 수학적으로 계산해서 찾아냅니다. 계산 결과, **"서류 결재하기(무엇을)"**라는 행동이 이 상황과 최악의 궁합(가장 점수가 낮음)이라는 것을 확인하고 이를 합쳐버립니다.

- 그림 그리고 시험지 인쇄하기:

- 이렇게 만든 황당한 문장을 그림 그리는 AI(DALL-E 3)에게 주어서 진짜 사진처럼 만들게 합니다. 그리고 이 사진을 바탕으로 "웨이트리스가 서명하고 있니?(O/X)", "웨이트리스가 뭐 하니?(주관식)" 같은 3가지 종류의 질문을 자동으로 만들어냅니다. 중간중간 이상한 그림이 나오면 사람이 직접 검수해서 빼버립니다.

결과적으로 이 똑똑한 자동화 공장을 돌려서, AI의 시력과 상식을 테스트할 수 있는 **아주 정교한 1,122개의 함정 문제집(CONFLICTVIS)**을 완성했다는 내용입니다.

평점 3점 / 5점

"MLLM의 내재된 텍스트 편향성이 시각 정보를 압도하는 현상을 날카롭게 진단하고 독창적인 자동화 벤치마크를 구축한 공로는 크나, 근본적인 모델 구조나 학습 방법론의 개선 없이 단순 프롬프트 처방에 머문 점이 아쉬운 진단형 논문."