AI바라기의 인공지능

Video : 논문 리뷰 : VideoTitans: Scalable Video Prediction with Integrated Short- and Long-term Memory 본문

Video : 논문 리뷰 : VideoTitans: Scalable Video Prediction with Integrated Short- and Long-term Memory

AI바라기 2026. 2. 3. 17:56

Video Titans: Scalable Video Prediction with Integrated Short- and Long-term Memory - 학습 노트

Terminology

이 논문을 이해하기 위해 필요한 핵심 전문 용어 정리:

- Gradient-based Surprise: Titans 아키텍처의 핵심 개념입니다. 데이터가 모델의 예상과 얼마나 다른지(Loss gradient)를 측정하여, 이 값이 클 때(놀라움이 클 때)만 정보를 Neural Memory에 저장하는 메커니즘입니다. 인간이 평범한 일상은 잊고 충격적이거나 새로운 사건만 기억하는 방식과 유사합니다.

- Neural Memory: 기존의 고정된 버퍼나 단순한 Hidden State가 아니라, 학습 가능한 파라미터를 통해 데이터를 동적으로 저장하고 검색하는 신경망 기반의 메모리 모듈입니다.

- Persistent Memory: 입력 데이터(Input)에 의존하지 않고, 학습 과정에서 고정된 task-specific한 사전 지식(Prior)을 저장하는 학습 가능한 토큰들입니다.

- Sliding Window Attention: 전체 시퀀스를 한 번에 보는 Global Attention 대신, 윈도우를 밀면서 국소적인 범위만 Attention을 수행하여 계산 복잡도를 선형(Linear)으로 줄이는 기법입니다.

- Memory as a Gate (MAG): Short-term memory (Attention 결과)와 Long-term memory (Neural Memory 결과)를 Gating 메커니즘을 통해 동적으로 결합하는 통합 전략입니다.

Purpose of the Paper

이 연구는 Video Prediction 분야에서 기존 아키텍처들이 가진 Efficiency-Accuracy Trade-off 문제를 해결하기 위해 시작되었습니다.

- 기존 연구의 한계:

- RNN/CNN 기반 모델: Local dynamics는 잘 잡지만, Receptive field의 제한과 Vanishing gradient 문제로 인해 Long-term dependency를 학습하지 못함.

- Transformer 기반 모델: Global Attention을 사용하여 Long-term 성능은 좋지만, 비디오 길이나 해상도가 커질수록 계산 비용이 Quadratic하게 증가하여 고해상도/장기 예측에 부적합함.

- 새로운 접근: NLP 분야에서 제안된 Titans (Gradient-driven memory) 아키텍처를 비디오 도메인에 최초로 도입하여, Linear complexity를 유지하면서도 고해상도 비디오의 장기 의존성을 효과적으로 학습하는 VideoTitans를 제안합니다.

Key Contributions

이 논문의 핵심 기여와 Novelty는 구조적 효율성과 메모리 메커니즘의 융합에 있습니다.

- Adaptation of Titans to Video (Novelty):

- NLP를 위해 설계된 Titans의 Gradient-based Surprise 메커니즘을 최초로 Spatio-temporal Video Prediction 태스크에 적용했습니다. 이는 비디오 내의 Redundant한 프레임은 무시하고, 갑작스러운 움직임이나 변화(Surprise)만 선택적으로 기억하게 합니다.

- Unified Memory-Attention Architecture:

- 다음 세 가지 요소를 하나의 Gating Mechanism으로 통합하여 End-to-End로 학습 가능한 구조를 제안했습니다.

- Sliding Window Attention: Short-term dependency를 처리하며 계산 복잡도를 Linear하게 유지.

- Episodic Memory (Neural Memory): Gradient 기반으로 중요한 사건만 저장하여 Long-term dependency 해결.

- Persistent Memory: 입력과 무관한 정적 정보를 토큰 형태로 주입하여 학습 안정화 및 일반화 성능 향상.

- 다음 세 가지 요소를 하나의 Gating Mechanism으로 통합하여 End-to-End로 학습 가능한 구조를 제안했습니다.

- Scalability & Efficiency:

- Global Attention의 Quadratic 연산 비용을 제거하여, 긴 시퀀스와 고해상도 데이터에서도 FLOPs를 획기적으로 낮추면서 SOTA 급 성능을 유지했습니다.

Experimental Highlights

실험은 다양한 특성의 데이터셋을 통해 모델의 범용성과 효율성을 입증했습니다.

- Datasets: Moving MNIST (단순 비선형), TrafficBJ (복잡한 도시 교통), Human3.6M (세밀한 인간 동작), WeatherBench (대규모 기상 예측).

- Efficiency vs Performance:

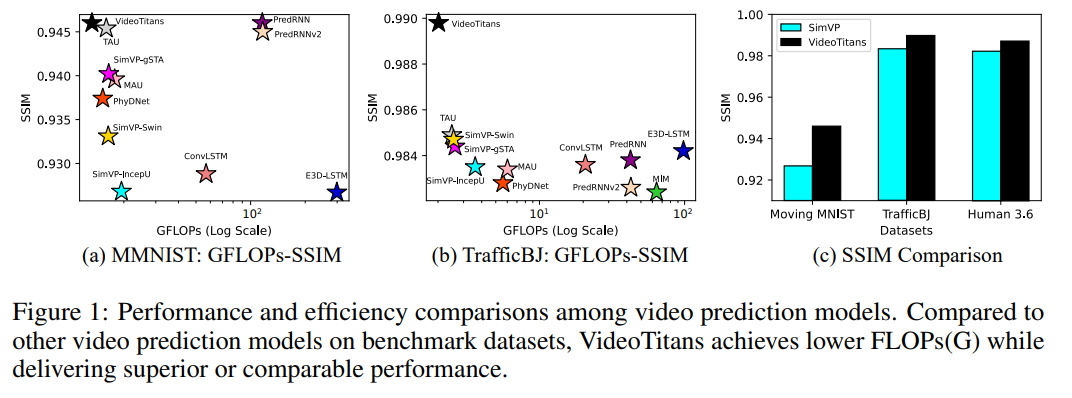

- Moving MNIST 및 TrafficBJ에서 SimVP, PredRNN 등 기존 SOTA 모델 대비 현저히 낮은 FLOPs (연산량)로 동등하거나 더 높은 SSIM (구조적 유사도)을 달성했습니다.

- WeatherBench (기상 예측) 실험에서 PredRNNv2, ViT보다 구름의 패턴(tcc)을 더 정확하게 예측하며 Global spatio-temporal interaction을 잘 포착함을 증명했습니다.

- Component Ablation:

- Persistent Memory 유무에 따라 MSE 성능 차이가 발생 (23.5 -> 21.3)하며, 이 모듈이 모델의 예측 정확도에 중요한 역할을 함을 검증했습니다.

- Memory Integration: MAG (Memory as a Gate) 방식이 Context나 Layer 방식보다 성능이 우수함을 확인했습니다.

Limitations and Future Work

논문은 아키텍처의 잠재력과 함께 명확한 실험적/구조적 한계를 제시합니다.

- Hyperparameter Sensitivity (Critical Limitation):

- Neural Memory Depth가 2를 초과하면 학습이 불안정해지고 수렴하지 않는 현상이 발생합니다. 또한 Gradient Norm Constraint와 같은 하이퍼파라미터 튜닝에 매우 민감합니다. 이는 모델의 구조적 안정성을 위해 해결해야 할 과제입니다.

- Prediction vs Generation:

- 본 연구는 Predictive Model에 집중했기에, 최근 유행하는 Diffusion Model (Generative Model)과의 직접적인 생성 품질 비교는 수행하지 않았습니다.

- Future Work:

- Diffusion과의 결합: Diffusion의 고품질 생성 능력과 VideoTitans의 효율적인 장기 기억 능력을 결합하는 방향.

- Task 확장: 단순 프레임 예측을 넘어 Action Recognition, Anomaly Detection 등 더 넓은 Vision Task로의 확장.

- Stability Improvement: 더 깊은 레이어에서도 안정적으로 학습할 수 있도록 메모리 모듈 구조 개선.

Overall Summary

이 논문은 NLP의 Titans 아키텍처를 비디오 예측에 맞게 재설계한 VideoTitans를 제안합니다. 이 모델은 Sliding Window Attention (단기 기억), Gradient-based Neural Memory (장기 기억), Persistent Memory (사전 지식)를 결합하여, 기존 Transformer의 과도한 연산 비용 문제와 RNN의 장기 기억 소실 문제를 동시에 해결했습니다. 결과적으로 적은 연산량(FLOPs)으로도 Long-term Video Prediction에서 SOTA급 성능을 달성했으며, 이는 자원이 제한된 환경(자율 주행, 로보틱스 등)에서의 실시간 비디오 예측 시스템 구축에 중요한 기여를 할 수 있습니다.

쉬운 설명

VideoTitans의 핵심 아이디어는 **"똑똑한 벼락치기 공부법"**과 비슷합니다.

- Sliding Window (단기 기억): 시험 직전에 바로 앞 페이지 내용을 훑어봅니다. (최근 프레임 확인)

- Persistent Memory (기본 실력): 평소에 알고 있던 기본 공식이나 상식은 책을 안 봐도 이미 머릿속에 있습니다. (변하지 않는 배경 지식)

- Gradient-based Surprise (핵심 요약): 책의 모든 내용을 다 외우는 건 불가능합니다(기존 Transformer의 문제). 그래서 공부하다가 "어? 이건 몰랐던 건데?" 하고 놀랄 만큼 중요한 내용(Surprise)만 골라서 노트(Memory)에 적어둡니다. 뻔한 내용은 적지 않습니다.

이렇게 하면 뇌 용량(메모리)을 적게 쓰면서도, 시험(미래 프레임 예측)을 아주 잘 볼 수 있게 됩니다.

Abstract

정확한 video forecasting은 autonomous vehicles가 위험을 예상하고, robotics 및 surveillance systems가 인간의 의도를 predict하며, environmental models가 기상 이변에 대해 적시에 경보를 발령할 수 있게 합니다.

그러나 기존 methods는 한계가 있습니다. Transformers는 quadratic complexity를 가진 global attention에 의존하므로, high-resolution 및 long-horizon video prediction에 비실용적입니다. 반면 convolutional 및 recurrent networks는 짧은 범위의 receptive fields와 vanishing gradients로 어려움을 겪으며, 확장된 sequences에서 핵심 정보를 잃게 됩니다.

이러한 과제를 극복하기 위해, 우리는 원래 language modelling을 위해 설계된 gradient-driven Titans memory를 video prediction에 적용한 최초의 architecture인 VideoTitans를 소개합니다.

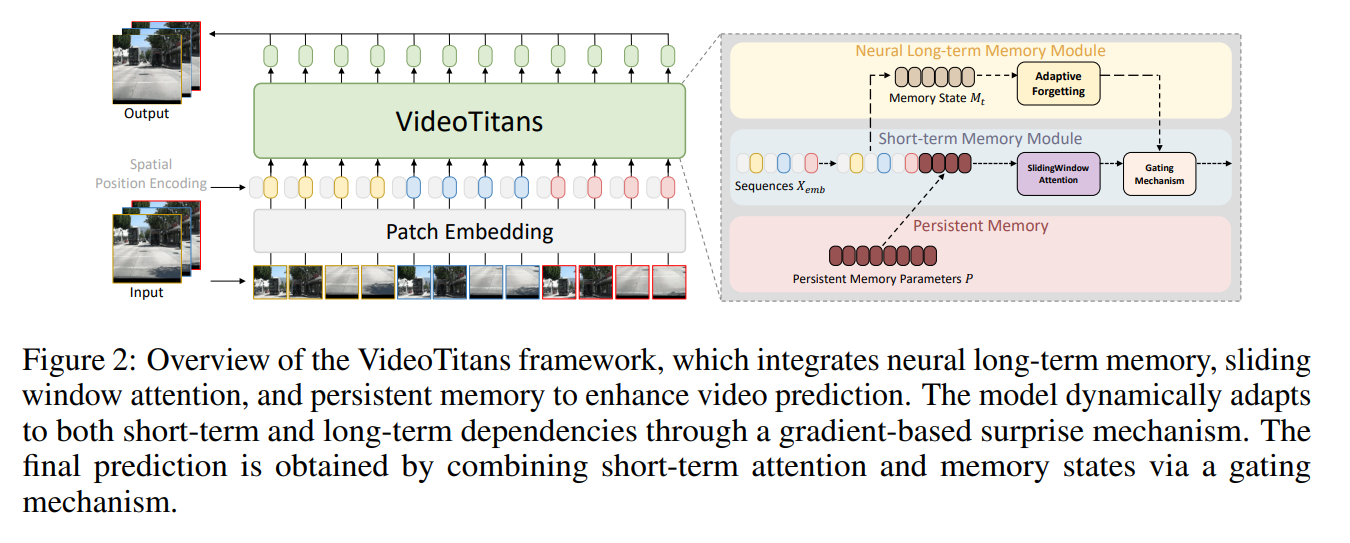

VideoTitans는 세 가지 핵심 ideas를 통합합니다: (i) Sequence length 및 spatial resolution에 따라 선형적으로 확장되는 sliding-window attention core, (ii) Gradient-based surprise signal에 기초하여 유익한 tokens만을 동적으로 유지하는 episodic memory, (iii) Training을 안정화하고 generalization을 향상시키는 task-specific priors를 인코딩하는 소수의 persistent tokens입니다.

Moving-MNIST, Human3.6M, TrafficBJ 및 WeatherBench benchmarks에 대한 광범위한 실험은 VideoTitans가 state-of-the-art인 recurrent, convolutional 및 efficient-transformer methods와 비교하여 computation(FLOPs)을 지속적으로 줄이고 경쟁력 있는 visual fidelity를 달성함을 보여줍니다. 포괄적인 ablations는 제안된 각 component가 중요하게 기여함을 확인해 줍니다.

1 Introduction

정확한 video forecasting은 autonomous driving, city-scale surveillance, robotics, 그리고 weather forecasting과 같은 중요한 실제 systems에서 선제적인 의사결정을 가능하게 합니다. 미래의 video frames를 예측하는 것은 섬세한 균형을 요구합니다: model은 frames 사이의 빠르고 미세한 변화를 정확하게 포착해야 하면서도, 확장된 time horizons에 걸쳐 중요한 events와 scene dynamics에 대한 memory를 유지해야 합니다. 전통적인 접근 방식들은 convolutional 또는 recurrent architectures에 크게 의존하는데, 이는 local dynamics를 효과적으로 처리하지만 limited receptive fields와 vanishing gradients로 인한 문제에 직면하며, 이는 long sequences에서의 performance를 심각하게 제한합니다.

최근의 transformer-based architectures는 long-range dependencies를 포착하기 위해 global self-attention을 채용함으로써 이러한 한계를 해결합니다. 그러나 이는 quadratic computational complexity라는 엄청난 비용을 수반하며, 현실적인 high-resolution, long-sequence applications에서는 실행 불가능하게 만듭니다. 이러한 computational bottleneck을 우회하려는 시도들—예를 들어 hierarchical window attention, low-rank approximation, 또는 external memory—은 엄격한 architectural constraints와 task-specific heuristics를 도입하여, 다양한 forecasting scenarios 전반에 걸친 generalizability와 flexibility를 제한합니다.

대안적인 접근 방식은 최근 natural-language processing의 발전에서 등장했습니다. Gradient-driven episodic memory module인 Titans는 loss gradient가 상당한 "surprise"를 신호할 때만 정보를 선택적으로 memory에 저장하는데, 이는 인간이 예상치 못하거나 새로운 events를 기억하는 경향에서 동기를 얻은 mechanism입니다. 이 memory mechanism은 video prediction tasks와 자연스럽게 일치합니다. 여기서는 중복되는 frame sequences가 지배적이며, 갑작스러운 object movements나 급격한 camera motions와 같은 중요한 드문 events가 간헐적으로 발생합니다. 그러나 Titans를 video forecasting에 직접 적용하는 것은 간단하지 않습니다(non-trivial): high-resolution frames를 처리하는 것은 memory complexity를 상당히 팽창시키고, 표준 transformer attention은 여전히 computational bottleneck으로 남아있으며, visual forecasting은 episodic memory만으로는 제공할 수 없는 학습된 static priors로부터 큰 이점을 얻기 때문입니다.

본 논문에서는 Titans gradient-driven memory를 dense video forecasting domain에 성공적으로 적용한 최초의 architecture인 VideoTitans를 소개합니다. VideoTitans는 독창적으로 세 가지 핵심 components를 통합된 computationally efficient framework로 결합합니다: (i) sequence length 및 spatial resolution에 따라 복잡도가 선형적으로 증가하는 lightweight sliding-window attention core, (ii) 놀라운(surprising) patch tokens를 선택적으로 인코딩하는 gradient-based episodic memory, 그리고 (iii) input-agnostic하고 재사용 가능한 priors를 prediction pipeline에 주입하는 소수의 persistent tokens입니다. 이러한 modules의 상호작용은 단일 gating mechanism에 의해 매끄럽게 조정되어, 수동으로 조정된 heuristics에 의존하지 않고 predictor가 end-to-end differentiable 상태를 유지하도록 보장합니다.

우리는 다양하고 도전적인 benchmarks—Moving-MNIST, Human3.6M, TrafficBJ, 그리고 WeatherBench—에 대해 광범위한 평가를 수행하여, VideoTitans가 state-of-the-art recurrent, convolutional, 그리고 efficient-transformer methods와 비교했을 때 long-range forecasts에서 뛰어난 visual fidelity를 제공하면서도 computational load를 지속적으로 줄인다는 것을 입증합니다. 우리의 포괄적인 ablation studies는 제안된 각 component가 이러한 performance를 달성하는 데 필수적임을 추가로 검증합니다. 후속 research를 촉진하고 완전한 reproducibility를 보장하기 위해, 우리는 source code, trained checkpoints, 그리고 demonstration videos를 공개적으로 배포할 것입니다.

Contributions

- 우리는 gradient-driven Titans memory가 quadratic computational growth를 초래하지 않고 긴 high-resolution video sequences에 적용될 수 있음을 증명하며, language를 넘어선 그 유효성에 대한 최초의 cross-domain evidence를 제공합니다.

- 우리는 단일 gating mechanism 뒤에서 sliding-window attention, episodic memory, 그리고 persistent priors를 결합하여 efficiency와 temporal coverage의 균형을 맞추는 통합된 memory–attention architecture를 제시합니다.

- Moving-MNIST, Human3.6M, TrafficBJ 및 WeatherBench에 대한 광범위한 실험은 state-of-the-art recurrent, convolutional 및 efficient-transformer baselines에 비해 computation의 지속적인 감소와 long-range visual fidelity의 향상을 보여주며, ablation studies는 VideoTitans의 모든 component가 필수불가결함을 확인해 줍니다.

📝 1. Introduction 핵심 정리 노트 (for AI Researchers)

1. Background & Problem Definition

- Goal: Accurate video forecasting (필수 분야: autonomous driving, robotics, weather forecasting 등).

- Core Challenge: 짧은 구간의 rapid changes와 긴 시간 범위의 scene dynamics/memory를 동시에 포착해야 함.

- Limitations of Existing Methods:

- CNN / RNN: Local dynamics 처리에 강하지만, limited receptive fields와 vanishing gradients 문제로 Long-sequence 처리에 실패.

- Standard Transformers: Global self-attention을 통해 Long-range dependencies를 해결했으나, Quadratic complexity로 인해 High-resolution 및 Long-sequence에서 연산 비용이 비현실적으로 높음.

- Efficient Transformers: Hierarchical window attention 등의 시도가 있었으나, rigid architectural constraints와 task-specific heuristics 때문에 Generalizability가 떨어짐.

2. Key Insight: Titans (NLP) to Video

- Inspiration: NLP의 Titans (Gradient-driven episodic memory) 모델.

- Mechanism: Loss gradient가 큰 "surprise" (예상치 못한 정보)가 발생할 때만 선택적으로 Memory에 정보를 저장.

- Video Domain Fit: 비디오 데이터의 특성(대부분 중복된 프레임 + 간헐적인 rare events/surprise)과 잘 맞음.

- Adaptation Challenge: 단순 적용 시 High-resolution 영상 처리의 Memory 복잡도 증가 및 Visual forecasting에 필요한 static priors 부재 문제 발생.

3. Proposed Architecture: VideoTitans 세 가지 핵심 Components를 Single gating mechanism으로 통합하여 End-to-end differentiable한 구조를 완성.

- (i) Sliding-window Attention Core (Efficiency)

- Sequence length와 Spatial resolution에 대해 연산량이 Linearly하게 증가하는 Lightweight 구조.

- (ii) Gradient-based Episodic Memory (Dynamic Context)

- Gradient signal을 기반으로 "Surprising"한 patch tokens만 선별적으로 저장 (인간의 기억 메커니즘 모방).

- (iii) Persistent Tokens (Static Priors)

- 입력과 무관하게(Input-agnostic) 유지되는 소수의 Tokens.

- Video prediction에 필수적인 고정된 패턴이나 규칙(Priors)을 주입하여 Training 안정화 및 Generalization 강화.

4. Contributions & Performance

- Cross-domain Evidence: Language 모델의 Gradient-driven memory가 Vision(Video) 도메인에서도 유효함을 최초 입증.

- SOTA Achievement: Moving-MNIST, Human3.6M, TrafficBJ, WeatherBench 벤치마크에서 기존 Recurrent, Convolutional, Efficient-transformer 모델 대비 FLOPs(연산량)는 줄이고 Visual fidelity는 향상.

💡 쉬운 설명 : "놀라운 것만 기억하고, 기본기는 몸에 익힌다"

이 논문의 Introduction 섹션은 비디오 예측(다음 장면 맞추기)을 잘하기 위해 인간의 기억법을 AI에 적용한 내용을 다루고 있습니다.

1. 기존 AI들의 문제점 (딜레마)

- RNN/CNN 파: 눈앞의 변화는 잘 보는데, 건망증이 심해서 예전 내용을 까먹습니다.

- Transformer 파: 기억력은 천재적인데, 모든 순간을 다 기억하려다 보니 머리가 터져서(계산량 폭발) 긴 영상은 처리를 못 합니다.

2. VideoTitans의 해결책 이 논문은 **"VideoTitans"**라는 모델을 제안합니다. 핵심은 **"효율적인 기억 관리"**입니다. 비디오는 대부분 비슷한 장면(중복)이고, 갑자기 공이 튀거나 차가 끼어드는 "놀라운 순간"은 드물다는 점에 착안했습니다.

VideoTitans는 다음 세 가지를 동시에 수행합니다:

- Sliding Window (현재 집중): 일단 지금 당장 눈앞의 흐름을 봅니다.

- Episodic Memory (충격 요법): 평범한 건 흘려보내고, 예측이 크게 틀리거나 놀라운 장면(Surprise)이 나올 때만 그 정보를 뇌(메모리)에 깊게 박습니다. (공부할 때 틀린 문제만 오답 노트 만드는 것과 비슷함)

- Persistent Tokens (기본 소양): "중력은 아래로 작용한다"처럼 매번 배울 필요 없는 고정된 법칙들은 미리 따로 챙겨둡니다.

결론: 이렇게 하니 계산 비용(FLOPs)은 확 줄어들면서도, 중요할 때 기억을 잘 꺼내 써서 기존 최고 성능 모델들보다 영상을 더 잘 예측했다는 내용입니다.

2 Related Works

2.1 Memory in RNNs and Transformers

Recurrent neural networks (RNNs)와 그 variants인 Long Short-Term Memory (LSTM) 및 Gated Recurrent Units (GRU)는 video prediction에서 sequential dependencies를 모델링하는 데 널리 사용되어 왔습니다. 이러한 architectures는 internal memory를 활용하여 과거 정보를 유지함으로써, long-range dependencies를 포착할 수 있게 합니다.

그러나 이들은 vanishing gradients와 sequential processing constraints로 인해 어려움을 겪으며, 이는 long video sequences에 대한 scalability를 제한합니다. Memory retention을 개선하기 위해 다양한 개선 사항들이 제안되었지만, RNN-based 접근 방식들은 high-dimensional spatio-temporal modeling에 있어 여전히 computationally inefficient합니다.

Transformer-based architectures는 self-attention mechanisms를 통해 long-term dependencies를 모델링하는 능력으로 명성을 얻었으며, 이를 통해 parallelized sequence processing을 가능하게 합니다. 그러나 standard attention은 sequence length에 따라 quadratically하게 확장되므로, long video sequences에는 비실용적입니다.

이 문제를 해결하기 위해, memory-augmented transformers는 external memory를 통합하여 key representations를 저장하고 검색함으로써, global contextual information을 보존하면서 computational overhead를 줄입니다. 이러한 개선에도 불구하고, retrieval efficiency와 dynamic dependencies에 대한 adaptability에는 여전히 과제가 남아 있습니다.

우리의 연구는 중요한 과거 정보를 선택적으로 유지하는 neural long-term memory module을 도입하여 이러한 발전을 기반으로 하며, video forecasting을 위한 efficiency와 predictive robustness를 모두 향상시킵니다.

2.2 Video Prediction

Video prediction은 복잡한 spatio-temporal dependencies를 모델링하여 과거에 관찰된 frames를 기반으로 future frames를 예측하는 것을 포함합니다. ConvLSTM은 spatial 및 temporal contexts를 공동으로 포착하기 위해 convolutional recurrent units를 도입했으나 long-term stability에 어려움을 겪었습니다.

PredRNN과 그 variants는 추가적인 spatio-temporal memory units를 통합하여 temporal modeling을 상당히 개선했지만, 상당한 computational overhead를 수반했습니다. E3D-LSTM은 3D convolutions를 통합하여 performance를 더욱 향상시켰지만, 여전히 computationally demanding했습니다. PhyDNet은 motion dynamics를 더 잘 표현하기 위해 physical constraints를 활용했지만, 매우 복잡한 scenarios를 모델링하는 데에는 한계가 있었습니다.

SimVP는 spatial-temporal separable architectures를 채용하여 performance와 computational efficiency의 균형을 맞춤으로써 prediction model을 크게 단순화했습니다. 이를 바탕으로, SimVPmeta는 recurrent, convolutional, 및 transformer-based architectures를 통합된 meta-model framework로 결합하여 SimVP를 확장함으로써 video prediction 분야를 크게 발전시켰습니다. 이 연구에 이어, autoregressive-based model은 유망한 방향으로 문헌을 더욱 풍부하게 했습니다.

이러한 발전에서 영감을 받아, 본 논문은 long-term 및 short-term memory 능력을 모두 향상시키도록 특별히 설계된 새로운 Titans-based architecture인 VideoTitans를 처음으로 소개하며, 이를 통해 video prediction tasks의 중요한 과제들을 해결합니다.

📝 2. Related Works 핵심 정리 노트 (for AI Researchers)

1. Evolution of Memory Architectures (RNNs $\rightarrow$ Transformers)

- RNN/LSTM/GRU (The Past):

- Role: Internal memory를 통해 Sequential dependencies를 모델링.

- Bottleneck: Vanishing gradients 및 Sequential processing 한계로 인해 Long video sequences 확장이 어려움. High-dimensional data 처리에 Computationally inefficient.

- Standard Transformers (The Shift):

- Role: Self-attention을 통한 Global context 파악 및 Parallel processing 가능.

- Bottleneck: Sequence length에 대한 Quadratic complexity ($O(N^2)$)로 인해 Long video에 비실용적.

- Memory-augmented Transformers (The Attempt):

- Approach: External memory를 도입하여 Computational overhead 감소 시도.

- Limitation: 여전히 Retrieval efficiency와 Dynamic dependencies에 대한 Adaptability가 해결 과제로 남음.

- VideoTitans' Positioning: 기존 한계를 넘어, 과거 정보를 "선택적(Selectively)"으로 유지하는 Neural long-term memory module 도입.

2. Progress in Video Prediction Models

- Early Stage (Complex & Heavy):

- ConvLSTM: Spatial & Temporal context 결합 시도 $\rightarrow$ Long-term stability 부족.

- PredRNN variants: Spatio-temporal memory units 추가로 성능 향상 $\rightarrow$ 과도한 Computational overhead.

- E3D-LSTM / PhyDNet: 3D convolutions나 Physical constraints 도입 $\rightarrow$ 연산량 과다 혹은 복잡한 시나리오 대응 한계.

- Modern Stage (Efficient & Simplified):

- SimVP: Spatial-temporal separable architectures를 도입하여 모델 단순화 및 Efficiency 확보.

- SimVPmeta: Recurrent, Convolutional, Transformer 구조를 통합한 Meta-model framework로 확장.

- New Proposal (VideoTitans):

- SimVP 등의 발전 흐름을 이어받아, 최초로 NLP의 Titans architecture를 비디오 도메인에 적용.

- Long-term & Short-term memory 능력을 동시에 강화하여 Video prediction의 핵심 난제 해결.

💡 쉬운 설명 : "비디오 예측 모델의 역사와 진화"

이 섹션은 비디오 예측 기술이 어떻게 발전해 왔고, 왜 이 논문의 VideoTitans가 필요한지를 설명합니다.

1. 기억력 싸움: 멍청하거나, 너무 과하거나

- RNN/LSTM (구세대): 마치 벼락치기 공부와 같습니다. 방금 본 건 잘 기억하는데, 책의 앞부분 내용은 까먹습니다(Vanishing gradients). 게다가 고화질 영상(High-dimensional)을 처리하기엔 머리 회전이 느립니다.

- Transformer (신세대): 책의 모든 글자를 토씨 하나 안 틀리고 다 외우려는 천재입니다. 문제는 영상이 길어지면 외울 게 기하급수적으로 늘어나서(Quadratic complexity), 뇌 과부하로 쓰러집니다.

- 메모리 추가형 (절충안): 외부 노트를 따로 만들어서 적어가며 보게 시켰지만, 노트를 뒤적거리는 속도(Retrieval efficiency)가 느리고 상황 변화에 유연하지 못했습니다.

2. 비디오 예측 모델들의 계보

- 초기 모델들 (PredRNN 등): 성능은 좋았지만, 너무 무겁고 복잡했습니다. 마치 튼튼하지만 기름 많이 먹는 탱크 같았습니다.

- 최신 트렌드 (SimVP 등): "심플한 게 최고다"라며 구조를 단순화하고 효율을 높이는 쪽으로 발전했습니다. 이제 가볍고 빠른 스포츠카가 되었습니다.

3. VideoTitans의 등장

이 논문은 최신 트렌드(효율성)를 따르면서, 언어 모델(NLP)에서 쓰던 최신 기억법(Titans)을 처음으로 비디오에 이식했습니다. 즉, "가볍게 달리면서도, 중요한 건 절대 까먹지 않는" 완성형 모델을 만들겠다는 선언입니다.

3 Preliminaries

Memory and Sequence Modeling.

Video prediction과 같은 Sequential modeling tasks는 일반적으로 long-term temporal dependencies를 처리하는 것을 포함합니다. Recurrent neural networks (RNNs)는 이러한 dependencies를 압축된 hidden state로 encode하지만, 종종 longer sequences에 걸쳐 essential information을 잃습니다. 반면, Transformers는 attention을 사용하여 dependencies를 명시적으로 model하지만, 이는 quadratic complexity를 수반하여 videos와 같은 매우 long sequences에 대한 적용 가능성을 제한합니다.

Neural Memory and Adaptive Forgetting.

최근의 architectures는 immediate attention window를 넘어 historical context를 동적으로 저장하는 명시적인 neural memory modules를 도입합니다. 이러한 modules는 다음과 같은 recursive formulations를 통해 memory state $M_t$를 update합니다:

여기서 $f$는 adaptive forgetting mechanisms를 사용하여 redundant details를 버리면서 relevant information을 선택적으로 encode하는 memory update function을 나타냅니다. 이러한 adaptive mechanisms는 memory overflow 없이 long-term dependencies를 관리하는 데 중요합니다.

Titans Framework.

Titans는 crucial information을 동적으로 learn, memorize 및 retrieve하도록 특별히 설계된 neural memory module을 제안합니다. Titans는 events의 중요성을 결정하기 위해 gradient-based surprise mechanism을 정의합니다:

여기서 $S_t$는 historical (past) 및 immediate (momentary) surprise를 모두 capture합니다. 이를 통해 Titans는 동적으로 adapt하고 important events를 선택적으로 encode하여, short-term attention과 long-term memorization의 균형을 효과적으로 맞출 수 있습니다.

이 접근 방식에서 영감을 받아, 우리는 VideoTitans를 소개하여 Titans memory framework를 video forecasting tasks에 적용하고, video data에 내재된 local 및 global temporal dependencies의 효율적인 modeling을 가능하게 합니다.

📝 3. Preliminaries 핵심 정리 노트 (for AI Researchers)

1. Limitations of Standard Sequence Modeling

- RNNs: Hidden state 압축 과정에서 Long sequence의 정보 손실 발생.

- Transformers: Explicit attention을 사용하지만 Quadratic complexity로 인해 매우 긴 비디오 시퀀스(Very long sequences) 처리에 한계.

2. Neural Memory & Adaptive Forgetting

- Concept: Immediate attention window를 넘어선 Historical context를 저장하는 명시적인 Neural memory modules 도입.

- Mechanism: Recursive formulation을 따름.

- $$M_t = f(M_{t-1}, x_t)$$

- Adaptive Forgetting: 불필요한 세부 정보(Redundant details)는 버리고 관련 정보만 선택적으로 Encode하여 Memory overflow 방지.

3. The Core: Titans Framework (Gradient-based Surprise)

- Objective: 결정적인 정보(Crucial information)를 동적으로 Learn, Memorize, Retrieve하도록 설계.

- Surprise Mechanism: Loss gradient를 이용해 "놀라움(Surprise)"의 정도를 측정하고, 이를 기반으로 Event의 중요도 판단.

- Update Rule:

$$S_t = \eta_t S_{t-1} - \theta_t \nabla \ell(M_{t-1}; x_t)$$

- $S_t$: **Historical (past)**와 Immediate (momentary) surprise를 모두 포착.

- $\nabla \ell(\dots)$: Loss gradient를 통해 예측 실패(Surprise)가 큰 지점을 학습 신호로 사용.

-

$$M_t = M_{t-1} + S_t$$

- Benefit: Short-term attention과 Long-term memorization 사이의 균형을 동적으로 조절.

4. Adaptation to VideoTitans

- Titans의 Memory framework를 Video forecasting에 적용하여, 비디오 데이터 고유의 Local & Global temporal dependencies를 효율적으로 모델링하는 것이 본 논문의 핵심 접근법.

💡 쉬운 설명 : "놀라움(Surprise)으로 기억을 관리한다"

이 섹션은 VideoTitans가 작동하는 이론적 배경, 특히 **'Titans'**라는 기억 관리 기술의 핵심 원리를 설명합니다.

1. 기존 방식의 딜레마 (복습)

- RNN: 뇌 용량이 작아서 옛날 건 까먹음.

- Transformer: 모든 걸 다 기억하려다 머리가 터짐.

2. 해결책: "깜짝 놀랄만한 것만 기억하자" (Titans Framework)

Titans는 인간이 기억하는 방식을 모방한 수학적 모델입니다. 우리는 평범한 출근길은 기억 못 해도, 출근길에 차사고가 난 날은 생생히 기억합니다. 이것이 바로 Surprise(놀라움) 기반 학습입니다.

- Adaptive Forgetting (똑똑한 망각): 뇌 용량은 한정되어 있으므로 쓸데없는 정보는 스스로 지웁니다.

- Gradient-based Surprise (놀라움의 수치화):

- 모델이 다음 장면을 예측했는데 완전히 틀렸다? $\rightarrow$ "Surprise(충격)" 수치가 높음.

- 예측이 틀렸다는 건 그 장면이 특이하거나 중요하다는 뜻이므로, 그 정보를 메모리($M_t$)에 즉시 업데이트합니다.

- 수식 $S_t$는 "과거에 놀랐던 것"과 "방금 놀란 것"을 합쳐서 현재의 중요도를 결정합니다.

결론: VideoTitans는 무작정 모든 비디오 프레임을 외우는 게 아니라, **"예측이 빗나간(놀라운) 중요한 순간"**들 위주로 기억을 업데이트하여, 긴 영상도 효율적으로 처리한다는 이론입니다.

4 Methodology

4.1 Problem Definition.

$T$개의 observed frames로 구성된 input video sequence $X \in \mathbb{R}^{B \times T \times C \times H \times W}$가 주어질 때, video forecasting의 목표는 이어지는 future video frames $Y \in \mathbb{R}^{B \times \hat{T} \times C \times H \times W}$를 정확하게 predict하는 것입니다.

여기서 $B$는 batch size를 나타내고, $T$는 observed frames의 수, $\hat{T}$는 predict할 future frames의 수, $C$는 channels의 수, 그리고 $H, W$는 각 frame의 spatial dimensions (height 및 width)를 나타냅니다. 공식적으로, 이 task는 다음과 같은 function을 learning하는 것으로 정의될 수 있습니다:

여기서 $\theta$로 parameterize된 model $F$는 과거 video frames로부터 복잡한 spatio-temporal dependencies를 learn하고, 이를 활용하여 future frames에 대한 정밀하고 high-fidelity predictions를 generate하는 것을 목표로 합니다.

과제는 video data가 본질적으로 short-term dynamics (연속된 frames 간의 local correlations)와 long-term dependencies (여러 frames에 걸쳐 천천히 진화하거나 주기적인 patterns)를 모두 포함하고 있다는 것이며, 이는 신뢰할 수 있는 predictions를 위해 short-term 및 long-term temporal relationships 모두에 대한 정확한 modeling을 중요하게 만듭니다.

4.2 VideoTitans

Input Embedding and Positional Encoding. Input video sequence $(B, T, C, H, W)$는 $(B \times T, C, H, W)$로 reshape됩니다. 각 frame은 positional encoding (PE)과 함께 spatial patches로 embed됩니다:

그 다음 우리는 embeddings를 temporal modeling에 적합한 형태로 permute합니다: $(B \times T, \text{embed\_dim}, H/16, W/16) \to (B, H/16 \times W/16, T \times \text{embed\_dim})$.

Neural Long-term Memory Module. 우리는 gradient-based surprise mechanism에 기초한 adaptive neural long-term memory module을 소개합니다. 시간 $t$에서의 memory state update rule은 다음과 같습니다:

여기서 surprise score $S_t$는 다음에 의해 계산됩니다:

여기서 parameters $\alpha_t, \eta_t$, 그리고 $\theta_t$는 각각 adaptive forgetting, surprise decay, 및 momentary surprise integration을 제어하여, crucial historical information의 selective memorization을 가능하게 합니다.

Sliding Window Attention. Short-term temporal dependencies를 정밀하게 model하기 위해, sliding window attention이 embedded input sequences에 적용됩니다:

여기서 $X_{\text{emb}}$는 reshape된 spatial embeddings를 나타냅니다.

Persistent Memory. Task-specific하고 context-independent한 information을 encode하기 위해, 우리는 persistent memory parameters $P$를 통합합니다. 이 parameters는 다음과 같이 embedded input에 concatenate됩니다:

Decoding and Frame Reconstruction. Final prediction은 gating mechanism을 통해 short-term attention과 neural long-term memory의 결합된 representations를 decoding하여 얻어집니다:

Decoded output $\hat{Y}$는 원래의 video dimensions $(B, \hat{T}, C, H, W)$로 다시 reshape됩니다.

📝 4. Methodology 핵심 정리 노트 (for AI Researchers)

1. Problem Definition & Core Challenge

- Goal: Observed frames $X$를 통해 Future frames $\hat{Y}$를 예측하는 함수 $F(X; \theta)$ 학습.

- Dual Challenge: Video data의 두 가지 속성을 동시에 모델링해야 함.

- Short-term dynamics: 연속된 프레임 간의 Local correlations.

- Long-term dependencies: 다수의 프레임에 걸쳐 천천히 변하거나 주기적인 Patterns.

2. VideoTitans Architecture Overview

Standard Transformer의 한계를 극복하기 위해 Long-term Memory (Titans), Short-term Attention, Persistent Memory를 결합한 Hybrid 구조.

- A. Input Formulation

- Video Sequence를 $(B \times T, \text{embed\_dim}, H/16, W/16)$ 형태의 Spatial patches로 Embedding 후, Temporal modeling에 적합하도록 Permute.

- B. Neural Long-term Memory Module (The Core)

- Mechanism: Gradient-based surprise에 기반한 Adaptive memory update.

- Memory Update Rule:

- $\alpha_t$: Adaptive forgetting gate (불필요한 정보 삭제).

-

$$M_t = (1 - \alpha_t)M_{t-1} + S_t$$

- Surprise Score ($S_t$):

- $\nabla \ell(M_{t-1}; x_t)$: Loss gradient를 통해 계산된 Momentary surprise (예측 오차).

- $\eta_t, \theta_t$: Surprise decay 및 Integration 비율 조절.

-

$$S_t = \eta_t S_{t-1} - \theta_t \nabla \ell(M_{t-1}; x_t)$$

- Role: Crucial historical information만 선택적으로 Memorization (Memory overflow 방지).

- C. Sliding Window Attention

- Role: Short-term temporal dependencies를 정밀하게 포착.

-

$$Y_S = \text{SlidingWindowAttention}(X_{\text{emb}})$$

- D. Persistent Memory (Learnable Priors)

- Concept: Task-specific하거나 Context-independent한 정보(Priors)를 저장하는 고정된 Parameters $P$.

- Implementation: Embedded input에 Concatenate하여 주입.

-

$$X_{\text{new}} = [p_1, \dots, p_{N_p}] \| X_{\text{emb}}$$

- E. Decoding & Gating Mechanism

- Fusion: Short-term attention($Y_S$)과 Long-term memory($M_t$)를 Gating mechanism을 통해 결합.

- Final Output:

-

$$\hat{Y} = \text{Decoder}(\sigma(Y_S \otimes M_t))$$

- 두 정보 소스를 동적으로 융합하여 최종 Frame reconstruction 수행.

💡 쉬운 설명 : "운전에 비유한 VideoTitans의 3박자"

이 섹션은 VideoTitans가 영상을 예측하기 위해 사용하는 세 가지 도구와 그 작동 원리를 설명합니다. 운전할 때를 상상하면 이해하기 쉽습니다.

1. Sliding Window Attention (단기 기억: 눈앞의 상황)

- 운전할 때 바로 앞차와의 거리나 신호등을 보는 것과 같습니다.

- 역할: 바로 직전 프레임들과의 관계를 파악해서 즉각적인 움직임을 예측합니다.

2. Neural Long-term Memory (장기 기억: 놀라움 기반 학습)

- 이 모델의 핵심 기술입니다. 평범한 주행은 잊어버리지만, "갑자기 튀어나온 고라니"처럼 놀라웠던(Surprise) 사건은 기억해둡니다.

- 작동법: 예측이 크게 틀린 부분(Loss gradient가 큰 부분)을 "중요한 정보"로 인식하고 메모리에 저장합니다. 뇌 용량이 차면 덜 중요한 건 스스로 지웁니다(Adaptive forgetting).

3. Persistent Memory (본능/지식: 교통 법규)

- 이번 운전과 상관없이 원래 알고 있어야 하는 지식입니다. "빨간불엔 멈춘다", "중력은 아래로 작용한다" 같은 고정된 규칙들입니다.

- 역할: 영상의 내용과 상관없이 항상 적용되는 기본 원리들을 모델에 미리 심어줍니다.

결론 (Decoding)

VideoTitans는 이 세 가지(눈앞의 상황 + 과거의 충격적인 기억 + 기본 지식)를 적절히 섞어서(Gating) 다음 장면을 그려냅니다.

1. 준비 단계: 입력 데이터 구성 (Input & Preprocessing)

가장 먼저 모델에 들어갈 재료를 준비합니다. 단순한 이미지가 아니라, 모델이 '어떤 태스크를 수행하는지' 알 수 있는 단서까지 함께 넣습니다.

- 비디오 패치화 (Patch Embedding): 1280x720 같은 큰 이미지를 통째로 넣지 않고, $16 \times 16$ 크기의 작은 조각(Patch)으로 잘라서 벡터로 변환합니다. 이때 NLP와 달리 시간 순서(Time Step) 구조는 그대로 유지합니다 .

- 영구 메모리 부착 (Persistent Memory, $P$): 입력 영상 데이터 앞에, 학습을 통해 얻은 '고정된 지식 토큰(Task-specific Priors)'들을 이어 붙입니다(Concatenate). 이는 모델에게 환경 정보나 물리 법칙 같은 맥락을 제공합니다 .

2. 핵심 처리: 투 트랙 전략 (Two-Track Processing)

입력 데이터는 모델 내부에서 **두 개의 경로(Path)**로 나뉘어 동시에 처리됩니다. 이것이 이 모델의 핵심인 **'전체 맥락'**과 **'디테일'**을 동시에 잡는 비결입니다.

- Track A: 장기 기억 부서 (Titans Memory Module)

- 역할: 영상의 전체적인 흐름과 맥락(Global Context)을 압축 요약합니다.

- 작동 원리 (Surprise): "예측해보고 $\rightarrow$ 틀리면(Gradient가 크면) $\rightarrow$ 놀라움(Surprise)을 메모리($M_t$)에 기록"하는 방식으로, 중요한 정보만 선별하여 장기 기억을 업데이트합니다 .

- Track B: 단기 디테일 부서 (Sliding Window Attention)

- 역할: 바로 직전 프레임들의 생생한 움직임(Local Dynamics)을 포착합니다.

- 작동 원리: 전체를 보지 않고 윈도우(Window)를 씌워 최신 프레임 몇 장만 고화질로 집중해서 봅니다. 덕분에 연산량이 폭발하지 않습니다(Linear Complexity) .

3. 통합 단계: 게이팅 (Gating Mechanism)

두 부서에서 처리한 정보를 하나로 합치는 단계입니다.

- Memory as a Gate (MAG): "배경 흐름은 장기 기억($M_t$)에서 가져오고, 물체의 세밀한 이동은 단기 기억($Y_S$)에서 가져오자"는 식으로, **게이트(Gate)**가 두 정보를 적절한 비율로 섞어서 디코더에게 넘겨줍니다 .

4. 출력 단계: 프레임 생성 (Decoding & Prediction)

압축된 정보를 다시 우리가 볼 수 있는 이미지로 복원합니다.

- 픽셀 단위 회귀 (Pixel-wise Regression): 디코더(Decoder)를 통해 압축을 풀고, 다음 프레임의 모든 픽셀 RGB 값을 동시에 계산해냅니다. 분류(Classification)가 아닌 실수값을 예측하는 회귀(Regression) 문제입니다 .

- 결과물: $(B, \hat{T}, C, H, W)$ 형태의 실제 비디오 프레임 텐서가 출력됩니다.

5. 순환 단계: 피드백 루프 (Autoregressive Loop)

미래를 계속해서 예측하기 위해 스스로의 결과물을 재사용합니다.

- Feedback: 방금 모델이 뱉어낸 **예측 프레임(Output)**을 다시 **입력(Input)**으로 집어넣습니다.

- Next Step: 이 가상의 프레임을 '과거'로 삼아, 그보다 더 먼 미래의 프레임을 예측하는 과정을 반복하여 긴 영상을 생성합니다 .

요약:

VideoTitans는 **"패치화된 입력"**을 받아 **"장기(Titans)와 단기(Window) 두 경로"**로 병렬 처리한 뒤, 이를 "게이트로 합쳐" 다음 장면의 "픽셀을 그려내고", 다시 이를 입력으로 삼는 **"무한 루프"**를 통해 미래를 예측합니다.

별점 3점 / 5점

최신 NLP 트렌드(Titans)를 비디오 예측에 발 빠르게 적용하여 효율성을 입증한 시의적절한 연구이나, 'Scalable High-Resolution'이라는 타이틀에 비해 실험 스케일과 학습 안정성 면에서는 검증이 더 필요함.