AI바라기의 인공지능

VLM : 논문리뷰 : Imagine while Reasoning in Space: Multimodal Visualization-of-Thought 본문

VLM : 논문리뷰 : Imagine while Reasoning in Space: Multimodal Visualization-of-Thought

AI바라기 2025. 2. 7. 18:27Overall Summary

이 논문은 MLLMs가 complex spatial reasoning tasks를 해결하기 위해 image visualizations를 생성하는 새로운 reasoning paradigm인 MVoT를 제안한다. MVoT는 기존 CoT의 한계를 극복하고, 더 나은 interpretability와 robustness를 제공하며, multimodal reasoning의 새로운 가능성을 제시한다. Token discrepancy loss를 통해 visualization quality를 향상시킨 것도 중요한 contribution이다.

쉬운 설명

이 논문은 마치 사람이 머릿속으로 그림을 그리면서 문제를 해결하는 것처럼, AI 모델(MLLM)도 그림(visual thought)을 그리면서 추론(reasoning)할 수 있도록 하는 새로운 방법(MVoT)을 제안한 것입니다. 기존 방법(CoT)은 복잡한 공간 추론 문제에서 어려움을 겪었지만, MVoT는 그림을 통해 더 직관적이고 정확하게 문제를 해결할 수 있습니다. 특히, "token discrepancy loss"라는 새로운 기술을 통해 AI가 그리는 그림의 품질을 향상시켰습니다.

Imagine while Reasoning in Space: Multimodal Visualization-of-Thought 학습 노트 (Revised)

Purpose of the Paper

- 기존 Chain-of-Thought (CoT) prompting이 Large Language Models (LLMs) 및 Multimodal Large Language Models (MLLMs)의 complex spatial reasoning task에서 어려움을 겪는 한계를 극복하고자 함.

- 인간의 인지가 언어뿐만 아니라 이미지로도 사고하는 능력에 착안, MLLMs가 reasoning trace를 image visualization으로 생성하는 visual thinking을 가능하게 하는 새로운 reasoning paradigm, Multimodal Visualization-of-Thought (MVoT) 제안.

- MLLMs가 visual modality에서 'imagine'하면서 reasoning할 수 있는지 실험.

Key Contributions

- Multimodal Visualization-of-Thought (MVoT): text와 vision을 reasoning trace 내에서 통합하는 multimodal native reasoning paradigm 제안. reasoning 과정의 일부로 visual thought를 자연스럽게 생성하는 최초의 시도.

- Token Discrepancy Loss: autoregressive MLLMs에서 separately trained tokenizer 간의 gap을 줄이기 위해 token discrepancy loss 도입. visual coherence와 fidelity를 크게 향상.

- 새로운 Dataset 및 검증: 세 가지 dynamic spatial reasoning task (MAZE, MINIBEHAVIOR, FROZENLAKE)에 대한 comprehensive experiments 및 ablation studies 수행. MVoT가 complex scenarios에서 CoT보다 뛰어난 adaptability와 robustness를 보임을 입증.

Novelty

- Visual Thought의 자연스러운 생성: 기존 연구들이 external tools 또는 two-stage strategies를 통해 image 정보를 활용한 반면, MVoT는 MLLM 자체가 reasoning trace의 일부로 image visualization (visual thought)을 생성.

- Multimodal Native Reasoning: text-form thinking에서 벗어나, multimodal-native architectures를 활용하여 words와 images를 결합한 reasoning trace를 생성.

- token discrepancy loss를 도입하여 visualization quality를 향상.

Experimental Highlights

- Datasets: 세 가지 spatial reasoning task (MAZE, MINIBEHAVIOR, FROZENLAKE)에 대한 데이터셋 구축.

- Model: Chameleon-7B [Cha24] autoregressive MLLM을 fine-tuning하여 MVoT 구현.

- Baselines: Direct Prompting, Chain-of-Thought (CoT), Interleaved (text-image pairs로 학습하지만 image token에는 loss를 계산하지 않는 방식).

- 주요 결과:

- MVoT는 모든 task에서 competitive performance 달성. 특히 challenging scenarios (FROZENLAKE)에서 CoT를 20% 이상 outperform.

- MVoT는 Direct 및 GPT-4o보다 interpretability가 우수.

- MVoT는 CoT보다 environment complexity에 대한 robustness가 뛰어남.

- Interleaved training data를 사용하는 것만으로도 reasoning performance 향상.

- Token discrepancy loss는 visualization accuracy를 높이고 redundancy를 줄임.

- Metrics:

- Accuracy

- Visualization Accuracy (V-Acc.): 다음 행동에 해당하는 grid 내 변화를 정확하게 시각화하는 정도.

- Visualization Pattern Redundancy (V-Red.): 목표 영역 외부의 불필요한 시각적 패턴 존재 정도.

- Visualization Correctness Step (V-Steps): 행동 sequence 내 처음 k개 연속된 정확한 시각화의 평균 길이.

- Visualization Correctness Ratio (V-Ratio): 행동 sequence 전체에서 처음 k개 연속된 정확한 시각화의 평균 비율.

Limitations and Future Work

- Limitations:

- 생성된 visualization이 FROZENLAKE의 background patterns와 같이 task-irrelevant details를 reconstruct하려는 경향.

- Visualization 생성에 따른 computational overhead 발생.

- Future Work:

- Diffusion models [SKHW24]의 guidance techniques를 통합하여 visualization quality 향상.

- Compact image representations [CZL+24, YWD+24]를 사용하여 visualization generation의 computational cost 감소.

- FROZENLAKE task 에서 visual cues in FROZENLAKE에 대한 연구

Abstract

Chain-of-Thought (CoT) prompting은 Large Language Models (LLMs) 및 Multimodal Large Language Models (MLLMs)에서 복잡한 reasoning을 향상시키는 데 매우 효과적인 것으로 입증되었습니다. 그러나 복잡한 공간 reasoning task에서는 어려움을 겪습니다. 그럼에도 불구하고 인간의 인지 능력은 언어뿐만 아니라, 말과 이미지로 생각하는 놀라운 능력을 가능하게 합니다. 이러한 메커니즘에서 영감을 받아, 우리는 새로운 reasoning 패러다임인 Multimodal Visualization-of-Thought (MVoT)를 제안합니다. MVoT는 MLLMs에서 reasoning trace의 image visualization을 생성하여 visual thinking을 가능하게 합니다. 고품질 visualization을 보장하기 위해 autoregressive MLLMs에 token discrepancy loss를 도입했습니다. 이러한 혁신은 visual coherence와 fidelity를 모두 크게 향상시킵니다. 우리는 여러 dynamic spatial reasoning tasks를 통해 이 접근 방식을 검증합니다. 실험 결과는 MVoT가 여러 task에서 경쟁력 있는 성능을 보여준다는 것을 보여줍니다. 또한, CoT가 실패하는 가장 어려운 시나리오에서 강력하고 신뢰할 수 있는 개선을 보여줍니다. 궁극적으로 MVoT는 visual thinking이 verbal reasoning을 효과적으로 보완할 수 있는 복잡한 reasoning tasks에 대한 새로운 가능성을 제시합니다.

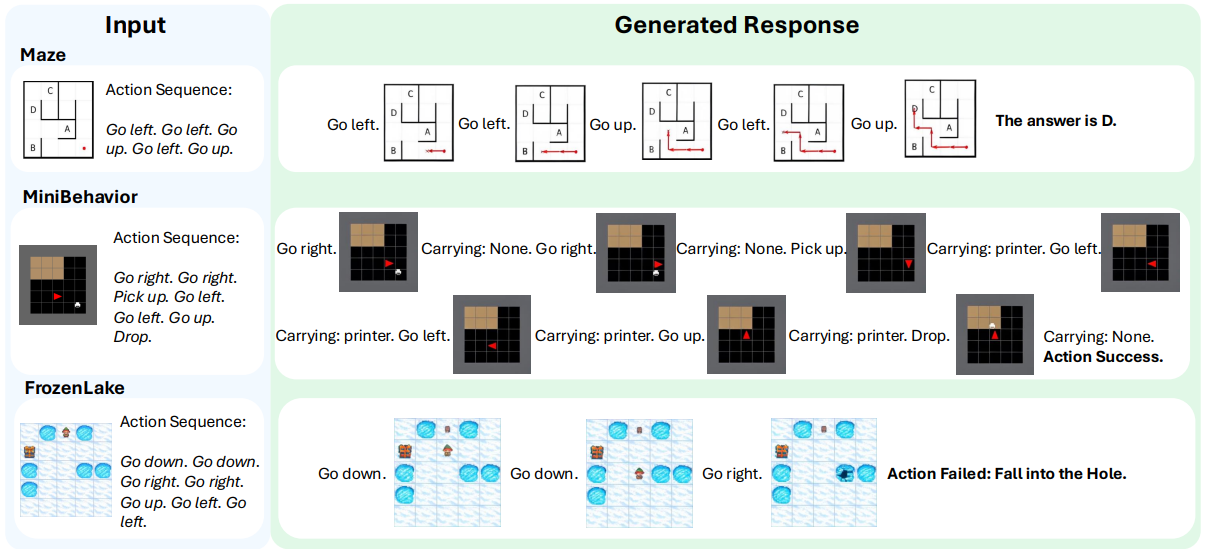

Figure 1: Multimodal Visualization-of-Thought (MVoT)는 Multimodal Large Language Models (MLLMs)가 서로 다른 modality에 걸쳐 interleaved reasoning traces를 생성할 수 있도록 합니다. 기존 CoT는 verbal thought에만 의존하는 반면, MVoT는 reasoning traces를 visualize하기 위해 visual thought를 촉진합니다. 이 reasoning 패러다임은 말과 이미지로 매끄럽게 생각하는 인간의 인지와 유사합니다.

1 Introduction

Chain-of-Thought (CoT) prompting은 Large Language Models (LLMs)의 reasoning 능력을 크게 향상시켰습니다. CoT는 명시적인 reasoning traces를 생성함으로써 models이 자신의 사고 과정을 단계별로 명확하게 표현할 수 있도록 합니다. 이러한 발전은 단계별 수학적 reasoning, 논리적 추론, 그리고 고급 문제 해결 능력을 가능하게 했습니다. 그러나 복잡한 spatial reasoning tasks에 직면했을 때 CoT의 성능은 현저히 저하됩니다.

최근 연구 노력은 두 가지 주요 접근 방식을 통해 CoT를 multimodal models로 확장했습니다. 첫 번째 접근 방식은 captioning, scene-graph generation, 또는 bounding-box detection과 같은 방법을 통해 먼저 이미지 정보를 추출한 다음 reasoning을 수행하는 two-stage 전략을 활용합니다. 두 번째 접근 방식은 code interpreters 또는 specialized vision models와 같은 external tools을 활용하여 환경으로부터 이미지 observations를 얻는 ReAct-style pipelines을 구현합니다. 이러한 pipelines은 텍스트와 이미지 입력을 모두 성공적으로 처리하지만, 여전히 별도의 visual modules 또는 external toolsets에 크게 의존합니다. 이러한 의존성은 advanced 및 더 복잡한 spatial reasoning tasks에 대한 적응을 복잡하게 만듭니다.

그러나 인간의 인지는 언어(및 텍스트)만을 초월하여 말과 이미지로 매끄럽게 생각하는 능력을 보여줍니다. 이중 부호화 이론(dual-coding theory)과 작업 기억 모델(working memory model)은 인간이 verbal 및 non-verbal 채널을 통해 정보를 처리한다고 가정하여 이 현상을 설명합니다. 이 이중 처리 능력은 reasoning에 매우 중요하며 의사 결정과 행동을 안내합니다. 예를 들어, 인간은 자연스럽게 mental images를 형성하고 조작하여 물리적 세계를 이해하고 visual outcomes를 개념화합니다.

spatial reasoning의 맥락에서, LLMs 및 MLLMs의 유사한 결함, 즉 단일 텍스트 modality(이하 verbal)로 생각하는 것이 관찰되었습니다. verbal CoT를 기반으로, Visualization-of-Thought (VoT)는 spatial reasoning tasks에서 텍스트 'visualizations'를 mental images로 도입하여 reasoning 과정을 도출합니다. 간단히 말해, VoT는 단순화된 텍스트 프록시를 통해 visualizations를 구축합니다. visualization의 너무 단순한 표현 외에도, CoT와 VoT 모두에 해당되는 또 다른 중요한 한계는 reasoning paths의 순전히 텍스트 표현에 의존한다는 것입니다. 이러한 의존성은 복잡한 multimodal tasks에서 문제가 되는데, 여기서 텍스트 표현은 종종 이미지의 복잡한 visual patterns 및 spatial layouts를 포착하지 못합니다. 사용자는 텍스트 표현을 보완하는 명확하고 직관적인 visual illustrations 없이는 reasoning 과정을 해석하는 데 어려움을 겪는 경우가 많습니다. 게다가, MLLMs가 텍스트 발화로 생각하는 것 외에도 visual space 내에서 진정한 reasoning에 참여할 수 있는지 여부는 여전히 불분명합니다. ReAct-style methods는 MLLMs가 multimodal information으로 reasoning을 강화할 수 있도록 external sets of tools를 사용하여 intermediate visual thoughts를 생성합니다. 그러나 우리는 task 성능의 향상이 model 자체가 multimodality에서 'reasoning'하는 것에서 비롯되지 않으며 표현력은 여전히 tools의 기능에 의해 제한된다고 주장합니다. 위의 이유들을 고려할 때, 우리는 핵심적인 질문을 제기합니다: MLLMs는 reasoning하는 동안 visual modality에서 상상할 수 있을까요?

이와 동시에, 최근 연구는 visual inputs의 multimodal understanding을 넘어 multimodal generation을 포함하도록 확장되었으며, 여기서 foundation models은 visual modality에서도 출력을 생성할 수 있습니다. 이러한 발전은 Chameleon, Transfusion, Gemini 2, LatentLM과 같은 정교한 systems의 개발로 이어졌습니다. 이러한 multimodal-native models은 텍스트 및 visual domains 모두에서 고품질 출력을 해석하고 생성하는 데 능숙함을 보여줍니다. multimodal generation의 새로운 기능은 verbal reasoning을 native visual thinking으로 확장하여 images를 통해 reasoning traces의 visualization을 가능하게 하는 새로운 가능성을 열어줍니다.

이러한 발전을 바탕으로, 우리는 Multimodal Visualization-of-Thought (MVoT)를 제안합니다. MVoT는 multimodal-native architectures를 활용하여 reasoning traces의 image visualizations를 생성함으로써 텍스트 형태의 사고를 multimodal native reasoning으로 초월합니다. 이 reasoning paradigm은 model이 reasoning traces를 생성하고 말과 이미지를 결합하여 매끄럽게 '생각'할 수 있게 하는 동시에, 이미지를 captioning하는 과정에서 발생할 수 있는 잠재적인 오류를 방지합니다. reasoning process 중에 native visual thought를 통합함으로써 MVoT는 reasoning process에 대한 보다 직관적인 설명을 제공하고 동시에 reasoning quality와 model interpretability를 모두 향상시킵니다.

구체적으로, 이 작업에서 우리는 확립된 autoregressive MLLM인 Chameleon-7B를 fine-tuning하여 MVoT를 구현합니다. reasoning 중 visualization quality를 향상시키기 위해 별도로 trained tokenizers 간의 격차를 해소하는 token discrepancy loss를 도입합니다. 우리는 세 가지 dynamic spatial reasoning tasks에 대한 광범위한 실험을 통해 MVoT의 효과를 검증합니다. MAZE와 MINIBEHAVIOR는 spatial layouts와의 상호 작용에 중점을 둡니다. FROZENLAKE는 dynamic environments에서 fine-grained pattern recognition을 강조합니다. 실험 결과는 MVoT가 여러 task에서 경쟁력 있는 성능을 달성하고, 도전적인 시나리오에서 기존 CoT보다 20% 이상 우수한 성능을 보인다는 것을 보여줍니다.

이 논문의 주요 contributions는 다음과 같습니다:

- 우리는 reasoning traces 내에서 텍스트와 vision을 통합하는 multimodal native reasoning paradigm인 Multimodal Visualization-of-Thought (MVoT)를 제안합니다. 우리가 아는 한, 이것은 reasoning process의 일부로 visual thought를 자연스럽게 생성하는 최초의 시도입니다. 이는 visual thinking이 verbal reasoning을 효과적으로 보완하는 복잡한 tasks에 대한 새로운 가능성을 제시합니다.

- 우리는 Chameleon-7B에서 MVoT를 구현하고 별도로 trained tokenizer 간의 격차를 해소하기 위해 auto-regressive MLLM에 token discrepancy loss를 도입합니다.

- 우리는 새롭게 수집된 datasets를 사용하여 세 가지 spatial reasoning tasks에 대한 포괄적인 실험과 ablation studies를 수행하여 MVoT가 복잡한 시나리오에서 CoT에 비해 우수한 적응성과 robustness를 나타냄을 보여줍니다.

Figure 2: MVoT reasoning process의 Illustrations. Interleaved verbal thoughts와 visual thoughts는 MLLM에 의해 매끄럽게 생성됩니다.

1 Introduction 정리 노트 (AI 연구자 대상)

주요 문제 제기:

- Chain-of-Thought (CoT) prompting은 Large Language Models (LLMs)의 reasoning 능력을 향상시켰지만, 복잡한 spatial reasoning tasks에서는 성능 저하를 보임.

- 기존 multimodal CoT 연구들은 external visual modules 또는 toolsets에 의존하여, advanced spatial reasoning tasks에 적용하기 어려움.

- LLMs 및 MLLMs가 single text modality (verbal)로만 사고하는 것은 이미지의 복잡한 visual patterns 및 spatial layouts를 포착하는 데 한계가 있음.

- 핵심 질문: MLLMs가 reasoning 과정에서 visual modality로 "상상"할 수 있는가?

제안하는 해결책:

- Multimodal Visualization-of-Thought (MVoT):

- Multimodal-native architectures를 활용하여 reasoning traces의 image visualizations를 생성.

- Model이 말(text)과 이미지(vision)를 결합하여 "생각"하도록 함 (native visual thinking).

- Reasoning quality 및 model interpretability를 향상.

구현 및 검증:

- Chameleon-7B를 fine-tuning하여 MVoT 구현.

- Token discrepancy loss 도입: 별도로 trained tokenizers 간의 격차 해소 (visualization quality 향상).

- 세 가지 dynamic spatial reasoning tasks (MAZE, MINIBEHAVIOR, FROZENLAKE)에서 검증.

- MVoT가 challenging scenarios에서 CoT보다 20% 이상 우수한 성능 달성.

핵심 Contribution:

- Reasoning traces 내에서 text와 vision을 통합하는 최초의 multimodal native reasoning paradigm (MVoT) 제안.

- Auto-regressive MLLM에 token discrepancy loss를 도입하여 MVoT 구현.

- Spatial reasoning tasks에서 MVoT의 우수한 적응성과 robustness 입증.

쉬운 설명:

1 Introduction 섹션에서는 기존의 언어 모델(LLMs)들이 복잡한 공간 추론 문제(예: 미로 찾기, 물건 배치 등)에 약하다는 점을 지적합니다. 인간은 말로만 생각하는 것이 아니라, 머릿속에 이미지를 그리면서("visual thinking") 문제를 해결하는 경우가 많습니다.

이 논문에서는 이러한 "visual thinking"을 모방하여, 언어 모델이 추론 과정에서 필요한 이미지를 직접 생성하도록 하는 새로운 방법(MVoT)을 제안합니다. 예를 들어, 미로 찾기 문제를 풀 때, 언어 모델이 단순히 말로만 경로를 설명하는 것이 아니라, 실제로 미로를 통과하는 이미지를 만들어내면서 추론하는 것이죠.

이를 위해, 이 논문에서는 이미지를 생성할 수 있는 특별한 언어 모델(Chameleon-7B)을 사용하고, 이미지 생성 품질을 높이기 위한 기술(token discrepancy loss)도 도입했습니다. 실험 결과, 이 방법이 기존 방법보다 훨씬 더 어려운 문제들을 잘 해결한다는 것을 보여주었습니다.

간단히 말해, 이 논문은 언어 모델에게 "눈"을 달아주어, 더 복잡한 문제도 잘 풀 수 있게 만들었다고 생각하면 됩니다.

2 Multimodal Visualization-of-Thought (MVoT)

인간은 종종 의사 결정을 내리기 위해 mental images를 만듭니다. MVoT는 이러한 mental images를 모방하기 위해 텍스트 프록시로 verbal thoughts에 의존하는 대신, models이 visual thoughts로 image visualizations를 생성하여 multimodality에서 reasoning 할 수 있도록 합니다. 두 modality의 thoughts를 결합함으로써, 이 새로운 reasoning paradigm은 향상된 표현력으로 multimodal reasoning process를 도출하는 더 직관적이고 효과적인 방법을 제공합니다.

2.1 Formulation

우리는 MVoT의 process를 다음과 같이 공식화합니다. multimodal input sequence가 주어지면, model은 reasoning process의 일부로 interleaved multimodal thoughts를 생성하고 궁극적으로 final answer를 생성할 것으로 예상됩니다. Pθ는 parameters θ를 갖는 pre-trained MLLM을 나타내고, x는 multimodal input sequence를, z와 v는 각각 verbal thoughts의 language sequence와 visual thoughts의 image sequence를 나타냅니다.

input x가 있는 multi-hop spatial reasoning tasks에서, CoT prompting은 intermediate steps zˆ1, · · · , zˆm을 생성하며, 여기서 각 zˆi는 inputs 및 이전에 생성된 steps를 기반으로 순차적으로 sampled 됩니다. final output은 이전의 모든 steps를 기반으로 결론지어집니다. MVoT는 각 intermediate step zi에 image visualization vi를 추가하여 이 process를 향상시킨 다음, Figure 1과 같이 후속 step zi+1은 이전 steps zˆ1 · · · zˆi 및 visualizations vˆ1 · · · vˆi를 조건으로 sampled 됩니다.

Equation 1과 2에 정의된 대로, interleaved reasoning traces와 image visualizations를 형성합니다.

vˆi ∼ Pθ(vi | zˆ1, vˆ1, · · · , vˆi−1, zˆi) (1)

zˆi+1 ∼ Pθ(zi+1 | x, zˆ1, vˆ1, · · · , zˆi, vˆi) (2)

MLLMs에 MVoT capabilities를 부여하기 위해, multimodal inputs x와 multimodal rationales z1, v1 · · · zn, vn 및 final answer를 포함하는 해당 output labels에 대해 model을 train합니다. 이 training 전략은 model이 interleaved verbal reasoning steps와 해당 visual thoughts를 학습할 수 있게 하여, multimodality에서 생각해야 하는 복잡한 reasoning tasks를 처리하는 능력을 향상시킵니다.

2.2 Training with Autoregressive MLLMs

다음 섹션에서는 training 및 inference 모두에 대해 discrete image tokens를 사용하는 autoregressive MLLMs에 초점을 맞춥니다. 그러나 reasoning paradigm으로서 MVoT는 interleaved multimodal generation에 대한 요구 사항을 충족하는 한 다른 model architectures 및 modalities로 확장될 수 있습니다.

Multimodal Sequence Modeling

Figure 3과 같이, 우리는 image와 text tokens를 모두 처리하기 위해 unified Transformer를 활용하는 Chameleon의 architecture를 따릅니다. 이 architecture는 두 개의 tokenizers를 통합합니다. ERO21을 기반으로 하는 image tokenizer와 text tokenizer는 각각 images와 text를 discrete token sequences로 변환합니다. image tokenizer는 discrete codebook을 사용하여 input images를 image tokens의 sequence로 encode하는 반면, text tokenizer는 textual data를 해당 token sequences로 매핑합니다. 이러한 token sequences는 concatenated 되고 causal transformer model에 의해 processed 됩니다.

Notation

MLLM의 codebook을 C ∈ R^(N×D)로 표시합니다. 여기서 N은 codebook entries의 수이고, D는 codebook entries의 dimensionality입니다. tvis와 evis는 visual codebook indices와 embeddings를 나타냅니다. 예측된 값은 hat 기호로 표시됩니다.

Token Discrepancy Loss

Language modeling은 단일 autoregressive model 내에서 text tokens와 image tokens를 모두 통합하지만, 별도로 trained 된 이러한 tokenizers 간의 불일치는 생성된 images의 quality를 저하시킬 수 있습니다. 이 문제를 완화하기 위해 Figure 3과 같이 autoregressive MLLM architecture에 token discrepancy loss를 도입합니다. 이 loss design은 language modeling과 visual embedding space 사이의 격차를 해소하는 동시에 gradients가 손상되지 않도록 합니다.

Token discrepancy loss LD는 visual embedding space에서 predictions와 labels 간의 불일치를 최소화합니다. Equation 3과 4는 token discrepancy loss LD를 설명합니다. image tokens 간의 관계를 포착하기 위해 먼저 similarity matrix S ∈ R^(N×N)을 계산합니다. tvisi와 다른 image tokens 간의 similarity는 visual embedding space에서 pairwise distances를 사용하여 측정됩니다. 구체적으로, similarity는 Equation 3에 설명된 대로 mean squared error (MSE)에 의해 결정되며, 거리가 클수록 similarity가 낮음을 나타냅니다.

Stvisi = [MSE(evisi, evis1), · · · , MSE(evisi, evisN)] ∈ R^(1×N) (3)

model은 image token vocabulary에 대한 i번째 image token에 대한 probability distribution P(ti) ∈ R^(1×N)을 예측합니다. LD는 visual embedding space에서 해당 label tvisi와 크게 벗어나는 tokens에 할당된 probabilities에 불이익을 줍니다. predictions의 visual embeddings를 ground-truth tokens의 visual embeddings와 정렬함으로써, LD는 생성된 images의 quality를 향상시키는 것을 목표로 합니다.

LD = Σᵢ¹ⁿ (Stvisi · P(ti)) (4)

Training

Causal Transformer model은 next-token prediction objective를 사용하여 fine-tuned 되는 반면, image tokenizer와 text tokenizer는 전체 process 동안 frozen 상태로 유지됩니다. 위에서 정의한 image tokens에 대한 token discrepancy loss LD와 text tokens 및 image tokens 모두에 대한 cross-entropy loss LC를 사용하여 loss function은 다음과 같이 설명됩니다.

L = LC + LD (5)

Figure 3: token discrepancy loss LD를 사용한 MVoT training의 Illustration.

2 Multimodal Visualization-of-Thought (MVoT) 정리 노트 (AI 연구자 대상)

핵심 아이디어:

- MVoT의 정의: Model이 reasoning 과정에서 mental images를 모방하기 위해 verbal thoughts (text) 외에 visual thoughts (image visualizations)를 생성하여 multimodality에서 reasoning.

- Formulation (수식화):

- Input: multimodal input sequence (x)

- Output: interleaved multimodal thoughts (verbal: z, visual: v) + final answer

- Process: 각 reasoning step (zi)에 image visualization (vi)를 추가, 다음 step (zi+1)은 이전 steps와 visualizations를 기반으로 생성 (Equations 1 & 2).

- vˆi ∼ Pθ(vi | zˆ1, vˆ1, · · · , vˆi−1, zˆi)

- zˆi+1 ∼ Pθ(zi+1 | x, zˆ1, vˆ1, · · · , zˆi, vˆi)

- Autoregressive MLLMs를 이용한 Training:

- Chameleon architecture 사용: unified Transformer (image & text tokens 처리).

- 핵심: Token Discrepancy Loss (LD) 도입 (Figure 3).

- 별도로 trained 된 image tokenizer와 text tokenizer 간의 불일치 완화.

- Visual embedding space에서 predictions와 labels 간의 discrepancy 최소화 (Equations 3 & 4).

- Similarity matrix (S) 계산: image tokens 간의 관계 포착 (MSE 사용).

- Loss function: L = LC (cross-entropy) + LD (token discrepancy) (Equation 5).

- Image tokenizer와 text tokenizer는 frozen 상태로 유지.

이 논문만의 차별점:

- 단순히 "보는" 것을 넘어 "상상"하는 MLLM: 기존 multimodal CoT 연구들은 external tools에 의존하거나 text-based visualization에 그쳤지만, MVoT는 MLLM 자체가 visual thoughts를 "생성"하여 reasoning에 활용.

- Token Discrepancy Loss: Autoregressive MLLM에서 image generation quality를 높이기 위한 새로운 loss function 제안.

쉬운 설명:

이 섹션에서는 MVoT가 어떻게 작동하는지, 그리고 어떻게 학습시키는지에 대한 자세한 설명이 나옵니다.

핵심은 "생각하는 과정"을 말(text)과 이미지(image)로 동시에 표현하는 것입니다. 예를 들어, 로봇에게 "컵을 테이블 위에 놓아줘"라고 명령했을 때, 로봇은 MVoT를 사용하여 다음과 같이 생각할 수 있습니다:

- Verbal thought (z1): "컵을 찾는다."

- Visual thought (v1): (컵 이미지 생성)

- Verbal thought (z2): "테이블을 찾는다."

- Visual thought (v2): (테이블 이미지 생성)

- Verbal thought (z3): "컵을 테이블 위에 놓는다."

- Visual thought (v3): (컵이 테이블 위에 있는 이미지 생성)

- Final answer: (컵을 테이블 위에 놓는 행동 수행)

이처럼 MVoT는 각 단계에서 말로 설명하는 것과 동시에, 그 상황을 나타내는 이미지를 생성합니다.

학습 방법의 핵심은 "Token Discrepancy Loss"라는 새로운 기술입니다. 쉽게 말해, 이미지를 생성할 때, 모델이 "이상한" 이미지를 만들지 않도록, "정답 이미지"와 비슷하게 만들도록 유도하는 기술입니다.

결론적으로, 이 섹션에서는 MVoT가 말과 이미지를 모두 사용하여 생각하고, 이를 학습시키기 위한 특별한 방법을 제시한다는 점이 중요합니다.

3 Spatial Reasoning Tasks

RDT+24에 동기를 부여받아, model이 동적으로 objects를 찾고, environment가 어떻게 진화하는지 이해하고, actions이 적용될 때 outcomes를 예측해야 하는 세 가지 dynamic reasoning tasks를 공간에서 선택합니다. 분석을 위해 controllability를 갖춘 MLLMs를 평가하기 위해 grid-based environments 내에서 이러한 spatial reasoning tasks를 설정합니다: MAZE navigation, MINIBEHAVIOR의 InstallingAPrinter, 그리고 FROZENLAKE simulation. MAZE는 abstract mazes에서 navigate하고 MINIBEHAVIOR는 objects의 spatial properties와 environmental layouts와의 interactions을 포함하는 반면, FROZENLAKE는 이미지에서 abstract symbols 대신 fine-grained pattern details를 포함합니다. 이 tasks는 현실 세계의 추상화로서 다양한 수준의 제어된 복잡성을 포함합니다.

3.1 MAZE

Maze navigation에서, model에게 maze layout과 maze 내 agent의 starting position을 설명하는 initial image가 제공됩니다. agent는 maze를 navigate하여 destination에 도달해야 합니다. 우리의 작업에서 MAZE task를 다음과 같이 정의합니다. starting point가 있는 initial maze와 actions의 sequence가 주어지면, model은 actions을 따르고 maze에서 A, B, C 또는 D로 표시된 locations 중에서 선택된 final destination을 예측해야 합니다.

3.2 MINIBEHAVIOR

우리는 MINIBEHAVIOR embodied AI tasks에서 InstallingAPrinter를 실험을 위한 대표적인 시나리오로 선택합니다. 이는 agent가 먼저 바닥에서 printer를 찾고, 그것을 집어 테이블로 가져가서 켜야 합니다. Figure 2에서 볼 수 있듯이, printer는 작은 printer symbol로 표시되고, agent는 빨간색 삼각형으로 표시되고, 테이블은 갈색 영역으로 표시됩니다. 이전 설정과 맞춰, 우리 작업에서 MINIBEHAVIOR task를 다음과 같이 정의합니다. actions의 sequence와 image의 environment layout이 주어지면, model은 actions 수행의 outcome을 예측해야 합니다. outcomes에는 agent가 printer를 집거나 테이블 위에 놓는 것과 같은 tasks를 성공적으로 수행하는지 여부와 objects가 environment에서 누락되었는지 여부가 포함됩니다. 이 task는 environment와의 interaction을 도입하여 MAZE의 action space를 확장하는 동시에, 단순한 symbolic representations에 의존하여 유사한 수준의 perception difficulty를 유지합니다.

3.3 FROZENLAKE

FROZENLAKE는 처음에 WZS+24가 Gym으로 구현하여 제안했으며, maze navigation과 유사하지만 더 복잡한 patterns와 details를 가지고 있습니다. Figure 2에서 볼 수 있듯이, grid-based frozen lake를 simulates 합니다. agent는 지정된 position에서 시작하여 'holes'에 빠지지 않고 안전하게 destination에 도달해야 합니다. WZS+24의 spatial reasoning task를 기반으로, FROZENLAKE task를 다음과 같이 정의합니다. actions의 sequence와 start 및 goal position이 있는 grid-based frozen lake layout이 주어지면, model은 주어진 actions을 따르는 consequence를 결정해야 합니다. MAZE 및 MINIBEHAVIOR와 비교하여 FROZENLAKE는 더 다양한 image details를 포함하고 있으며, holes와 같은 key entities의 수를 고려할 때 environment가 더 복잡합니다.

3 Spatial Reasoning Tasks 정리 노트 (AI 연구자 대상)

핵심 Motivation:

- RDT+24 연구에서 영감을 받아, MVoT의 성능 평가를 위한 dynamic spatial reasoning tasks 선정.

- Controllability 확보: Grid-based environments를 사용하여 MLLMs의 능력을 체계적으로 분석.

선정된 Tasks (난이도 순):

- MAZE:

- Agent가 주어진 action sequence에 따라 maze를 navigate하여 final destination 예측 (A, B, C, D 중 선택).

- 가장 기본적인 spatial reasoning task.

- MINIBEHAVIOR (InstallingAPrinter):

- Agent가 printer를 찾아 테이블 위에 놓고 켜는 task 수행.

- Object의 spatial properties, environment와의 interaction (e.g., picking, placing) 고려.

- MAZE보다 action space 확장, perception difficulty는 유사 (symbolic representations 사용).

- FROZENLAKE:

- Grid-based frozen lake에서 agent가 'holes'에 빠지지 않고 destination에 도달.

- MAZE, MINIBEHAVIOR보다 더 다양한 image details, 더 복잡한 environment (holes의 존재).

- Fine-grained pattern recognition 필요.

이 논문만의 특징:

- 일반적인 task가 아닌, MVoT의 장점을 부각할 수 있는 task 선정:

- Dynamic object localization, environment evolution understanding, action outcome prediction 능력을 모두 평가.

- 단순 symbolic representations (MAZE, MINIBEHAVIOR)부터 fine-grained details (FROZENLAKE)까지 다양한 level의 complexity 포함.

쉬운 설명:

이 섹션에서는 MVoT 모델의 능력을 테스트하기 위해 사용한 세 가지 "게임"을 소개합니다.

- MAZE: 가장 간단한 게임으로, 주어진 길(action sequence)을 따라 미로를 빠져나가는 것입니다. MVoT가 기본적인 공간 추론 능력이 있는지 확인합니다.

- MINIBEHAVIOR: 조금 더 복잡한 게임으로, "프린터를 찾아서 테이블 위에 놓고 켜는" 미션을 수행해야 합니다. 이 게임에서는 물건(프린터)을 집고, 옮기고, 놓는 등의 행동(interaction)이 추가됩니다.

- FROZENLAKE: 가장 어려운 게임으로, 얼음판 위에서 구멍(holes)을 피해 목적지까지 가야 합니다. 이 게임은 미로 게임보다 훨씬 더 복잡한 그림(얼음판, 구멍 등)을 이해해야 합니다.

이 세 가지 게임을 통해, MVoT가 단순히 그림을 "보는" 것뿐만 아니라, 그림 속 상황을 이해하고, 주어진 행동에 따라 어떤 결과가 나올지 예측하는 능력을 평가합니다. 이 논문에서는 일반적인 게임이 아니라, MVoT의 "visual thinking" 능력을 잘 보여줄 수 있는 특별한 게임들을 골랐다는 점이 중요합니다.