VLM : 논문 리뷰 : UNIFIEDQA: Crossing Format Boundaries with a Single QA System

Abstract

질의 응답(QA) 작업은 추출 범위 선택, 다중 선택 등과 같은 다양한 형식을 사용하여 제기되었습니다. 이는 형식에 특화된 models로 이어졌고, 심지어 QA 커뮤니티 내의 암묵적인 분열로 이어졌습니다. 우리는 우리가 가르치고자 하는 추론 능력이 형식에 의해 좌우되지 않는다는 점을 고려할 때, 이러한 경계가 인위적이고 어쩌면 불필요하다고 주장합니다. 증거로서, 우리는 language modeling의 최신 발전을 활용하여 4가지의 다양한 형식을 포괄하는 20개의 QA 데이터 세트에서 뛰어난 성능을 보이는 단일 사전 훈련된 QA model인 UNIFIEDQA를 구축합니다. UNIFIEDQA는 개별 데이터 세트에서 자체적으로 훈련된 8개의 서로 다른 models와 동등한 성능을 보입니다. 관찰된 형식의 12개의 보지 못한 데이터 세트에 직면했을 때조차 UNIFIEDQA는 out-of-format 훈련 데이터로부터의 강력한 일반화를 보여주며 놀라울 정도로 뛰어난 성능을 보입니다. 마지막으로, 이 사전 훈련된 QA model을 특화된 models로 fine-tuning하면 10개의 사실 기반 및 상식 QA 데이터 세트에서 새로운 state-of-the-art 결과를 얻게 되어 UNIFIEDQA를 QA 시스템 구축을 위한 강력한 출발점으로 자리매김합니다.

UNIFIEDQA: 다양한 형식의 질의 응답(QA)을 위한 통합 모델

- 문제점: 기존의 QA 연구는 문제 형식(예: 객관식, 단답형 등)에 따라 특화된 모델 개발에 치중. 이는 QA 연구 커뮤니티의 분열을 초래하고, 진정한 '추론 능력' 개발에 방해.

- 핵심 주장: 추론 능력은 문제 형식에 종속되지 않으므로, 하나의 모델로 다양한 형식을 처리할 수 있어야 함.

- 제안된 솔루션: UNIFIEDQA라는 단일 사전 훈련된 QA 모델 개발. 이 모델은 4가지 다양한 형식을 포함하는 20개의 QA 데이터 세트에서 우수한 성능을 보임.

- 주요 성과:

- UNIFIEDQA는 개별 데이터 세트에 특화된 8개의 다른 모델과 동등한 성능을 나타냄.

- 학습에 사용되지 않은 12개의 새로운 데이터 세트에서도 뛰어난 일반화 능력을 보임 (out-of-format 학습의 효과).

- Fine-tuning을 통해 10개의 사실 및 상식 QA 데이터 세트에서 최신 기술(state-of-the-art) 수준의 성능을 달성.

- 결론: UNIFIEDQA는 다양한 QA 시스템 구축을 위한 강력한 기반을 제공.

정리 노트 추가 설명:

- 기존 QA 연구의 문제점을 명확히 지적하며, 형식에 치우치지 않는 추론 능력 개발의 중요성을 강조합니다.

- UNIFIEDQA의 핵심 아이디어는 '하나의 모델로 모든 형식을 처리한다'는 통합적인 접근 방식입니다.

- 실험 결과를 통해 UNIFIEDQA의 우수성을 입증합니다. 특히, 학습에 사용되지 않은 데이터에 대한 일반화 능력과 fine-tuning을 통한 성능 향상이 주목할 만합니다.

- 결론에서 UNIFIEDQA의 의의를 명확히 제시하며, 향후 QA 시스템 개발에 중요한 시사점을 제공합니다.

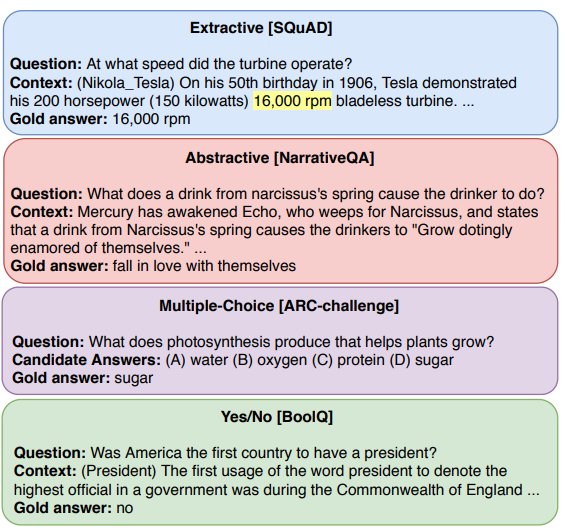

그림 1: 질문을 제시하고 답변하는 데 일반적으로 사용되는 네 가지 형식 (본 논문 전체에서 색상으로 구분): Extractive (EX), Abstractive (AB), Multiple-Choice (MC), Yes/No (YN). 샘플 dataset 이름은 대괄호 안에 표시되어 있습니다. 우리는 이러한 형식 간의 일반화 및 전이를 연구합니다.

1 Introduction

질의 응답은 컴퓨터가 언어를 얼마나 잘 이해하고 이를 가지고 추론할 수 있는지 평가하는 데 흔히 사용되는 도구입니다. 이를 위해 NLP 커뮤니티는 그림 1에 설명된 4가지의 일반적인 QA 형식과 함께 여러 개의 개별적인 datasets을 도입했습니다. 예를 들어, 일부 datasets은 정답을 "예" 또는 "아니오"로 예상하거나, (여러 개 또는 없는 span과 반대로) 관련 단락에서 고유한 정답 span을 예상합니다. 이러한 차이점들은 종종 QA 형식을 model architecture 자체에 encoding하면서, 격리된 연구를 유발했습니다. 여러 datasets을 활용하려는 노력은 여전히 단일 형식에 크게 제한되어 있습니다. 예를 들어, Clark et al. (2019c)는 multiple-choice datasets으로 고려 대상을 제한하는 반면, Talmor and Berant (2019)는 추출 span 예측 models에 대한 일반화 연구에 초점을 맞춥니다. 우리가 아는 한, 이러한 모든 형식을 목표로 하고, 능숙하게 처리하는 단일 QA 시스템은 없습니다.

이는 QA models이 형식 전반에 걸쳐 일반화되는 linguistic reasoning 능력을 학습할 수 있는지에 대한 의문을 제기합니다. 우리의 직관은 간단합니다. 질문 형식과 관련 지식은 QA datasets마다 다를 수 있지만, 기본적인 언어 이해 및 reasoning 능력은 대체로 공통적입니다. 따라서 multiple-choice model은 추출 답변 dataset에서 훈련함으로써 이점을 얻을 수 있습니다. 이러한 직관을 바탕으로, 우리는 그림 2에 나열된 20개의 서로 다른 사실 및 상식 QA datasets에서 강력한 성능을 달성하기 위해 4가지의 서로 다른 QA 형식에 걸쳐 정보를 활용하는 UNIFIEDQA라는 단일 pre-trained QA 시스템을 제시합니다.

그림 2: 본 연구에 포함된 다양한 QA datasets의 속성: 5개의 extractive (EX), 3개의 abstractive (AB), 9개의 multiple-choice (MC), 3개의 yes/no (YN). 'idk'는 'I don't know' 또는 답변할 수 없는 질문을 나타냅니다. BoolQ는 원본 dataset과 contrast-sets 확장인 BoolQ-CS를 모두 나타냅니다. ROPES, Quoref 및 DROP의 경우도 마찬가지입니다.

본 연구에서 우리는 format-agnostic QA 시스템을 구축함으로써 QA 형식에 대한 통합적인 관점을 옹호합니다. 우리의 연구는 특히 T5 (Raffel et al., 2020) 및 BART (Lewis et al., 2020)와 같은 text-to-text pre-trained neural models의 최근 발전을 활용하지만, 서로 다른 QA 형식에 중점을 둡니다. 이 paradigm은 이전에는 task-specific 디자인을 가졌던 많은 NLP models을 단일 text-to-text framework로 통합할 수 있게 합니다. 이전 연구에서는 텍스트 prefix를 사용하여 각 입력 instance와 관련된 task를 명시적으로 정의합니다 (Raffel et al., 2020; Radford et al., 2019b). 종종 여러 NLP tasks를 위한 단일 model을 구축하려는 이러한 시도는 표준 pre-training과 fine-tuning 설정 (task 당 하나의 model)보다 성능이 저조합니다 (Raffel et al., 2020). 우리의 연구는 QA의 경계 내에 머무르는 tasks로 범위를 좁혀, 통합된 text-to-text paradigm이 실제로 서로 다른 QA tasks 및 형식에서 성공할 수 있음을 보여줍니다. 우리는 format-specific prefix를 사용하지 않고 자연 텍스트를 입력으로 사용하여 여러 형식의 seed QA datasets 세트에서 text-to-text models을 훈련하여 단일 pre-trained QA model을 개발합니다. 우리의 실험은 UNIFIEDQA가 다른 QA tasks에 그대로 적용될 수 있고, 다른 보지 못한 datasets (zero-shot)으로 잘 일반화되며, 추가 fine-tuning을 통해 상식 및 사실 datasets을 포함한 많은 QA tasks에서 state-of-the-art 결과를 달성함을 보여줍니다.

기여. 본 연구는 서로 다른 QA 형식에 대한 통합된 관점과 format-agnostic QA 시스템 구축을 옹호합니다. 이러한 관점을 뒷받침하기 위해, 우리는 서로 다른 형식을 가진 datasets에서 잘 작동하고 일반화되는 단일 pre-trained QA 시스템인 UNIFIEDQA를 제시하며 (§6.2), 각 dataset에 맞춰진 state-of-the-art 전용 시스템과 동등한 성능을 보입니다 (§6.1). 또한, UNIFIEDQA를 특화된 시스템으로 fine-tuning하면 10개의 datasets에 대한 새로운 state of the art를 설정하여 (§6.3), QA 연구를 위한 강력한 출발점으로 자리매김합니다. 우리의 연구 결과는 QA 형식 경계를 넘는 것이 질적으로 바람직할 뿐만 아니라 양적으로도 유익함을 보여줍니다.

1. 서론 정리 노트: 다양한 QA 형식을 아우르는 통합 모델의 필요성

- 배경: 질의 응답(QA)은 컴퓨터의 언어 이해 및 추론 능력을 평가하는 중요한 도구. NLP 분야에서는 다양한 형식의 QA 데이터셋이 존재. (그림 1 참조: Extractive, Abstractive, Multiple-Choice, Yes/No)

- 기존 연구의 한계:

- 기존 QA 연구는 특정 형식에 특화된 모델 개발에 집중.

- QA 형식이 모델 아키텍처에 직접적으로 반영되는 경향.

- 여러 데이터셋을 활용하려는 시도는 대부분 단일 형식에 제한적. (예: 객관식에만 집중하거나, 추출형에만 집중하는 연구들)

- 다양한 형식을 모두 효과적으로 다루는 단일 QA 시스템은 부재.

- 핵심 질문: QA 모델이 형식에 상관없이 일반화될 수 있는 언어적 추론 능력을 학습할 수 있는가?

- 저자들의 직관: 질문 형식과 관련 지식은 데이터셋마다 다를 수 있지만, 기본적인 언어 이해 및 추론 능력은 공통적. 따라서, 한 형식의 학습이 다른 형식의 학습에 도움이 될 수 있음. (예: 객관식 모델이 추출형 데이터셋 학습을 통해 이점 획득 가능)

- 제안: 다양한 QA 형식을 아우르는 단일 pre-trained QA 시스템, UNIFIEDQA를 제시. (그림 2 참조: 20개의 다양한 factoid 및 상식 QA 데이터셋에서 좋은 성능을 목표)

- 연구 방향: format-agnostic QA 시스템 구축을 통해 QA 형식에 대한 통합적인 시각을 제시. Text-to-text pre-trained 모델(T5, BART) 활용, 특히 다양한 QA 형식에 초점을 맞춤.

- 기존 text-to-text 모델의 문제점: 기존 연구에서는 task-specific prefix를 사용하여 각 입력 instance의 task를 명시적으로 정의했으나, 이는 task별 모델을 사용하는 것보다 성능이 좋지 않은 경향이 있었음.

- 본 연구의 차별점: QA라는 범위 내의 task에 집중하여, 통합된 text-to-text paradigm이 다양한 QA task 및 형식에서 성공할 수 있음을 보임. Format-specific prefix를 사용하지 않고, 여러 형식의 seed QA 데이터셋으로 text-to-text 모델을 훈련하여 단일 pre-trained QA 모델을 개발.

- 기대 효과: UNIFIEDQA는 다양한 QA task에 그대로 적용 가능하며, 다른 unseen 데이터셋에도 잘 일반화(zero-shot). 추가 fine-tuning을 통해 state-of-the-art 달성 가능.

- 기여: 다양한 QA 형식에 대한 통합적 시각 제시, format-agnostic QA 시스템 구축 옹호. UNIFIEDQA를 통해 다양한 형식의 데이터셋에서 좋은 성능과 일반화 능력 입증. Fine-tuning을 통해 새로운 state of the art 달성. QA 형식 경계를 넘는 것이 질적, 양적으로 모두 유익함을 보임.

정리 노트 추가 설명:

- 기존 연구의 문제점을 명확히 지적하며, 다양한 QA 형식을 통합적으로 다루는 모델의 필요성을 강조.

- UNIFIEDQA의 핵심 아이디어는 "하나의 모델로 모든 형식을 처리한다"는 통합적인 접근 방식.

- Text-to-text 모델을 활용하되, 기존 방식의 문제점을 개선하여 QA에 특화된 새로운 접근 방식을 제시.

- 실험 결과에 대한 기대 효과를 명시하며, 연구의 의의를 강조.

2 관련 연구

여러 QA 연구에서 단일 형식의 datasets 간의 일반화를 연구했습니다. 예를 들어, MultiQA에서 Talmor and Berant (2019)는 일반화와 전이를 연구하지만, 오직 추출 span 선택 datasets에 대해서만 연구합니다. 또한, 그들은 강력한 leave-one-out 스타일 결과를 보여주지만, 단일 시스템이 각 dataset에 맞춰진 시스템보다 상당히 성능이 나쁘다는 것을 발견합니다. ORB에서 Dua et al. (2019a)는 추출 및 abstractive 형식을 포괄하는 multi-dataset 평가 benchmark를 제안합니다. 그러나 해당 연구는 시스템 평가에 국한되어 있으며, 이러한 일반화된 models을 구축하는 방법을 다루는 데는 미치지 못합니다. MRQA shared task (Fisch et al., 2019)는 span-prediction datasets에 초점을 맞춥니다. 이러한 모든 노력과는 달리, 우리의 목표는 서로 다른 QA 형식 간의 전이와 일반화를 조사하는 것뿐만 아니라, 이를 잘 수행하는 단일 시스템을 구축하는 것입니다.

machine learning tasks 간의 공통점을 활용하는 것은 transfer learning (Caruana, 1997; Clark et al., 2019b)에서 연구된 풍부한 역사를 가지고 있습니다. McCann et al. (2018) 및 Keskar et al. (2019)는 다양한 NLP tasks를 단일 QA 형식으로 변환하여 이들 간의 전이를 연구합니다. 이는 우아한 transfer learning 접근 방식이지만, 본 연구의 목표와는 직교합니다. 앞서 언급했듯이, Raffel et al. (2020)은 여러 다양한 NLP tasks (기계 번역, 요약 등) 간의 전이를 조사합니다. 그들의 핵심 기여는 입력과 출력을 모두 텍스트로 encoding하여 여러 tasks를 더 쉽게 혼합할 수 있도록 하는 text-to-text framework와 T5라는 강력한 model입니다. 그들은 각 입력 instance에 해당하는 task를 명시적으로 정의하기 위해 텍스트 prefix에 의존합니다. 우리는 그들의 framework을 기반으로 하지만, QA의 변형에 초점을 좁힙니다. 이를 통해 format-specific prefix에 의존하지 않고도 강력한 결과를 얻을 수 있습니다. 우리의 models은 내용에 따라 각 입력 질문의 형식을 추론하는 방법을 학습합니다 (예: 질문의 어구가 yes/no 답변을 요구하는지 여부). 또한, 이전 연구에서는 너무 광범위한 NLP tasks에 초점을 맞추었기 때문에 달성하지 못했던 QA tasks 간의 일반화를 입증할 수 있습니다.

2. 관련 연구 정리 노트: 기존 연구의 한계와 본 연구의 차별성

- 기존 QA 연구의 동향:

- 기존 연구들은 주로 단일 형식의 데이터셋 내에서의 일반화에 초점을 맞추었음.

- 예시 1: MultiQA (Talmor and Berant, 2019): 추출형 span 선택 데이터셋 내에서의 일반화 및 전이 연구. Leave-one-out 방식에서 좋은 결과를 보였지만, 단일 시스템이 각 데이터셋에 특화된 시스템보다 성능이 떨어지는 문제점을 보임. 즉, 여러 데이터셋에 일반적인 성능을 보이는 모델을 만드는 데는 실패.

- 예시 2: ORB (Dua et al., 2019a): 추출형과 추상형 형식을 포함하는 multi-dataset 평가 benchmark 제안. 하지만, 시스템 평가에만 그쳤을 뿐, 일반화된 모델을 어떻게 구축할지에 대한 방법론은 제시하지 못함.

- 예시 3: MRQA shared task (Fisch et al., 2019): span-prediction 데이터셋에 초점을 맞춤. 역시 단일 형식에 집중.

- 본 연구의 차별성:

- 기존 연구들과 달리, 서로 다른 QA 형식 간의 전이 및 일반화를 조사하는 것을 목표로 함.

- 이를 효과적으로 수행하는 단일 시스템을 구축하는 것을 목표로 함. 즉, 다양한 형식의 QA 데이터를 하나의 모델로 학습시켜 모든 형식에서 좋은 성능을 내는 모델을 만들고자 함.

- Transfer learning 관련 연구:

- Transfer learning은 여러 machine learning task 간의 공통성을 활용하는 연구 분야로, 오랜 역사를 가지고 있음.

- 예시 1: McCann et al. (2018), Keskar et al. (2019): 다양한 NLP task를 단일 QA 형식으로 변환하여 task 간의 전이를 연구. 이는 본 연구와는 직교하는 접근 방식. 즉, 모든 task를 QA로 변환하는 것이 아닌, QA 내의 다양한 형식을 통합하는 것이 본 연구의 목표.

- 예시 2: Raffel et al. (2020): 여러 다양한 NLP task(기계 번역, 요약 등) 간의 전이를 연구. Text-to-text framework와 T5 모델을 제시하여 입력과 출력을 모두 텍스트로 encoding함으로써 여러 task를 쉽게 혼합할 수 있도록 함.

- 본 연구의 차별성 (Raffel et al. (2020)과의 비교):

- Raffel et al. (2020)의 text-to-text framework를 기반으로 함.

- 하지만, NLP task 전반이 아닌 QA라는 특정 범위에 초점을 맞춤.

- Task 구분을 위해 format-specific prefix를 사용하지 않음. 모델이 질문의 내용 자체로부터 형식을 추론하도록 학습. (예: 질문의 어투를 통해 yes/no 답변을 요구하는 질문인지 판단)

- 너무 광범위한 NLP task에 집중했던 이전 연구와 달리, 본 연구는 QA task 간의 일반화를 입증하는 데 성공.

정리 노트 추가 설명:

- 기존 연구들의 한계를 명확하게 지적하면서, 본 연구의 차별성을 부각.

- 특히, 단일 형식에 집중했던 기존 연구들과 달리, 다양한 형식의 통합에 초점을 맞추고 있음을 강조.

- Transfer learning 관련 연구와의 관계를 설명하면서, 본 연구의 독자적인 방향성을 명확히 함.

- Text-to-text framework를 활용하되, prefix를 사용하지 않는다는 점을 강조하며, 모델이 질문 자체의 의미를 파악하도록 학습시키는 것이 핵심임을 설명.

3 UNIFIEDQA: 다중 형식 훈련

k개의 형식 F1, F2, ..., Fk에 걸쳐 작동할 수 있는 통합된 QA model을 훈련시키고자 한다고 가정해 보겠습니다. 각 형식 Fi에 대해, Di1, Di2, ..., Dii 와 같은i datasets sets가 있다고 가정합니다. 여기서 Dij = (Tij, Eij)는 훈련 및 평가 예제를 모두 포함합니다. 어떤 경우에는 훈련 세트 Tij가 비어 있거나, Dij를 '보지 못한', 평가 전용 dataset으로 취급하고 model의 일반화를 평가하기 위해 이를 무시하고 싶을 수 있습니다.

우리는 text-to-text paradigm을 사용하여 형식 Fi의 각 훈련 질문 q를 일반 텍스트 입력 표현 enci(q)로 변환합니다. 이 변환은 곧 (§3.1) 네 가지 일반적인 QA 형식에 대해 설명될 자연스러운 encoding 프로세스를 사용하며, 다른 형식으로도 쉽게 확장할 수 있습니다. 우리는 사용 가능한 모든 훈련 instance로 구성된 혼합 훈련 풀을 만드는 간단한 접근 방식을 따릅니다.

T˜ = [ k ∑ i=1 [ `i ∑ j=1 {enci(q) | q ∈ Tij} ] ]

훈련 배치는 크기에 관계없이 각 훈련 세트에서 평균적으로 동일한 수의 instance를 포함하도록, 확률 1/|Tij|에 비례하여 각 q ∈ Tij를 포함하여 이 풀링된 데이터 T˜에서 가져옵니다. task 혼합에 대한 유사한 처리는 Arivazhagan et al. (2019) 및 Raffel et al. (2020)에서도 채택되었습니다. 우리의 실험에서 보여주듯이, 우리의 다중 형식 혼합 접근 방식은 잘 작동합니다. 이는 out-of-format 데이터 훈련의 가치를 명확히 강조하고, 기본적인 reasoning 능력 측면에서 QA 형식 간에 강력한 연관성이 있다는 우리의 직관을 확인시켜 줍니다.

우리의 통합 질의 응답 시스템은 최근의 text-to-text frameworks, 특히 T5 (Raffel et al., 2020) 및 BART (Lewis et al., 2020)를 기반으로 합니다. 먼저 다양한 형식에 걸쳐 instance의 통합 encoding을 정의합니다 (§3.1). 그런 다음 여러 형식의 datasets에서 훈련된 QA 시스템인 UNIFIEDQA를 소개합니다 (§3.2). 이는 10개의 datasets에서 새로운 state-of-the-art 결과를 나타내고 보지 못한 datasets으로의 일반화를 보여줍니다.

3.1 Text-to-Text Encoding

우리는 목표 datasets 각각을 text-in/text-out 형식으로 변환합니다 (Raffel et al., 2020; Lewis et al., 2020; Radford et al., 2019b). 질문은 항상 먼저 나오고, 그 뒤에 추가 정보 (맥락 단락 또는 후보 답변, 또는 둘 다)가 나옵니다. 우리는 입력의 여러 부분 사이에 "\n" 구분 기호를 사용합니다. 이렇게 하면 특정 형식에 지나치게 특화되지 않으면서 인간과 같은 encoding을 보장할 수 있습니다.

우리의 통합 model은 다음 네 가지 일반적인 질의 응답 형식을 통합합니다. 이들 내의 특정 datasets은 4.1절에서 다룹니다.

Extractive (EX) 질문 Q는 맥락 단락 C (일반적으로 단락)를 포함하며, models은 맥락에서 정답을 substring으로 추출해야 합니다. 일부 datasets에서는 '답변 불가'가 정답이 될 수도 있습니다.

Abstractive (AB) 질문 Q는 models이 제공된 맥락 단락 C의 단순한 substring이 아닌 답변을 생성하도록 요구합니다.

Multiple-choice (MC) 질문 Q는 일반적으로 정확히 하나의 정답이 있는 후보 답변 {Ai} 세트와 함께 제공됩니다. 어떤 경우에는 맥락 단락 C도 포함합니다.

Yes/No (YN) 질문 Q는 응답으로 'yes' 또는 'no' 답변을 예상하며 맥락 단락 C를 포함할 수 있습니다.

표 1은 입력과 출력 표현이 모두 원시 텍스트인 이러한 각 형식에 대한 자연스러운 입력 및 출력 encoding의 예시를 제공합니다. 질문이 MC 질문인지 또는 정확히 네 개의 후보 답변을 가지고 있는지에 대한 명시적인 정보는 없습니다. 특히, 맥락 단락이 없는 MC 질문은 질문 \n (A) c1 (B) c2 ... 로 encoding됩니다. 여기서 c1, c1, ...는 후보 답변 세트입니다 (ARC dataset의 예시 참조). 질문에 맥락 단락이 포함된 경우, MCTest dataset의 예에서와 같이 후보 답변 뒤에 추가됩니다: 질문 \n (A) c1 (B) c2 ... \n 단락. 다른 세 가지 형식 (EX, AB, YN)의 질문은 간단히 질문 \n 단락으로 encoding됩니다.

다시 강조하지만, 이전 연구 (Raffel et al., 2020)와 달리, 우리는 입력 표현에서 task, dataset 또는 format-specific prefix를 지정하지 않습니다. 답변을 추출해야 하는지 또는 abstract해야 하는지, 그리고 제공된 맥락 단락 또는 후보 답변 (또는 이것들이 심지어 후보 답변이라는 사실)에서 추출해야 하는지는 시스템에서 추론해야 합니다.

3.2 UNIFIEDQA: Pre-Trained Model

우리가 제공하고 모든 실험에서 사용하는 특정 pre-trained QA model은 앞에서 논의한 4가지 형식 각각의 대표적인 datasets에서 훈련됩니다. 우리는 out-of-format 훈련에 가장 가치 있는 datasets을 평가하는 파일럿 연구에서 효과를 기반으로 다음 8개의 seed datasets을 UNIFIEDQA 훈련에 대해 경험적으로 선택했습니다 (자세한 내용은 5절에서 다룹니다).

- EX: SQuAD 1.1, SQuAD 2.0

- AB: NarrativeQA

- MC: RACE, ARC, OBQA, MCTest

- YN: BoolQ

우리의 UNIFIEDQA model의 변형을 만들기 위해 다른 형식과 datasets 조합을 쉽게 사용할 수 있거나, 향후 datasets이 제공되거나 새로운 형식이 도입됨에 따라 이를 확장할 수 있습니다.

달리 명시되지 않는 한, 우리는 model 훈련의 시작점으로 사용 가능한 가장 큰 T5 model (11B parameters)을 사용하고 시스템을 UNIFIEDQA라고 부릅니다. 또한 UNIFIEDQABART라고 하는 BARTlarge로 시스템을 훈련한 결과도 보고합니다 (§6.3). 사용된 models의 parameters에 대한 자세한 내용은 부록 A.2에서 다룹니다. pre-trained language models와 유사하게, 결과 pre-trained QA model은 다른 QA datasets에서 fine-tuning하기 위한 시작점으로 사용할 수 있습니다.

3. UNIFIEDQA: 다중 형식 훈련 정리 노트

3.1. 목표: 단일 모델로 다양한 QA 형식 처리

- k개의 QA 형식 (F1, F2, ..., Fk)을 포괄하는 통합된 QA 모델 훈련이 목표.

- 각 형식 Fi는 i개의 데이터셋 (Di1, Di2, ..., Dii)을 가짐.

- 각 데이터셋 Dij는 훈련 및 평가 예제를 포함: Dij = (Tij, Eij)

- 평가 전용 데이터셋으로 취급하기 위해 훈련 세트 Tij를 비우거나 무시할 수 있음 (모델의 일반화 능력 평가 목적).

3.2. 훈련 방식: Text-to-Text 패러다임 및 데이터 혼합

- Text-to-text 패러다임 사용: 각 형식 Fi의 질문 q를 일반 텍스트 입력 표현 enci(q)로 변환. (§3.1에서 자세히 설명)

- 모든 가용한 훈련 instance를 혼합한 훈련 풀 생성:

- T˜ = [ k ∑ i=1 [ `i ∑ j=1 {enci(q) | q ∈ Tij} ] ]

- 각 훈련 세트의 크기에 관계없이, 각 훈련 세트에서 평균적으로 동일한 수의 instance가 포함되도록 훈련 배치 구성 (각 q ∈ Tij는 확률 1/|Tij|에 비례하여 포함).

- 이러한 task 혼합 방식은 Arivazhagan et al. (2019)과 Raffel et al. (2020)에서도 사용됨.

- 본 연구의 다중 형식 혼합 방식의 효과 입증 (실험 결과에서 확인).

- Out-of-format 데이터 훈련의 가치 강조 및 QA 형식 간의 reasoning 능력의 연관성 확인.

3.3. 시스템 기반: Text-to-Text Frameworks 활용

- 최근의 text-to-text frameworks, 특히 T5 (Raffel et al., 2020) 및 BART (Lewis et al., 2020) 기반.

- 다양한 형식에 걸쳐 instance의 통합 encoding 정의 (§3.1).

- 다중 형식 데이터셋에서 훈련된 QA 시스템 UNIFIEDQA 소개 (§3.2).

- 10개의 데이터셋에서 새로운 state-of-the-art 결과 달성 및 unseen 데이터셋으로의 일반화 입증.

3.4. Text-to-Text Encoding 상세 (§3.1)

- 각 목표 데이터셋을 text-in/text-out 형식으로 변환.

- 질문이 항상 먼저 나오고, 추가 정보 (맥락 단락, 후보 답변 또는 둘 다)가 뒤따름.

- 입력의 여러 부분 사이에 "\n" 구분 기호 사용 (인간과 유사한 encoding 방식).

- 다음 네 가지 일반적인 질의 응답 형식 통합:

- Extractive (EX): 맥락 단락에서 정답을 substring으로 추출.

- Abstractive (AB): 맥락 단락의 단순한 substring이 아닌 답변 생성.

- Multiple-choice (MC): 후보 답변 세트에서 정답 선택 (맥락 단락 포함 가능).

- Yes/No (YN): 'yes' 또는 'no'로 답변 (맥락 단락 포함 가능).

- 표 1에서 각 형식에 대한 자연스러운 입력 및 출력 encoding 예시 제공.

- MC 질문의 encoding 방식 설명 (맥락 단락 유무에 따른 차이).

- 핵심: 이전 연구 (Raffel et al., 2020)와 달리, task, 데이터셋 또는 형식별 prefix를 입력 표현에 사용하지 않음. 답변 추출/생성 여부, 맥락 단락/후보 답변에서의 추출 여부 등을 시스템이 스스로 추론하도록 학습.

3.5. UNIFIEDQA: Pre-Trained Model 상세 (§3.2)

- 4가지 형식 각각의 대표적인 데이터셋에서 훈련된 pre-trained QA 모델 제공.

- Out-of-format 훈련에 가장 효과적인 8개의 seed 데이터셋을 파일럿 연구를 통해 경험적으로 선택 (자세한 내용은 5절에서 다룸):

- EX: SQuAD 1.1, SQuAD 2.0

- AB: NarrativeQA

- MC: RACE, ARC, OBQA, MCTest

- YN: BoolQ

- 다른 형식 및 데이터셋 조합을 사용하여 UNIFIEDQA 모델의 변형 생성 가능.

- 달리 명시되지 않는 한, 가장 큰 T5 모델 (11B parameters)을 훈련 시작점으로 사용하며, 이 시스템을 UNIFIEDQA라고 부름.

- BARTlarge로 훈련한 결과는 UNIFIEDQABART라고 하며, §6.3에서 보고.

- 모델의 parameters에 대한 자세한 내용은 부록 A.2에서 다룸.

- pre-trained language models와 유사하게, 결과 pre-trained QA 모델은 다른 QA 데이터셋에서 fine-tuning하기 위한 시작점으로 사용 가능.

정리 노트 추가 설명:

- 다양한 QA 형식을 하나의 모델로 처리하기 위한 훈련 방식 및 시스템 구조를 명확하게 설명.

- Text-to-text 패러다임, 데이터 혼합 방식, prefix 미사용 등 핵심적인 특징들을 강조.

- 기존 연구와의 차별성을 명확히 제시.

- 구체적인 데이터셋 및 모델 정보를 제공하여 이해를 도움.