VLM : 논문 리뷰 : VisionZip: Longer is Better but Not Necessary in Vision Language Models

VisionZip: Longer is Better but Not Necessary in Vision Language Models 논문 리뷰

Purpose of the Paper

기존의 Vision-Language Models (VLMs)은 visual tokens의 수를 늘려 성능을 향상시키는 데 집중해 왔습니다. 그러나 이는 text tokens에 비해 visual tokens의 수가 지나치게 많아져 computational cost를 크게 증가시키는 문제를 야기했습니다. 본 논문은 visual tokens에 상당한 redundancy가 존재한다는 점에 착안하여, informative tokens만을 선별하여 language model에 입력함으로써, VLM의 성능은 유지하면서도 효율성을 크게 개선하는 것을 목적으로 합니다. 즉, 무작정 visual tokens의 길이를 늘리는 대신, **"꼭 필요한 정보만 골라 효율적으로 사용하자"**는 것이 이 논문의 핵심적인 목적입니다.

Key Contributions

- Redundancy Observation: CLIP, SigLIP 등 널리 사용되는 vision encoders에서 생성된 visual tokens에 상당한 redundancy가 존재함을 체계적으로 분석하고 시각화하여 증명했습니다.

- VisionZip Framework: Informative tokens를 선별하고, 덜 중요한 tokens는 merging하는 VisionZip이라는 새로운 framework를 제안합니다. VisionZip은 text-agnostic한 방식을 사용하기 때문에 다양한 VLM에 적용될 수 있습니다.

- Efficient Tuning Strategy: Visual token count 감소로 인한 visual input space와 LLM space 사이의 slight misalignment를 보정하기 위해, projector layer를 fine-tuning하는 효율적인 방법을 제시합니다.

- Performance and Efficiency Improvement: VisionZip을 LLaVA-1.5, LLaVA-NeXT, Mini-Gemini 등 다양한 VLM에 적용하여, 성능 저하를 최소화하면서도 inference speed를 크게 향상시켰습니다. 특히, LLaVA-NeXT 13B 모델에서 prefilling time을 8배 단축하고, LLaVA-NeXT 7B 모델보다 빠른 inference 속도와 더 나은 성능을 달성했습니다.

Novelty

- Text-Agnostic Token Selection: 기존의 Efficient VLM 연구들이 text-relevant visual tokens를 선별하는 데 집중한 반면, VisionZip은 text 정보와 무관하게 image 자체의 information을 기반으로 informative tokens를 선별합니다. 이는 multi-turn dialogue와 같이 text 정보가 제한적인 상황에서도 효과적으로 작동할 수 있음을 의미합니다.

- Contextual Token Merging: Dominant tokens를 선별하는 것 외에도, remaining tokens를 semantic similarity를 기반으로 merging하여 contextual tokens를 생성함으로써, 정보 손실을 최소화하고 contextual information을 보존합니다.

- Focus on Vision Encoder: 본 논문은 VLM의 효율성 개선을 위해 vision encoder 자체의 redundancy를 줄이는 데 초점을 맞춥니다. 이는 기존 연구들이 LLM 단에서의 token pruning에 집중했던 것과 차별화되는 접근 방식입니다.

Experimental Highlights

- Extensive Evaluation: 11개의 image understanding benchmarks와 4개의 video understanding benchmarks를 사용하여 VisionZip의 효과를 다각도로 검증했습니다.

- State-of-the-Art Performance: VisionZip은 training-free scenario에서도 기존의 state-of-the-art Efficient VLM methods (FastV, SparseVLM)를 큰 폭으로 능가하는 성능을 보였습니다.

- Significant Efficiency Gains: VisionZip은 LLaVA-NeXT 7B 모델의 prefilling time을 8배 단축하고, LLaVA-NeXT 13B 모델이 LLaVA-NeXT 7B 모델보다 빠른 inference 속도와 더 나은 성능을 달성하도록 했습니다.

- Compatibility with Quantization: VisionZip은 quantization techniques와 호환되어, memory usage를 더욱 줄이면서도 성능을 유지할 수 있음을 보였습니다.

- Multi-Turn Conversation Advantage: VisionZip은 multi-turn conversation에서도 높은 성능을 유지하며, 기존 text-relevant methods 대비 우위를 보였습니다.

Limitations

- Dependence on Attention Mechanism: VisionZip은 vision encoder의 attention mechanism에 의존하여 informative tokens를 선별합니다. 따라서 attention mechanism을 사용하지 않는 vision encoder에는 적용하기 어려울 수 있습니다.

- Optimal Token Count Selection: VisionZip의 성능은 retained visual tokens의 수에 영향을 받습니다. 최적의 token count는 task와 dataset에 따라 달라질 수 있으며, 이를 자동으로 결정하는 방법에 대한 추가 연구가 필요합니다.

- Fine-tuning Overhead: VisionZip은 최상의 성능을 위해 projector layer의 fine-tuning을 필요로 합니다. 비록 30분 내외의 짧은 시간이 소요되지만, 추가적인 computational cost가 발생합니다.

Future Work

- Adaptive Token Selection: Task와 input image에 따라 optimal token count를 dynamically 조정하는 adaptive token selection 방법을 연구할 수 있습니다.

- Vision Encoder with Reduced Redundancy: VisionZip의 연구 결과를 바탕으로, redundancy가 적은 visual tokens를 생성하는 새로운 vision encoder architecture를 개발할 수 있습니다.

- Extension to Other Modalities: VisionZip의 아이디어를 text, audio 등 다른 modalities로 확장하여, multi-modal models의 효율성을 개선하는 연구를 진행할 수 있습니다.

- Exploration of Other Merging Strategies: Contextual tokens를 생성하기 위해, self-attention mechanism 외에 다른 merging strategies를 탐색할 수 있습니다.

Abstract

최근 vision-language models의 발전은 visual tokens의 길이를 늘려 성능을 향상시켰으며, 이로 인해 visual tokens이 text tokens보다 훨씬 길어져 계산 비용이 크게 증가했습니다. 그러나 우리는 CLIP 및 SigLIP와 같은 인기 있는 vision encoders에 의해 생성된 visual tokens에 상당한 중복성이 포함되어 있음을 관찰했습니다. 이를 해결하기 위해, 우리는 language model에 대한 입력으로 유익한 tokens 집합을 선택하여 visual token 중복성을 줄이고 모델 성능을 유지하면서 효율성을 향상시키는 간단하면서도 효과적인 방법인 VisionZip을 소개합니다. 제안된 VisionZip은 image 및 video understanding tasks에 광범위하게 적용될 수 있으며, 이전 방법들이 성능이 떨어지는 경향이 있는 실제 시나리오의 multi-turn dialogues에 적합합니다. 실험 결과는 VisionZip이 거의 모든 설정에서 최소 5%의 성능 향상을 통해 이전 state-of-the-art 방법을 능가한다는 것을 보여줍니다. 더욱이, 우리의 방법은 모델 inference 속도를 크게 향상시켜 prefilling 시간을 8배 향상시키고 LLaVA-Next 13B 모델이 LLaVA-Next 7B 모델보다 더 나은 결과를 달성하면서 더 빠르게 infer 할 수 있도록 합니다. 또한, 우리는 이러한 중복성의 원인을 분석하고 커뮤니티가 단순히 token 길이를 늘리기보다는 더 나은 visual features를 추출하는 데 집중하도록 장려합니다.

- Introduction

최근 Large Language Models (LLMs)의 발전은 Vision Language Models (VLMs)의 상당한 진전으로 이어졌습니다. visual signals을 textual semantics와 통합하기 위해, 기존 VLMs은 일반적으로 sequential visual representation을 활용하며, 여기서 images는 vision tokens으로 변환되고 LLM decoder에 의해 처리됩니다. modal alignment와 instruction tuning을 통해 이러한 VLMs은 LLMs를 vision domain에 맞게 조정하여 인식 및 reasoning capabilities를 활용합니다.

그러나 VLMs의 유망한 성능은 주로 대량의 visual tokens에 의존합니다. 예를 들어, LLaVA-1.5에서는 visual tokens의 수가 576개이고, LLaVA-NeXT에서는 672x672 image가 576x5=2880개 이상의 tokens을 생성하는 반면, text tokens의 수는 수십 개에서 100개를 조금 넘는 정도입니다. 이러한 과도하게 긴 visual tokens은 전체 VLM에서 상당한 양의 memory와 computation을 소비하여 edge computing, autonomous driving, robotics와 같은 실제 응용 시나리오에서 모델의 개발을 제한합니다. 더욱이, 많은 이전 연구들을 기반으로 우리는 images에 포함된 정보가 text보다 훨씬 희소하다는 것을 알고 있습니다. 대조적으로, 기존의 state-of-the-art VLMs은 text tokens보다 훨씬 더 많은 visual tokens을 가지고 있습니다. 따라서 자연스럽게 "모든 visual tokens이 필요한가?"라는 질문이 생깁니다.

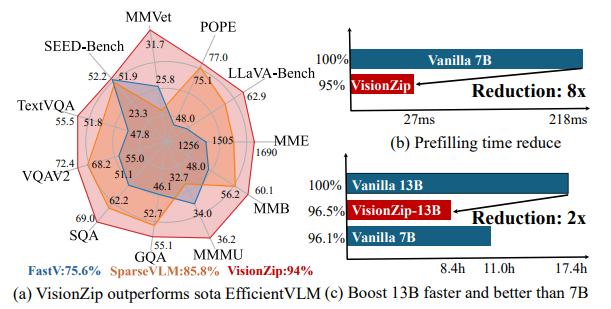

Figure 1. VisionZip Performance and Efficiency. (a) 우리의 VisionZip은 LLaVA-1.5의 11개 benchmarks에서 tokens의 10%만으로 약 95%의 성능을 달성하여 현재 SOTA EfficientVLM 모델인 FastV, SparseVLM을 크게 능가합니다. (b) VisionZip은 LLaVA-NeXT 7B의 prefilling 시간을 8배 단축할 수 있습니다. (c) VisionZip은 11개 benchmarks에서 GPU inference 시간을 2배 단축하여 LLaVA-NeXT 13B 모델이 7B 모델보다 더 나은 결과를 달성하면서 더 빠르게 infer할 수 있도록 합니다.

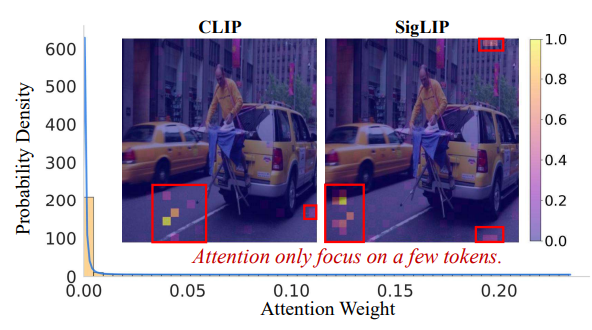

이를 탐구하기 위해, 우리는 널리 사용되는 vision encoders인 CLIP 및 SigLIP에 의해 생성된 visual tokens에 대한 pilot study를 수행합니다. 그림 2에서 볼 수 있듯이, 통계 및 시각적 분석에 따르면 오직 소수의 tokens만이 높은 attention을 받고 많은 양의 정보를 포함하는 반면, 대부분의 visual tokens은 최소한의 attention을 받고 제한된 정보를 집계합니다. 이러한 관찰을 바탕으로 우리는 visual tokens에 상당한 양의 중복이 있다는 질문에 답할 수 있습니다. 이 현상에 대한 관찰과 그 이면의 원인에 대한 자세한 내용은 각각 Sec. 2.2와 Sec. 4.1에 제공됩니다.

이러한 관찰을 바탕으로, 우리는 성능 저하 없이 효율성을 향상시키는 것을 목표로 visual token 중복을 줄이기 위한 솔루션을 탐구합니다. 구체적으로, 우리는 LLM을 위해 더 유익한 visual tokens을 추출하는 text-agnostic 방법인 VisionZip을 개발합니다. 우리의 방법은 training-free, fine-tuning 또는 training from scratch에 사용될 수 있습니다. 구체적으로, training-free 모드에서는 먼저 상당한 attention을 받고 image 정보의 대부분을 집계하는 dominant tokens을 선택합니다. 그런 다음 작지만 잠재적으로 중요한 세부 정보를 놓치지 않도록 token merging strategy를 사용하여 유지된 tokens을 유사성에 따라 병합하여 더 유익한 contextual tokens을 추출합니다. fine-tuning 모드(Sec. 2.4)에서는 모든 raw visual tokens을 대체할 tokens을 선택한 후, input token 수가 크게 감소하여 현재 visual input space와 LLM space 간에 약간의 misalignment가 발생합니다. 결과를 향상시키고 alignment를 개선하기 위해, 우리는 최소한의 data로 30분 동안 projector layer를 fine-tune하여 모델이 감소된 token 수에 적응할 수 있도록 합니다.

우리 방법의 효과를 입증하기 위해, 우리는 제안된 VisionZip을 인기 있는 VLM models에 적용하고 Sec. 3에서 여러 benchmarks에 대해 평가합니다. 그림 1에서 볼 수 있듯이, 결과는 training-free 시나리오에서도 우리의 방법이 속도와 성능 모두에서 이전의 state-of-the-art 방법보다 훨씬 우수하다는 것을 나타냅니다. 또한, VisionZip은 LLaVA-NeXT 7B에서 95%의 성능을 유지하면서 pre-filling 시간을 8배 줄일 수 있습니다. 제안된 VisionZip은 또한 LLaVA-NeXT 13B가 LLaVA-NeXT 7B 모델보다 더 나은 성능과 더 빠른 inference를 달성할 수 있도록 합니다. 마지막으로, 우리는 중복성의 원인을 분석하고 단순한 text-agnostic VisionZip이 이전 방법보다 더 나은 성능을 달성하는 이유를 설명하며, Sec. 4에서 multi-turn conversations와 같은 실제 배포에서 그 이점을 강조합니다.

Figure 2. Redundancy Visualization. attention scores의 시각화 및 분포 통계는 attention이 소수의 tokens에 집중되어 있는 반면, 많은 tokens은 매우 낮은 attention scores를 보여 visual tokens에 상당한 중복이 있음을 나타냅니다.

1. 문제 제기: Visual Token의 비효율성

- 핵심: LLaVA-1.5, LLaVA-NeXT와 같은 최신 VLMs은 text tokens 대비 과도하게 많은 visual tokens을 사용하며, 이는 계산 비용 증가 및 실용성 저하를 야기함.

- 근거:

- LLaVA-NeXT: 672x672 image는 2880개 이상의 visual tokens 생성, text tokens은 수십~백 개 수준.

- Image 정보는 text보다 **희소(sparse)**함에도 불구하고, visual tokens 수가 훨씬 많음.

- 질문: "모든 visual tokens이 정말 필요한가?"

2. Pilot Study: Visual Token 중복성 확인

- 대상: CLIP, SigLIP과 같은 널리 사용되는 vision encoders가 생성하는 visual tokens.

- 방법: 그림 2와 같이 attention scores의 시각화 및 통계 분석.

- 결과:

- 소수의 tokens에만 attention 집중.

- 대부분의 tokens은 매우 낮은 attention scores를 보이며, 제한된 정보만 포함.

- Visual tokens에 상당한 중복성 존재 확인.

3. 해결책: VisionZip 제안

- 목표: 성능 저하 없이 visual token 중복성을 줄여 효율성 향상.

- 방법: Text-agnostic한 VisionZip 개발.

- LLM에 더 유익한 visual tokens을 추출.

- Training-free, fine-tuning, training from scratch 모두에 적용 가능.

- Training-free 모드:

- Dominant tokens 선택 (높은 attention, image 정보 대부분 집계).

- Token merging strategy: 유사성에 따라 tokens 병합, contextual tokens 추출.

- Fine-tuning 모드:

- Raw visual tokens 대체, input token 수 감소.

- Projector layer fine-tuning (30분, 최소 data)으로 alignment 개선.

4. 결과 요약: VisionZip의 우수성

- 성능: Training-free 시나리오에서도 이전 SOTA 방법들을 능가 (그림 1).

- 효율성:

- LLaVA-NeXT 7B에서 pre-filling 시간 8배 단축, 95% 성능 유지.

- LLaVA-NeXT 13B가 7B보다 빠르고 더 나은 성능 달성.

5. 핵심 기여:

- Visual tokens의 중복성 문제 제기 및 실증적 분석.

- 효율적이고 효과적인 visual token 압축 방법 VisionZip 제안.

- Multi-turn conversations와 같은 실제 시나리오에서의 활용 가능성 제시.

결론: 이 논문은 VLMs의 효율성을 개선하기 위한 새로운 방향을 제시하며, visual tokens의 중복성 문제를 해결하는 VisionZip을 통해 실질적인 성능 향상 및 추론 시간 단축을 달성했습니다. 특히, text-agnostic한 접근 방식은 다양한 시나리오에 적용 가능하다는 점에서 큰 장점을 가집니다.

2 VisionZip

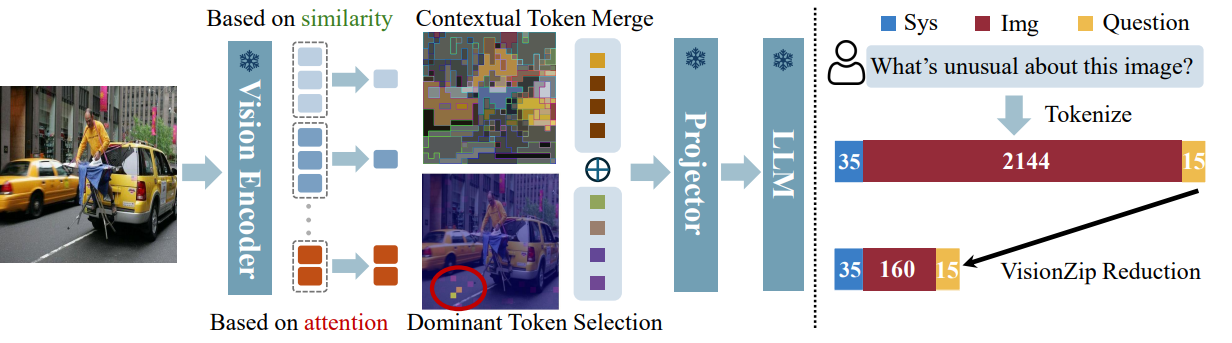

이 섹션에서는 먼저 Sec. 2.1에서 모델 효율성을 개선하기 위해 visual tokens 수를 줄이는 것의 중요성을 설명한 다음 Sec. 2.2에서 중복성에 대한 우리의 관찰을 제시합니다. 그 후, Sec. 2.3에서 training-free 방법에 대해 자세히 설명합니다. 또한 모델이 visual token 길이의 변화에 더 잘 적응하도록 돕기 위해 Sec. 2.4에서 Efficient Tuning을 소개합니다. 마지막으로 VisionZip의 광범위한 사용법에 대해 간략하게 논의합니다. 전체 architecture는 그림 3에 나와 있습니다.

Figure 3. Framework of VisionZip. VisionZip은 visual token attention scores를 기반으로 상당한 정보를 집계하는 dominant tokens을 선택합니다. 나머지 tokens은 semantic similarity를 기반으로 병합되어 contextual tokens을 생성합니다. VisionZip은 training-free 방법으로 image tokens의 수를 크게 줄여 성능을 유지하면서 inference를 가속화합니다. projector의 efficient fine-tuning을 통해 전체 token을 사용하는 것과 비교하여 최소한의 성능 손실로 더 나은 결과를 얻을 수 있습니다.

2.1. Preliminary

VLM의 Architecture. VLM architectures는 일반적으로 visual encoder, modality projector, LLM의 세 가지 components로 구성됩니다. 일반적으로 CLIP의 vision model과 같은 pre-trained image encoder인 visual encoder는 input images를 visual tokens으로 변환합니다. projector module은 이러한 visual tokens을 LLM의 word embedding space와 align하여 LLM이 visual data를 효과적으로 처리할 수 있도록 합니다. 그런 다음 LLM은 aligned 된 visual 및 textual information을 통합하여 responses를 generate 합니다.

Computation Complexity. VLMs의 computational complexity를 평가하려면 self-attention mechanism 및 feed-forward network (FFN)와 같은 주요 components를 검토해야 합니다. 총 floating-point operations (FLOPs)는 다음과 같이 표현할 수 있습니다.

Total FLOPs = T × (4nd^2 + 2n^2d + 2ndm)

여기서 T는 transformer layers의 수, n은 sequence length, d는 hidden dimension size, m은 FFN의 intermediate size를 나타냅니다.

이 방정식은 computational complexity가 sequence length n에 크게 영향을 받는다는 것을 보여줍니다. 일반적인 VLM tasks에서 sequence length는 n = n_sys + n_img + n_question으로 정의되며, n_img는 종종 다른 두 개보다 훨씬 크며 때로는 20배까지 큽니다. 따라서 n_img를 줄이는 것이 VLMs의 효율성을 개선하는 데 필수적입니다.

2.2. Redundancy Observation

LLaVA 및 MiniGemini와 같은 인기 있는 Vision Language Models에서 vision tokens의 수는 text tokens의 수를 훨씬 초과하여 상당한 computational resources를 소비합니다. 이러한 모든 tokens이 필요한지 평가하기 위해, 우리는 일반적으로 사용되는 vision encoders인 CLIP 및 SigLIP에 의해 생성된 visual tokens에 대한 pilot study를 수행했습니다.

구체적으로, 우리는 무작위로 하나의 image를 샘플링하고 대부분의 VLMs (예: LLaVA)에서 input visual tokens을 얻기 위해 선택된 layer인 Vision Encoder의 -2 layer에서 각 token의 attention을 시각화했습니다. 그림 2에서 볼 수 있듯이, CLIP과 SigLIP 모두 제한된 수의 tokens에 집중된 attention 패턴을 나타내는 반면 대다수의 visual tokens은 최소한의 attention을 받습니다. 또한, 소수의 tokens에만 attention이 집중되는 것이 정상적인 현상임을 입증하기 위해 TextVQA validation set에 대한 attention weights의 분포를 분석합니다. 그림 2에서 볼 수 있듯이, 대부분의 visual tokens은 0에 가까운 매우 낮은 attention을 받는 반면, 소수의 tokens만 더 높은 attention weights를 보유합니다. 이 현상의 보편성을 보여주기 위해 Appendix D.1에 더 많은 시각화를 포함합니다.

이러한 관찰을 바탕으로, 우리는 낮은 attention weights를 가진 대부분의 visual tokens이 거의 정보를 제공하지 않고 상당한 중복성을 추가한다는 것을 발견했습니다. 소수의 visual tokens만이 상당한 양의 정보를 집계하고 집중된 attention을 받을 가치가 있습니다. 우리는 이를 dominant visual tokens이라고 부릅니다. 따라서 중복성을 줄이기 위해 전체 token 수를 줄이기 위해 덜 유익한 tokens은 버리고 dominant visual tokens과 같이 가장 유익한 tokens을 선택하는 데 중점을 둡니다.

2.3. Informative Visual Token Zip

Dominant Token Selection. 가장 유익한 visual tokens만 유지하고 덜 중요한 tokens은 버림으로써 중복성을 줄이기 위해, 주요 과제는 어떤 tokens이 모델의 성능에 가장 크게 기여하는지 식별하는 것입니다. 우리는 vision encoder 내에서 각 visual token의 attention scores를 조사하여 중요도를 평가합니다. 구체적으로, attention score는 다음과 같이 계산됩니다.

S_h = Softmax( (Q_h * K_h^⊤) / sqrt(D_h) )

여기서 S_h는 각 head의 attention score, D_h는 head dimension, Q_h와 K_h는 각각 query와 key를 나타냅니다. head dimension에 걸쳐 평균을 내면 각 token이 다른 tokens에 어떻게 attend 하는지를 반영하는 aggregated attention matrix S_avg ∈ R^(B×SeqLen×SeqLen)이 생성됩니다.

전체 image의 정보를 집계하는 CLIP과 같은 CLS token이 있는 models의 경우, CLS token의 attention scores를 활용하여 key visual tokens을 식별합니다. Algorithm 1에서 볼 수 있듯이, CLS token이 가장 많이 attend 하는 tokens을 선택하는데, 이는 일반적으로 가장 관련성이 높은 정보를 포함하기 때문입니다. SigLIP과 같이 CLS token이 없는 models의 경우, sequence의 다른 모든 tokens에서 각 token이 받는 평균 attention을 계산합니다. 더 높은 평균 attention을 가진 tokens은 더 중요한 것으로 간주되어 유지됩니다. 이에 대한 자세한 내용은 Appendix A.2에 제공합니다.

이 프로세스를 통해 dominant visual tokens을 효율적으로 식별하고 유지할 수 있습니다. 그림 3에서 볼 수 있듯이 이러한 tokens은 거의 모든 attention을 포함하고 전체 tokens의 상당한 정보를 집계합니다.

Contextual Tokens Merging. 비록 우리가 중요도를 평가하여 dominant tokens을 선택했고 이러한 dominant tokens이 대부분의 visual information을 포함하고 있지만, 작지만 잠재적으로 중요한 정보를 잃지 않도록 나머지 tokens을 병합합니다. 구체적으로, self-attention 계산 중에 keys (K)는 이미 각 token에 포함된 정보를 요약합니다. 따라서 Algorithm 2에서 볼 수 있듯이, 먼저 non-dominant tokens을 target tokens과 merge tokens으로 균등하게 분할합니다. 그런 다음 dot product와 같은 similarity metric을 사용하여 유사한 정보를 포함하는 keys를 식별합니다. 마지막으로, 가장 유사한 정보를 포함하는 tokens을 병합하여 contextual tokens을 생성합니다. 그림 3에서 볼 수 있듯이 이러한 contextual tokens은 figure의 semantic similarity information을 포함하는 매우 유익한 tokens 역할을 합니다.

2.4. Efficient Tuning

Informative Visual Token Zip은 visual encoder에서 매우 유익한 tokens을 추출하고 다른 tokens은 삭제하여 LLM에 대한 token length input을 크게 줄입니다(잠재적으로 최대 10배까지). 그러나 이러한 visual tokens의 감소는 원래 모든 visual tokens에 대해 trained 된 VLM model이 갑작스러운 감소에 적응하는 데 어려움을 겪을 수 있으므로 어느 정도의 misalignment를 초래할 수 있습니다.

visual space와 LLM space 사이의 격차를 해소하기 위해, 우리는 최소한의 instruction tuning data를 사용하여 다른 components는 frozen 상태로 유지하면서 multimodal projector를 효율적으로 fine-tune하여 vision space와 language space 간의 alignment를 향상시킵니다. 특히, instruction tuning은 LLaVA-1.5 dataset의 1/10만 필요하며 LLaVA 1.5 7B의 경우 8개의 Nvidia A800에서 단 30분 만에 완료될 수 있습니다. 특히, 이 프로세스는 3090 GPUs에서도 구현될 수 있으며, 이는 resource-efficient하고 효과적입니다.

2.5. Usage of VisionZip

VisionZip은 Vision-Language Models의 image 및 video understanding뿐만 아니라 이전의 efficient VLMs이 처리할 수 없었던 multi-turn conversations에도 적용될 수 있습니다. 또한 VisionZip은 text-agnostic이기 때문에 구현이 용이하여 가속화를 위한 모든 기존 LLM algorithms과 호환됩니다. 또한 VisionZip은 vision encoders를 위한 plug-and-play 방식으로 볼 수 있으며, 이는 원래 모델의 성능을 90% 이상 유지하면서 런타임과 메모리를 3배 절약합니다. 13B VLM이 더 나은 성능을 유지하면서 7B VLM보다 더 큰 효율성을 달성할 수도 있습니다. Sec. 4.3에서 더 자세한 내용을 보여드리겠습니다.

2.1. Preliminary: VLM 연산량 분석

- 핵심: VLM 연산량은 sequence length에 크게 영향을 받음.

- 근거: Total FLOPs = T × (4nd^2 + 2n^2d + 2ndm)

- n (sequence length)은 제곱 및 곱셈 항에 모두 포함.

- VLM 특성: n = n_sys + n_img + n_question 에서 n_img (visual token 수)가 다른 항들보다 훨씬 큼 (최대 20배).

- 결론: n_img 감소는 VLM 효율성 향상에 필수적.

2.2. Redundancy Observation: Visual Token 중복성 관찰

- 문제 제기: LLaVA, MiniGemini 등에서 visual token 수가 text token 수보다 훨씬 많고, 이는 연산량 낭비로 이어짐. 모든 visual token이 정말 필요한가?

- 실험: CLIP, SigLIP으로 생성된 visual tokens의 attention 시각화 (그림 2).

- 결과:

- 소수의 tokens에만 attention 집중.

- 대부분의 tokens은 매우 낮은 attention score를 보이며, 중복됨.

- TextVQA dataset에서도 동일 현상 확인.

- 핵심: Dominant visual tokens만 중요 정보를 담고 있으며, 나머지는 중복.

2.3. Informative Visual Token Zip: VisionZip 핵심 아이디어

- 목표: Dominant visual tokens을 선별하고, 덜 중요한 tokens은 병합하여 중복성 제거.

- Dominant Token Selection:

- Vision encoder의 attention score 활용 (식 1).

- CLS token 존재 시 (CLIP): CLS token이 attend하는 tokens 선택.

- CLS token 부재 시 (SigLIP): 다른 모든 tokens으로부터 받는 평균 attention이 높은 tokens 선택.

- 결과: Dominant tokens은 대부분의 attention과 정보를 집약 (그림 3).

- Contextual Tokens Merging:

- 목적: Dominant tokens에 포함되지 않은 잠재적 중요 정보 보존.

- 방법:

- Non-dominant tokens을 target과 merge tokens으로 분할.

- Similarity metric (e.g., dot product)으로 유사한 정보를 담은 keys 식별.

- 유사한 tokens 병합하여 contextual tokens 생성.

- 결과: Contextual tokens은 semantic similarity 정보를 포함 (그림 3).

2.4. Efficient Tuning: Fine-tuning을 통한 Alignment 개선

- 문제: Token 수 감소로 인해 visual space와 LLM space 간 misalignment 발생 가능.

- 해결: Multimodal projector를 소량의 instruction data로 fine-tuning.

- LLaVA-1.5 dataset의 1/10, LLaVA 1.5 7B 기준 8개의 A800에서 30분 소요 (3090에서도 가능).

- 효과: Vision과 language space 간 alignment 향상, 성능 손실 최소화.

2.5. Usage of VisionZip: 활용 및 장점

- 다양한 task 적용: Image/video understanding, multi-turn conversations 등.

- Text-agnostic: 기존 LLM acceleration algorithms과 호환.

- Plug-and-play: Vision encoder에 쉽게 적용, 90% 이상 성능 유지하며 3배 runtime/memory 절약.

- 13B VLM이 7B VLM보다 더 효율적이고 우수한 성능 달성 가능.

결론: VisionZip은 visual tokens의 중복성을 효율적으로 제거하는 혁신적인 방법입니다. Dominant token selection과 contextual token merging을 통해 정보 손실을 최소화하면서 연산량을 크게 줄입니다. Efficient tuning은 성능을 더욱 향상시키고, text-agnostic한 특성 덕분에 다양한 VLM에 쉽게 적용 가능합니다. 이는 VLM 연구에 새로운 방향을 제시하며, 실용성 측면에서도 큰 의미를 갖습니다.