AI바라기의 인공지능

Robotics : 논문리뷰 : Zero-Shot Robotic Manipulation with Pretrained Image-Editing Diffusion Models 본문

Robotics : 논문리뷰 : Zero-Shot Robotic Manipulation with Pretrained Image-Editing Diffusion Models

AI바라기 2025. 6. 19. 21:27쉬운 설명

이 논문의 핵심 아이디어를 비유하자면, 유능한 내비게이터와 숙련된 운전자의 협력과 같습니다.

- 내비게이터 (High-level Planner): 방대한 지도 데이터와 실시간 교통 정보를 가진 diffusion model. 최종 목적지("마트에 가자")를 듣고 현재 위치를 파악한 뒤, "일단 다음 사거리에서 우회전하세요"처럼 당장 수행해야 할 **단기적이고 명확한 시각적 목표(subgoal 이미지)**를 제시합니다.

- 운전자 (Low-level Policy): 운전 자체에 매우 능숙하지만, 전체 경로를 알 필요는 없습니다. 내비게이터가 제시한 '다음 사거리'라는 가까운 목표 지점까지 정확하게 운전하는 데만 집중합니다.

이렇게 복잡한 장거리 운전을 '단기 목표 제시'와 '단기 목표 수행'의 반복으로 나누면, 운전자는 혼란 없이 매 순간 정밀한 운전에 집중할 수 있어 최종 목적지까지 더 안전하고 확실하게 도착할 수 있습니다. 이는 최종 목적지만 알려주고 알아서 가라고 하는 것보다 훨씬 효과적인 방식입니다.

용어 설명 (Glossary)

- SuSIE (SUbgoal Synthesis via Image Editing): 이 논문에서 제안하는 방법론. Pre-trained image-editing diffusion model을 사용하여 로봇이 수행할 중간 목표(visual subgoal) 이미지를 생성하고, 이를 low-level policy가 따라가도록 하는 계층적 제어 프레임워크.

- Subgoal Synthesis: 최종 목표를 달성하기 위해 텍스트나 action sequence가 아닌, 미래의 특정 시점에 도달해야 할 '이미지' 자체를 중간 목표(subgoal)로 생성하는 과정. 이 논문의 핵심 아이디어.

- InstructPix2Pix: 본 연구에서 high-level planner로 사용된 pre-trained text-guided image-editing diffusion model. 텍스트 지시어에 따라 이미지를 수정하는 데 특화되어 있음.

- Goal-Conditioned Policy: Low-level controller. 현재 상태(current image)와 목표 상태(goal image) 두 개의 이미지를 입력받아, 목표 상태에 도달하기 위한 action을 출력하는 policy. 언어(language) 입력이 필요 없어 language-agnostic 하다는 점이 중요.

- Zero-shot Generalization: 로봇이 훈련 데이터에 없었던 새로운 물체, 새로운 환경, 새로운 지시어에 대해 별도의 fine-tuning 없이 작업을 성공적으로 수행하는 능력. 이 논문의 핵심 평가 지표.

- Oracle GCBC (Goal-Conditioned Behavioral Cloning): 실험에서 사용된 매우 강력한 baseline. 로봇에게 태스크의 '완벽한 최종 목표 이미지'를 사람이 직접 제공했을 때, 이를 따라가는 goal-conditioned policy. SuSIE가 이 oracle보다 뛰어난 성능을 보인다는 점은 이 논문의 중요한 실험 결과.

Purpose of the Paper

- 기존 연구의 한계: 기존의 VLM(Vision-Language Model)을 활용한 로봇 제어 방식은 semantic한 이해(예: "어떤 물체를 집어야 하는가")는 향상시켰지만, low-level 제어의 정밀도(precision)가 부족하여 실제 물리적 상호작용(예: 물체를 정확히 잡거나 옮기는 동작)에서 실패하는 경우가 많았음.

- 새로운 접근 방식: 이 논문은 이 문제를 해결하기 위해 '계획(planning)'과 '실행(execution)'을 명확히 분리하는 hierarchical 접근법을 제안.

- High-level planner (Image-editing model)는 pre-trained된 방대한 semantic 지식을 활용해 '무엇을, 어디로'에 해당하는 시각적 중간 목표(visual subgoal)를 생성.

- Low-level controller (Goal-conditioned policy)는 복잡한 언어 이해 없이 오직 현재 이미지와 subgoal 이미지만 보고 '어떻게' 도달할지에만 집중하여 정밀한 visuo-motor 제어를 수행.

Key Contributions & Novelty

- Pre-trained Image-Editing 모델을 로봇의 High-Level Planner로 활용

- Contribution: 언어 지시어와 현재 이미지를 바탕으로 미래의 subgoal 이미지를 생성하는 SuSIE 프레임워크를 제안.

- Novelty: 기존 방식처럼 action이나 텍스트 계획을 생성하는 대신, diffusion model을 이용해 **시각적 subgoal을 직접 합성(synthesis)**하는 새로운 패러다임을 제시. 이는 인터넷 스케일의 시각-언어 지식을 로봇의 물리적 계획에 직접적으로 통합하는 독창적인 방법.

- Zero-shot Generalization과 Low-level Precision의 동시 달성

- Contribution: 복잡한 태스크를 단순하고 도달 가능한 여러 subgoal로 분해함으로써, 훈련 데이터에 없던 새로운 물체와 상황에서도 높은 성공률을 보임.

- Novelty: 거대 모델(e.g., RT-2-X)이 많은 데이터로 end-to-end 학습하는 것보다, SuSIE의 계층적 접근법이 특히 정밀한 조작이 요구되는 태스크에서 더 우수함을 입증. 이는 '계획'과 '실행'의 분리가 더 효과적일 수 있다는 중요한 증거.

- 인간 영상 데이터를 로봇 학습에 성공적으로 활용

- Contribution: 로봇 데이터(BridgeData V2)뿐만 아니라 로봇과 관련 없는 인간의 비디오 데이터(Something-Something dataset)를 subgoal 생성 모델 finetuning에 함께 사용.

- Novelty: 이를 통해 subgoal 생성 모델의 generalization 능력이 향상됨을 정량적으로 증명. 로봇 데이터만으로는 부족한 다양한 상호작용에 대한 지식을 인간 영상에서 성공적으로 이전(transfer)함.

Experimental Highlights

- CALVIN Benchmark SOTA 달성:

- 가장 어려운 zero-shot 설정 (Train on A,B,C → Test on D)에서 5개의 명령을 연속 수행하는 태스크 성공률 0.26을 기록, 기존 SOTA(0.04-0.06)를 압도적으로 능가 (Table 1).

- Real-world 실험에서의 강력한 성능:

- 새로운 물체와 배경이 등장하는 어려운 시나리오(Scene B, C)에서 RT-2-X (55B 파라미터, 1.1M+ 데이터)와 같은 거대 모델을 포함한 모든 baseline을 능가 (Table 2).

- 특히, 가볍고 미끄러워 정밀한 파지가 필요한 'bell pepper'를 다루는 Scene B에서 유일하게 일관된 성공을 보이며, low-level 제어의 정밀도를 입증.

- Oracle Policy를 능가하는 성능:

- 태스크의 완벽한 최종 목표 이미지를 제공받는 Oracle GCBC보다 SuSIE가 더 높은 성공률을 기록 (CALVIN: 0.95 vs 0.66, Real-world Scene C: 0.88 vs 0.78) (Table 3).

- 중요한 시사점: 이는 먼 최종 목표를 한 번에 주행하는 것보다, 도달 가능한 가까운 subgoal들을 순차적으로 따라가는 것이 더 효과적인 전략임을 의미.

- Ablation Study:

- Internet pretraining (InstructPix2Pix 초기화)과 human video co-training을 제거했을 때 subgoal의 질과 out-of-distribution 성능이 크게 저하됨을 보여줌 (Figure 4). 두 요소 모두 zero-shot generalization에 필수적임을 증명.

Limitations and Future Work

- Limitation 1: Planner와 Policy의 분리된 학습

- High-level planner(diffusion model)가 low-level policy의 실제 능력(capabilities)이나 한계를 인지하지 못함. 이로 인해 policy가 도달할 수 없는 subgoal을 생성할 수 있음.

- Future Work 1: Policy-Aware Subgoal Generation

- Planner가 policy의 실행 가능성을 고려하여 subgoal을 생성하도록 두 모델을 공동으로 학습하거나, policy로부터 feedback을 받는 메커니즘을 도입하여 성능을 개선할 수 있음.

- Limitation 2: Low-level Policy의 성능 한계

- 종종 subgoal 생성이 아닌, low-level policy의 goal-reaching 능력이 전체 시스템의 병목(bottleneck)이 됨.

- Future Work 2: Low-level Controller 개선

- SuSIE 프레임워크의 이점을 극대화하기 위해, 더 강건하고 정밀한 goal-conditioned policy를 개발하는 연구가 필요함.

Overall Summary

SuSIE는 pre-trained image-editing diffusion model을 high-level planner로 사용하여 시각적 subgoal을 생성하고, 이를 language-agnostic한 low-level policy가 수행하는 독창적인 hierarchical 로봇 제어 프레임워크입니다. 이 접근법은 복잡한 semantic reasoning과 정밀한 motor control을 효과적으로 분리하여, 기존 end-to-end 방식들을 압도하는 뛰어난 zero-shot generalization과 precision을 달성했습니다. 이 연구는 인터넷 스케일의 방대한 지식을 로봇의 물리적 제어에 통합하는 확장 가능하고 새로운 길을 제시했다는 점에서 큰 의의를 가집니다.

ABSTRACT

만약 일반 로봇이 진정으로 구조화되지 않은 환경에서 작동하려면, 새로운 물체와 시나리오를 인식하고 이에 대해 reason 할 수 있어야 합니다. 이러한 물체와 시나리오는 로봇 자체의 training data에 존재하지 않을 수 있습니다. 우리는 low-level 컨트롤러가 달성할 수 있는 중간 하위 목표를 제안함으로써 high-level 플래너 역할을 하는 이미지 편집 diffusion model을 활용하는 방법인 SuSIE를 제안합니다.

구체적으로, 우리는 로봇의 현재 관찰과 language 명령이 주어졌을 때 가상적인 미래의 "하위 목표" 관찰을 output하도록 인간 video와 로봇 rollout으로 구성된 video data에 대해 InstructPix2Pix를 finetune 합니다. 우리는 또한 앞서 언급한 low-level 컨트롤러 역할을 하도록 low-level goal-conditioned policy를 train 하기 위해 로봇 데이터를 사용합니다.

우리는 high-level 하위 목표 예측이 인터넷 규모의 pretraining과 visual 이해를 활용하여 low-level goal-conditioned policy를 안내할 수 있으며, 기존의 language-conditioned policies보다 훨씬 뛰어난 generalization과 정밀도를 달성한다는 것을 발견했습니다. 우리는 CALVIN 벤치마크에서 state-of-the-art 결과를 달성하고, 특권 정보에 접근하거나 훨씬 더 많은 계산 및 training data를 활용하는 강력한 baseline을 능가하며, 실제 조작 작업에서 강력한 generalization을 보여줍니다.

1 INTRODUCTION

유용한 generalist robot은 사람과 마찬가지로 이전에 한 번도 마주친 적 없는 새로운 물체와 시나리오를 인식하고 reason 할 수 있어야 합니다. 예를 들어, 사용자가 로봇에게 "저 점보 주황색 크레용을 건네줘"라고 지시하면, 이전에 한 번도 점보 주황색 크레용과 상호작용한 적이 없더라도 이를 수행할 수 있어야 합니다. 즉, 로봇은 해당 모양과 크기의 물체를 조작할 수 있는 물리적 능력뿐만 아니라, 자신의 training distribution을 벗어난 물체에 대해 reason 할 수 있는 semantic understanding을 갖추어야 합니다. 최근 몇 년간 robotic manipulation datasets이 크게 성장했지만, 한 사람의 인생 경험이 모든 종류의 물체와의 물리적 상호작용을 포함하지 않는 것처럼, 이 datasets이 생각할 수 있는 모든 물체와 설정의 사례를 포함하게 될 가능성은 낮습니다. 이러한 datasets에는 길고 원통형인 물체를 조작하는 충분한 예시가 포함되어 있지만, 로봇이 일상적인 작동 중에 마주칠 특정 물체를 grounding하는 데 필요한 광범위한 semantic knowledge는 부족합니다.

어떻게 이 semantic knowledge를 language-guided robotic control에 주입할 수 있을까요? 한 가지 접근 방식은 vision과 language에 대해 pre-trained된 models을 활용하여 robotic learning pipeline의 다양한 구성 요소를 초기화하는 것입니다. 예를 들어, 최근의 연구들은 pre-trained vision-language encoders로 robotic policies를 초기화하거나, pre-trained models을 semantic scene augmentation에 적용합니다. 이러한 방법들이 로봇 학습에 semantic knowledge를 가져오기는 하지만, 이 접근 방식들이 모든 수준에서 robotic policy execution을 개선하는 데 있어 인터넷 pretraining의 모든 잠재력을 실현하는지, 아니면 단순히 policy의 high-level visual generalization을 향상시키는 것인지는 불분명합니다.

우리는 pre-trained image-editing models을 활용하여 generalizable robotic manipulation을 가능하게 하는 접근 방식을 제안합니다. 우리는 현재 frame과 현재 작업에 대한 language description이 주어졌을 때, model이 가상의 미래 frame을 generate하도록 video data에 대해 image-editing model을 finetune 합니다. 이는 model이 로봇의 low-level dynamics의 복잡성을 정확하게 이해할 필요가 없으므로, low-level 물리적 상호작용과 정확한 embodiment가 일치하지 않는 다른 data sources(예: 인간 video)로부터의 transfer를 용이하게 할 것입니다. 테스트 시에는, 이 가상의 미래 frame에 도달하기 위해 robot data로 trained된 low-level goal-reaching policy를 사용합니다. 이 policy는 결국 올바른 actuation을 결정하기 위해 visuo-motor 관계를 추론하기만 하면 되며, 그 위의 semantics를 이해할 필요는 없습니다. 더욱이, 이러한 subgoals은 물체를 잡는 것에 해당하는 pose와 같이 중간 하위 단계에서 arm의 가능한 poses를 추론함으로써 작업을 단순화할 수 있습니다 (그림 1 참조). 사실, 우리의 실험에서 기존 접근 방식들이 작업을 해결하기에 충분한 semantic understanding을 가지고 있을 때조차도, 장애물과 물체의 부정확한 localization 때문에 실패하는 경우가 많다는 것을 관찰했습니다. 생성된 subgoals을 따르는 것은 우리 method가 그러한 시나리오에서 잘 수행되도록 합니다. 사람이 작업을 완료하기 위해 먼저 high-level plan을 구성한 다음 low-level control을 위해 근육 기억에 맡기는 것과 마찬가지로, 우리 method는 계획을 실행하기 위해 low-level controller에 맡기기 전에 먼저 통합된 semantic reasoning과 visual understanding을 갖춘 high-level planner를 실행하는 것으로 볼 수 있습니다.

우리 연구의 주요 기여는 pre-trained models로부터 semantic information을 통합하여 robotic control을 개선하기 위한 간단하고 scalable한 method인 SUbgoal Synthesis via Image Editing (SuSIE)입니다. pre-trained image-editing model은 최소한의 수정으로 사용되며, video data에 대한 finetuning만 필요합니다. low-level goal-conditioned policy는 표준적인 supervised learning으로 trained되며, 가까운 image subgoals에 도달하는 비교적 쉬운 문제를 다룹니다. 이는 일반적으로 scene의 대부분을 무시하고 단일 물체나 arm 위치에만 주의를 기울이면 됩니다. 종합적으로, 이 접근 방식은 CALVIN benchmark에서 state-of-the-art 결과를 달성하고, novel objects, novel distractors, 심지어 novel scenes을 포함하는 실제 robot control 작업을 해결합니다. 이는 privileged information을 가진 oracle baselines과, SuSIE보다 훨씬 더 많은 robot data뿐만 아니라 인터넷 규모의 vision-language data로 trained된 550억 parameter model인 RT-2-X를 포함하여, 이러한 실제 작업에서 모든 이전 접근 방식을 능가합니다.

INTRODUCTION 정리 노트 (For AI Researchers)

1. 문제 정의 (Problem Definition)

- Generalist robot이 training data에 없는 novel object 및 시나리오에 대응하기 위해서는 semantic understanding이 필수적임.

- 기존의 pre-trained vision-language model을 policy에 접목하는 방식들은 semantic knowledge를 주입하지만, 이것이 인터넷 스케일 pre-training의 잠재력을 policy execution 단계에서 완전히 활용하는지는 불분명함.

- 특히, 기존 model들은 충분한 semantic understanding을 갖추고도 장애물이나 목표물의 부정확한 localization 문제로 인해 실패하는 경우가 많음.

2. 제안 방법 (Proposed Method: SuSIE)

- 핵심 idea는 semantic reasoning을 위한 high-level planner와 visuo-motor control을 위한 low-level controller를 분리하는 것임.

- High-Level Planner:

- Pre-trained image-editing model(InstructPix2Pix)을 high-level planner로 사용함.

- 이 model을 인간 video 및 로봇 rollout을 포함한 video data로 finetuning함.

- 역할: 현재 frame(로봇 시점)과 language command를 입력받아, 가상의 미래 frame, 즉 시각적 subgoal 이미지를 generation함.

- 장점: 로봇의 low-level dynamics를 알 필요가 없어, embodiment가 다른 인간 video 같은 데이터로도 transfer learning이 용이함.

- Low-Level Controller:

- Robot data로 trained된 표준적인 goal-reaching policy.

- 역할: High-level planner가 생성한 image subgoal에 도달하도록 로봇의 actuation을 제어함.

- 장점: Semantics를 이해할 필요 없이, 현재 frame과 목표 frame 간의 visuo-motor 관계만 학습하면 되므로 문제가 단순해짐.

3. 핵심 기여 및 결과 (Key Contributions & Results)

- 분리(Decoupling)를 통한 성능 향상: High-level의 semantic reasoning과 low-level의 control을 분리하여 각 model이 더 쉬운 문제에 집중하게 함.

- 정밀도 문제 해결: Subgoal로 arm의 pose까지 포함된 구체적인 목표 이미지를 생성함으로써, 기존 방법들의 고질적인 localization 실패 문제를 해결함.

- 단순성과 확장성 (Simplicity & Scalability): Pre-trained model을 최소한의 finetuning만으로 활용하고, low-level policy는 표준적인 supervised learning으로 학습시켜 구조가 간단하고 확장 용이함.

- SOTA 달성: CALVIN benchmark에서 state-of-the-art를 달성했으며, novel object/scene이 포함된 실제 로봇 제어에서 oracle baseline 및 SuSIE보다 훨씬 더 많은 데이터로 학습된 550억 parameter의 거대 model인 RT-2-X를 능가하는 성능을 보임.

쉬운 설명 :

이 INTRODUCTION 섹션에서는 로봇이 "처음 보는 특이한 모양의 펜을 집어줘" 같은 명령을 어떻게 수행할 수 있을지에 대한 새로운 아이디어를 제시합니다.

기존 방식은 로봇이 똑똑한 두뇌 하나로 언어도 이해하고, 물건도 찾고, 팔도 정교하게 움직이는 등 모든 것을 한 번에 처리하려고 했습니다. 그러다 보니 물체의 위치를 미세하게 잘못 파악해서 실패하는 경우가 많았습니다.

이 논문이 제안하는 방식(SuSIE)은 역할을 둘로 나눕니다. 마치 사람이 어떤 일을 할 때, 머릿속으로 **'상상(계획)'**을 먼저 하고, 그 다음엔 몸의 **'근육 기억(실행)'**에 맡기는 것과 같습니다.

- 상상하는 플래너 (High-level Planner): 로봇에게 명령을 내리면, '상상'을 담당하는 model이 먼저 나섭니다. 이 model은 명령을 듣고 로봇의 현재 시점에서 "다음 단계는 이런 모습이 되어야 해"라는 미래의 장면을 사진처럼 한 장 그려줍니다. 예를 들어, '펜을 잡는 순간'의 이미지를 생성하는 것이죠. 이 model은 인터넷에 있는 수많은 동영상(사람 동영상 포함)을 보고 학습해서 무엇이든 잘 상상할 수 있습니다.

- 움직이는 실행기 (Low-level Controller): '상상'이 끝나면, '실행'을 담당하는 model이 이 사진을 이어받습니다. 이 model은 복잡한 생각은 못 하지만, 목표 사진과 현재 모습을 비교해서 로봇 팔을 어떻게 움직여야 그 사진과 똑같이 만들 수 있는지는 아주 잘 압니다. 마치 우리 몸이 공을 던질 때 복잡한 계산 없이 근육 기억으로 움직이는 것과 같습니다.

이렇게 '상상(계획)'과 '실행'의 역할을 나누었더니, 각자 자기가 잘하는 일에만 집중할 수 있게 되어 훨씬 더 어려운 임무도 정확하게 성공시킬 수 있었습니다. 심지어 훨씬 더 크고 복잡한 model보다도 좋은 성능을 보여주었습니다.

이 그림은 SuSIE method가 어떻게 작동하는지를 시각적으로 보여주는 핵심적인 예시입니다.

이미지 설명

이 그림은 로봇이 "주황색 크레용을 나무 그릇에 넣어줘" 또는 "검은색 마커를 금속 냄비에 넣어줘" 와 같은 두 가지 다른 language command를 수행하는 과정을 보여줍니다.

프로세스 흐름:

- 시작 (왼쪽 'Real' 이미지): 가장 왼쪽의 초록색 테두리 이미지가 로봇이 현재 보고 있는 실제 세상의 모습입니다.

- Generate (생성/계획 단계):

- 로봇이 언어 명령을 받으면, high-level planner(image-editing model)가 현재 실제 이미지(Real)를 바탕으로 다음 단계의 목표 모습을 상상하여 **새로운 이미지를 생성(Generate)**합니다.

- 이것이 바로 분홍색 테두리의 Generated 이미지입니다. 예를 들어, 위쪽 과정 첫 번째 Generated 이미지를 보면, 로봇 팔이 '주황색 크레용을 잡기 직전' 위치로 이동한 모습이 생성되었습니다. 이 Generated 이미지가 바로 visual subgoal입니다.

- Execute (실행 단계):

- low-level policy는 이 생성된 subgoal 이미지(Generated)를 보고, 실제 로봇 팔을 움직여 방금 생성된 이미지와 똑같은 상태를 만듭니다.

- 이 실행이 끝나면 로봇의 세상은 다음 단계의 실제 모습(다음 초록색 테두리, Real 이미지)으로 업데이트됩니다.

- 반복 (Loop):

- 이 Generate -> Execute 과정은 최종 목표가 달성될 때까지 계속 반복됩니다.

- 즉, (1) 다음 동작을 상상해서 사진 만들고 (Generate) -> (2) 그 사진을 보고 따라 하고 (Execute) -> (3) 바뀐 현실을 보고 다시 다음 동작 상상해서 사진 만들고 (Generate) -> (4) 또 따라 하는 (Execute) 방식입니다.

핵심 요약:

이 이미지는 복잡한 명령을 한 번에 해결하는 것이 아니라, "다음 목표 이미지 생성 (계획) → 목표 이미지 도달 (실행)" 이라는 짧은 주기를 반복하여 최종 목표를 달성하는 SuSIE의 영리한 workflow를 명확하게 보여줍니다. 초록색 테두리는 '현실'이고, 분홍색 테두리는 AI가 상상한 '목표'라고 생각하시면 쉽습니다.

2 RELATED WORK

Incorporating semantic information from pretrained vision-language models. Pre-trained vision-language models (VLMs)의 semantic information을 로봇 학습에 통합하는 이전 연구들은 두 가지 범주로 분류될 수 있습니다. 첫 번째 범주는 VLMs의 정보를 이용하여 robot policies에서의 visual scene understanding을 향상시키는 것을 목표로 합니다. 예를 들어, GenAug, ROSIE, DALL-E-Bot, CACTI는 text-to-image generative models을 사용하여 주어진 scene에 novel objects와 배치를 추가하는 semantic augmentations을 생성하고, 로봇이 유사한 scene에서 잘 수행할 수 있도록 augmented data로 robot policy를 train합니다. MOO는 pre-trained object detector를 사용하여 bounding boxes를 추출하고 policy를 목표 객체로 유도합니다. 다른 연구들은 action sequences를 생성하기 위해 직접 language와 이미지 기반 policies를 train하며, 일부는 VLM initializations를 사용합니다.

이러한 접근 방식들이 pre-trained models을 활용하기는 하지만, 우리의 실험에서는 VLMs를 사용한 pre-training이 반드시 low-level policy execution을 향상시키지는 않는다는 것을 발견했습니다. 즉, 학습된 policies는 종종 객체를 localize하거나 gripper를 부정확하게 움직입니다 (그림 3 참조). 반면에, 우리의 접근 방식은 low goal reaching policy의 움직임을 신중하게 조종하는 subgoals을 합성함으로써 pre-training의 이점을 low-level control에 통합하여 정밀도를 향상시킬 수 있습니다. 우리의 접근 방식은 구조화되지 않은 open-world 설정에 직접 적용될 수 있지만, 이전 연구들의 방법들을 적용하려면 객체 bounding boxes나 3D meshes와 같은 추가적인 prior information이 필요합니다. 이는 이러한 추가 정보가 제공되지 않는 시나리오에서는 그 적용 가능성을 크게 제한합니다. 예를 들어, 새로운 목표 객체에 대한 3D object meshes가 없었기 때문에 우리 실험에서는 GenAug를 적용할 수 없었습니다. generative models을 활용하는 우리의 접근 방식과 달리, 다른 연구들은 제어를 위한 vision-language pre-training을 위해 representation learning 목표를 설계하지만, 이러한 method들은 여전히 policy를 배우기 위해 target task의 제한된 양의 데이터를 활용해야 합니다. 대조적으로, 우리의 접근 방식은 어떠한 task-specific data 없이 zero-shot으로 target task를 해결합니다.

두 번째 범주의 접근 방식들은 low-level controllers에 정보를 제공하기 위해 pre-trained models의 semantic information을 통합합니다. 일반적으로, 이러한 이전 method들은 pre-trained models을 사용하여 visual 또는 textual plans을 상상하고, 이는 low-level robot control policy에 정보를 제공합니다. 이 중에서 text에 conditioned된 low-level policies를 train하는 method들은 grounding problem을 겪는데, 우리의 접근 방식은 low-level policy가 오직 이미지만 보기 때문에 이 문제를 완전히 회피합니다.

아마도 이 두 번째 범주에서 우리의 접근 방식과 가장 관련 있는 method들은 UniPi와 HiP일 것입니다. 이들은 target task를 달성하는 sequence of frames를 생성하도록 video models을 train한 다음, inverse dynamics model을 train하여 로봇 actions을 추출합니다. 우리의 접근 방식은 전체 video(rollout의 모든 frame)를 생성하려고 시도하는 것이 아니라, 명령받은 작업을 해결하기 위해 low-level policy가 달성해야 할 다음 waypoint만을 생성합니다. 이 차이는 작아 보일 수 있지만, 중요한 영향을 미칩니다. 전체 video를 modeling하는 것은 generative model에 매우 큰 부담을 주며, frame들이 엄격한 physical consistency를 따라야 합니다. 불행히도, 우리는 open-source video models이 종종 temporally inconsistent frames를 생성하여 low-level controller를 혼란스럽게 한다는 것을 발견했습니다 (부록 C 참조). 우리 method는 low-level controller가 더 긴 시간 간격에 걸쳐 작업의 물리적 측면을 처리할 수 있는 더 많은 자유를 제공하는 동시에, diffusion model이 physical plausibility를 보존하는 능력에 적합한 수준으로 안내합니다. 우리 실험에서, 우리 method가 UniPi의 open-source 재구현보다 상당히 개선되었음을 발견했습니다.

Classical model-based RL and planning with no pretraining. 우리 접근 방식의 idea는 pre-trained models을 사용하지 않고 일반적으로 language-guided control을 연구하지 않는 deep RL 문헌의 여러 method들과도 관련이 있습니다. 예를 들어, 일부 연구들은 action-conditioned dynamics models을 train하고 model 안에서 RL을 실행합니다. 우리 접근 방식도 multi-step dynamics를 model링하지만, 우리 model은 action input에 conditioned되지 않습니다. action input에 대한 의존성을 제거함으로써, 우리는 (거대한) image-editing model의 finetuning을 policy로부터 완전히 분리하여 단순성과 시간 효율성을 향상시킬 수 있습니다. APV는 videos로부터 action agnostic dynamics model을 train하지만 policy와 함께 loop에서 finetune하므로 위의 이점을 누리지 못합니다. 마지막으로, 이러한 model-based RL method들은 새로운 작업에 대한 zero-shot generalization 능력을 보여주지 못하는데, 이는 우리 method가 가진 중요한 능력입니다. 우리 접근 방식은 여러 video prediction methods와도 관련이 있지만, 더 나은 neural network architecture(즉, LSTMs와 CNNs 대신 diffusion models)를 활용합니다. 우리 method와 가장 관련이 있는 것은 hierarchical visual foresight (HVF)입니다. HVF는 MPC를 사용하여 action을 찾는 반면, 우리 접근 방식은 goal-reaching policy를 사용하여 거대한 dynamics models로 MPC를 실행하는 비용을 제거합니다.

우리 접근 방식은 pre-training 없이 single-task 설정에서 planning을 위해 generative models을 사용하는 이전 연구들과도 관련이 있습니다. Trajectory transformer (TT), decision transformer (DT), 그리고 그 확장판들은 target return이나 goal에 policy를 condition합니다. 이러한 method들의 diffusion-based variants가 우리 접근 방식처럼 diffusion models을 사용하긴 하지만, 우리의 zero-shot planning 접근 방식과 달리, policy를 배우기 위해서는 여전히 target task의 training data가 필요합니다.

2 RELATED WORK 정리 노트 (For AI Researchers)

이 섹션은 SuSIE가 기존 로봇 학습 연구들과 어떻게 차별화되는지를 세 가지 주요 카테고리로 나누어 설명합니다.

1. Pre-trained VLM 활용 방식의 차이

- 기존 연구 (Category 1 & 2):

- 접근법 A (Scene Understanding 향상): Pre-trained VLM을 semantic scene augmentation(GenAug 등)이나 policy의 vision encoder 초기화에 사용.

- 접근법 B (Planning): Textual 혹은 Visual Plan을 생성하여 low-level policy에 전달 (UniPi, HiP 등).

- SuSIE와의 핵심 차이점:

- 정밀도(Precision) 문제 해결: 기존 방식들은 semantic understanding은 높여도, gripper의 부정확한 localization 같은 low-level execution 문제를 해결하지 못함. SuSIE는 명시적인 visual subgoal을 제공하여 low-level policy를 정밀하게 가이드함.

- Grounding 문제 해결: Textual plan 기반 방식들은 language grounding 문제가 있지만, SuSIE의 low-level policy는 이미지만 보기 때문에 이 문제가 원천적으로 없음.

- Waypoint vs. Full Video: 가장 유사한 UniPi/HiP는 물리적 일관성(physical consistency) 유지가 매우 어려운 '전체 video' 생성을 시도함. 이 때문에 종종 temporally inconsistent한 frame이 생성되어 controller에 혼란을 줌. 반면 SuSIE는 달성 가능한 '다음 waypoint' 이미지만 생성하여 generative model의 부담을 줄이고 안정성을 높임.

- Prior Information 불필요: 기존의 많은 방법들은 3D mesh나 bounding box 같은 사전 정보가 필요하지만, SuSIE는 추가 정보 없이 zero-shot으로 동작함.

2. 고전적인 Model-Based RL과의 차이

- 기존 연구: Action-conditioned dynamics model을 학습하고 그 안에서 planning이나 RL을 수행. Pre-training을 사용하지 않음.

- SuSIE와의 핵심 차이점:

- Action-free Dynamics: SuSIE의 high-level model은 action을 입력으로 받지 않음 (action-agnostic). 이로 인해 거대한 image-editing model의 finetuning과 policy 학습을 완전히 분리(decouple)하여 단순성과 효율성을 높임.

- Zero-shot Generalization: 고전적인 RL 방법들은 학습된 특정 태스크 외에 새로운 태스크에 대한 zero-shot generalization 능력이 없지만, SuSIE는 이 능력을 보유함.

- MPC 대 Goal-reaching Policy: HVF 같은 방법은 비용이 큰 MPC를 사용하지만, SuSIE는 더 효율적인 goal-reaching policy를 사용함.

3. Transformer-based Planner (DT, TT)와의 차이

- 기존 연구: Goal이나 return에 conditioned된 transformer policy를 학습. Diffusion model을 사용하는 변형도 존재.

- SuSIE와의 핵심 차이점:

- Zero-shot vs. In-domain Data: DT, TT 계열은 policy 학습을 위해 목표 task에 대한 training data가 반드시 필요함. SuSIE는 target task에 대한 데이터 없이 zero-shot planning이 가능함.

쉬운 설명 :

이 부분은 "우리(SuSIE)의 아이디어가 기존에 있던 다른 방법들과 비교해서 왜 더 새롭고 똑똑한가?"를 설명하는 부분입니다. 다른 접근법들을 크게 세 그룹으로 나누어 비교합니다.

1. 다른 AI 비서 로봇들과의 차이점

- 다른 로봇들:

- A타입 (공부벌레 로봇): "세상의 모든 물건과 상황을 미리 다 공부시켜서 똑똑하게 만들자!" 라는 방식입니다. 하지만 이 로봇은 막상 일을 시키면 물건을 정확하게 집지 못하고 엉뚱한 곳을 짚는 등 '손재주'가 부족한 모습을 보였습니다.

- B타입 (장황한 계획가 로봇): "일의 전체 과정을 영화 한 편처럼 만들어서 보여줄게" 라고 계획을 세웁니다. 하지만 이 '영화'는 물리적으로 이상하거나(예: 팔이 벽을 뚫고 감) 뒤죽박죽이어서, 실행을 담당하는 부분이 오히려 혼란에 빠졌습니다.

- SuSIE 로봇:

- "전체 영화는 필요 없어. 그냥 다음 스텝에 해당하는 스냅샷 한 장만 딱 보여줘." 라고 말합니다. SuSIE는 물리적으로 가능한, 명확한 다음 목표 사진(subgoal) 하나만 생성합니다. 실행 담당은 그 사진만 보고 따라 하면 되니 훨씬 쉽고 정확하게 일을 처리할 수 있습니다.

2. 전통적인 로봇 공학과의 차이점

- 전통 로봇: "오른쪽으로 5도 틀고, 앞으로 3cm 이동해..." 와 같이 로봇의 모든 행동 하나하나를 지시하는 action 기반으로 계획을 세웁니다. 매우 복잡하고 비효율적입니다.

- SuSIE 로봇: "네비게이션처럼 다음 목적지만 알려줄게. 운전(action)은 네가 알아서 해." 라는 방식입니다. SuSIE는 '어떻게 움직일지'가 아니라 '어디로 가야 할지'에 대한 목표 이미지만 제공합니다. 덕분에 계획과 실행이 분리되어 훨씬 단순하고 효율적입니다. 또한, 이 덕분에 처음 보는 길(새로운 임무)도 잘 찾아가는 zero-shot 능력을 갖게 됩니다.

3. 최신 Transformer 로봇들과의 차이점

- 최신 로봇들: "그 일을 어떻게 하는지 알려면, 그 일에 대한 학습 데이터가 필요해" 라고 말합니다. 즉, '컵 옮기기'를 시키려면 '컵 옮기기' 데이터로 미리 학습해야 합니다.

- SuSIE 로봇: "나는 그 일을 한 번도 안 해봤어도 괜찮아. 그냥 상상해서 할 수 있어." 라고 말합니다. SuSIE는 특정 임무에 대한 데이터 없이도(zero-shot), pre-trained된 능력으로 subgoal을 상상하여 계획을 세울 수 있습니다.

3 PRELIMINARIES AND PROBLEM STATEMENT

우리는 language-conditioned robotic control의 문제 설정을 고려합니다. 구체적으로, 우리는 로봇이 새로운 language command로 기술된 task를 완수하기를 원합니다. 우리는 data 소스를 3가지 범주로 나눕니다: 로봇 actions을 포함하지 않는 language-labeled video clips ; language labels과 로봇 actions을 모두 포함하는 language-labeled robot data ; 그리고 오직 actions만 포함하는(play data 등) unlabeled robot data 입니다.

공식적으로, 우리는 로 정의합니다. 여기서 각 trajectory 은 이 데이터를 수집하는 동안 실행된 images(또는 states) 와 actions 의 sequence로 구성됩니다. 즉, Markov decision process의 표준적인 가정을 따라 입니다. 은 trajectory에서 완수된 task를 설명하는 natural language command입니다. 과 도 유사하게 구성되지만, 각각 actions 또는 language annotations 이 빠져 있습니다. 테스트 시점에는, 새로운 scene 와 task에 대한 새로운 natural language description 가 주어졌을 때, 우리는 에서 시작하여 이 task를 완수하는 성공률(success rate) 측면에서 method를 평가합니다.

4 SUSIE: SUBGOAL SYNTHESIS VIA IMAGE EDITING

우리의 목표는 인터넷의 semantic information을 활용하여 novel한 환경, scene, 객체가 존재하는 상황에서 language-guided robot control을 개선하는 것입니다. 범용 인터넷 data로 trained된 models이 low-level actions 선택에 대한 가이드를 제공하지 않을 때 우리는 어떻게 이를 수행할 수 있을까요? 우리의 핵심 통찰은 robot control 문제를 두 단계로 decouple하면 pre-trained model의 능력을 효과적으로 활용할 수 있다는 것입니다: (I) task 성공을 위해 달성해야 할 subgoals을 생성하는 단계, 그리고 (II) 이 생성된 subgoals에 도달하기 위한 low-level control policies를 학습하는 단계. 우리 method는 (I) 단계에서 text-guided image-editing model을 에 finetuning함으로써 인터넷 data의 text-image pretraining과 non-robot video data로부터 semantic information을 통합합니다. (II) 단계는 로봇 data 로 trained된 goal-conditioned policy를 통해 수행됩니다. 아래에서 각 단계를 설명하고 결과적인 algorithm을 요약합니다.

4.1 PHASE (I): SYNTHESIZING SUBGOALS FROM IMAGE-EDITING MODELS

우리 method의 주요 구성 요소는 natural language로 명시된 목표 task가 주어졌을 때, low-level controller를 task를 진전시키는 state로 안내할 수 있는 generative model입니다. 이를 달성하는 한 가지 방법은 즉각적인 다음 subgoal image를 생성하도록 generative model을 train하는 것입니다. 그런 다음 우리는 이 generative model을 적절한 pre-trained initialization으로 초기화하고, 이어서 로봇 rollouts뿐만 아니라 인터넷의 다른 video들로 구성된 multi-task의 다양한 video data에 finetuning함으로써 인터넷의 semantic information을 우리 algorithm에 통합할 수 있습니다.

이 model을 위한 좋은 pre-trained initialization은 무엇일까요? 우리의 직관은, task를 완수하는 것이 language command에 의해 규정된 constraints 하에서 로봇 작업 공간의 image의 pixels을 "편집"하는 것과 같으므로, 좋은 pre-trained initialization은 text-guided image-editing model에 의해 제공될 수 있다는 것입니다. 우리는 다른 image-editing models도 사용될 수 있지만, Instruct Pix2Pix로 우리 접근 방식을 구체화합니다. 공식적으로 이 model은 로 주어집니다. 그런 다음, language-labeled video clips와 로봇 trajectories의 dataset 를 사용하여, 초기 image 와 language label 이 주어졌을 때 유효한 subgoals 을 생성하도록 를 finetune합니다. 공식적으로 training objective는 다음과 같습니다. 여기서 는 model이 어떤 subgoals을 생성하도록 train될지 제어하는 우리가 선택하는 분포입니다. 우리는 diffusion model이 현재 state로부터 일관된 거리만큼 미래에 있는 subgoals을 생성하기를 원합니다 — low-level policy가 도달할 수 있을 만큼 충분히 가깝지만, task에 대해 상당한 진전을 이룰 만큼 충분히 멀리 있는 subgoals 말입니다. 따라서, 우리는 dataset에 의존하는 hyperparameters 과 를 선택하고, 를 미래의 과 steps 사이에서 균등하게 subgoals을 선택하도록 설정합니다. 즉, 입니다.

4.2 PHASE (II): REACHING GENERATED SUBGOALS WITH GOAL-CONDITIONED POLICIES

finetuned된 image-editing model을 활용하여 로봇을 제어하기 위해, 우리는 추가적으로 적절한 로봇 actions을 선택하도록 low-level controller를 train해야 합니다. 이 섹션에서는 우리 low-level controller의 설계를 제시하고, 이어서 test-time control procedure에 대한 전체 설명을 제공합니다. SuSIE의 image-editing model은 natural language task descriptions에 conditioned된 미래 subgoals의 images를 생성하므로, 우리 low-level controller는 단순히 language-agnostic goal-reaching policy가 될 수 있습니다.

Training a goal-reaching policy. 우리의 goal-reaching policy는 로 parameterized되며, 여기서 는 policy가 에서 행동함으로써 도달하고자 하는 미래 frame입니다. 테스트 시, (I) 단계의 image-editing model이 어떤 state에서든 steps 내의 subgoals을 생성하도록 trained되기 때문에, 우리는 low-level policy가 현재 state의 steps 내에 있는 가까운 states에 도달하는 데 능숙해야 합니다. 이 policy를 train하기 위해, 우리는 로봇 data 에 대해 goal-conditioned behavioral cloning (GCBC)을 실행합니다. 공식적으로 training objective는 다음과 같습니다. 여기서 는 약간의 여유를 제공하는 또 다른 hyperparameter입니다. 왜냐하면 image-editing model은 완벽하지 않아서, 특히 처음 보는 task에 대해 항상 steps 미만으로 도달 가능한 subgoals을 생성하지 않을 수 있기 때문입니다.

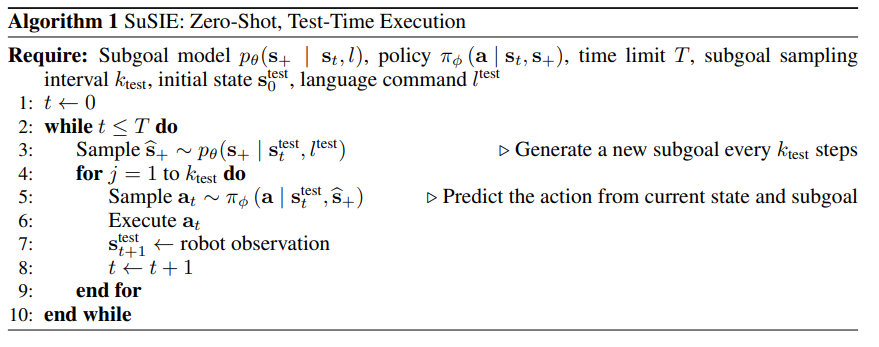

Test-time control with and . goal-reaching policy 와 subgoal generation model 가 모두 trained되면, 우리는 사용자가 지정한 natural language commands에 기반하여 새로운 manipulation tasks를 해결하기 위해 이 둘을 함께 활용합니다. 새로운 scene 와 language command 가 주어지면, SuSIE는 subgoals을 반복적으로 생성하고 low-level policy에 이 subgoals에 도달하도록 명령함으로써 task를 해결하려고 시도합니다. 시작 시, 우리는 첫 번째 subgoal 를 sample합니다. subgoal이 생성되면, 우리는 에 conditioned된 goal-reaching policy 를 timesteps 동안 roll out합니다. 여기서 는 test-time hyperparameter입니다. timesteps 후에, 우리는 subgoal generation model로부터 다시 sampling하여 subgoal을 갱신하고 이 과정을 반복합니다. 실제로는 computational efficiency를 위해, 우리는 를 로봇 data와 함께 사용된 해당 와 유사하게 설정했으며, 이것이 좋은 성능을 얻기에 충분하다는 것을 발견했습니다. 그러나 무제한의 computational budget이 주어진다면, 일반적인 통념은 subgoals을 더 자주 재생성하는 것이 더 robust한 제어로 이어질 것이라고 제안할 것입니다. test-time control을 위한 Pseudocode는 Algorithm 1에 제공됩니다.

4.3 IMPLEMENTATION DETAILS

(I) 단계에서, 우리는 InstructPix2Pix model의 pre-trained initialization을 활용합니다. 우리는 diffusion models training을 위한 표준적인 variational lower bound objective를 사용하여 Equation 1을 구현합니다. 우리 diffusion model과 policy는 크기의 images에서 작동합니다. 이 model이 입력 image와 language command에 주의를 기울이도록 하기 위해, 우리는 InstructPix2Pix를 따라 language와 image 모두에 classifier-free guidance를 별도로 적용합니다. (II) 단계에서 robust한 goal-reaching policy를 얻기 위해, 우리는 4개 actions의 chunks를 예측하고 test time에 이러한 predictions에 대해 temporal averaging을 수행하는 diffusion policy를 사용합니다. training hyperparameters와 architecture에 대한 더 자세한 내용은 Appendix A.1에 제공됩니다.

4 SuSIE 정리 노트 (For AI Researchers)

이 섹션은 SuSIE method의 핵심 architecture와 algorithm을 설명합니다.

1. 핵심 아이디어: 제어 문제의 분리 (Decoupling)

- 로봇 제어 문제를 두 가지의 더 간단한 하위 문제로 분리합니다.

- Phase I: Subgoal 생성: Language command를 이해하고 task를 진전시키는 중간 목표(visual subgoal) 이미지를 생성합니다. 높은 수준의 semantic reasoning을 담당합니다.

- Phase II: Subgoal 도달: 생성된 subgoal 이미지에 도달하기 위한 low-level 모터 제어를 수행합니다. Semantics 없이 시각-운동 관계(visuo-motor)에만 집중합니다.

- 이 분리 구조 덕분에, (I) 단계에서는 non-robot data(인간 비디오 등)를 포함한 대규모 데이터셋으로 pre-trained된 model의 semantic 능력을 활용하고, (II) 단계에서는 로봇 고유의 dynamics에만 집중할 수 있습니다.

2. Phase I: Image-Editing Model을 이용한 Subgoal 합성

- Model: Pre-trained text-guided image-editing model인 InstructPix2Pix를 subgoal 생성기 로 사용합니다.

- 직관: 로봇 task는 language 제약 하에 현재 scene을 '편집'하는 과정과 유사합니다.

- 학습:

- Objective (Eq. 1): Diffusion model 는 현재 state 와 language 이 주어졌을 때, 미래의 state 를 예측하도록 학습됩니다.

- Data: 로봇 데이터()와 일반 비디오 데이터()를 모두 사용하여 finetuning 합니다.

- Key Sampling Strategy: 미래 state 는 단순히 다음 frame이 아니라, 현재로부터 에서 steps 사이의 미래 frame에서 균등하게 sampling됩니다. 이는 subgoal이 너무 가깝지도(의미가 없음), 너무 멀지도(도달 불가능) 않게 하여 유의미한 진전을 만들도록 합니다.

3. Phase II: Goal-Conditioned Policy를 이용한 Subgoal 도달

- Model: Language-agnostic goal-reaching policy 를 사용합니다. 이 policy는 language를 이해할 필요 없이, 현재 state 를 목표 state 로 만들기 위한 action 를 출력합니다.

- 학습:

- Objective (Eq. 2): 로봇 데이터()를 사용하여 Goal-Conditioned Behavioral Cloning (GCBC)으로 학습합니다.

- 구현: Action 예측의 안정성을 위해 chunks of 4 actions을 예측하고 temporal averaging을 수행하는 diffusion policy를 사용합니다.

4. Test-Time Execution (Algorithm 1)

- Loop 구조:

- Subgoal 생성 (Generate): 현재 state 와 command 를 이용해 로부터 subgoal 를 sampling 합니다.

- Policy 실행 (Execute): 생성된 subgoal 을 목표로, policy 를 timesteps 동안 실행하여 로봇을 움직입니다.

- 반복: steps가 지나면, 업데이트된 현재 state로부터 새로운 subgoal을 생성하며 1-2단계를 반복합니다.

쉬운 설명 :

이 부분은 SuSIE 로봇이 실제로 어떻게 일을 처리하는지에 대한 '설계도'와 '작동 방식'을 설명합니다. SuSIE의 핵심 전략은 똑똑한 '설계자'와 숙련된 '현장 작업자'로 역할을 나누는 것입니다.

1단계: 똑똑한 '설계자'가 다음 할 일을 스케치하기 (Phase I)

- 설계자: InstructPix2Pix라는, "말로 설명하면 사진을 편집해주는 AI"를 데려와 로봇의 설계자로 씁니다. 이 설계자는 언어를 매우 잘 이해하고, 심지어 로봇 영상뿐만 아니라 사람이 나오는 일반 동영상까지 학습해서 세상이 어떻게 돌아가는지에 대한 semantic 지식이 풍부합니다.

- 스케치 작업: 로봇에게 "컵을 선반 위에 올려"라고 명령하면, 이 설계자는 현재 로봇이 보는 풍경을 사진으로 찍고, 명령을 들은 뒤, "다음 목표는 이 모습이야" 라는 스케치(미래 사진, 즉 subgoal)를 한 장 그려줍니다. 예를 들어, '로봇 손이 컵 바로 위에 가 있는' 사진을 그려주는 식이죠. 너무 먼 미래가 아닌, 딱 다음 단계에 해당하는 적절한 미래를 그려주는 것이 핵심입니다.

2단계: 숙련된 '현장 작업자'가 스케치대로 작업하기 (Phase II)

- 현장 작업자: 이 작업자는 언어는 모르지만, 두 개의 사진(현재 모습, 목표 스케치)을 비교해서 로봇 팔을 어떻게 움직여야 현재 모습을 목표 스케치처럼 만들 수 있는지 아주 잘 아는 전문가입니다.

- 작업 수행: 설계자가 그려준 subgoal 스케치를 보고, 그 모습과 똑같아질 때까지 로봇을 움직입니다.

실제 작업 과정 (Test-Time)

로봇은 이 둘의 협업을 반복하며 최종 목표를 달성합니다. (Algorithm 1)

- 설계자가 첫 번째 스케치(예: 컵 위로 손 이동)를 그립니다.

- 작업자는 그 스케치를 보고 몇 초간(k_test 동안) 열심히 팔을 움직여 스케치와 현실을 맞춥니다.

- 몇 초 후, 설계자는 바뀐 현실을 보고 다시 다음 스케치(예: 컵을 집어 든 모습)를 그립니다.

- 작업자는 또 새로운 스케치를 보고 열심히 따라 합니다.

이 '스케치 그리고, 따라 하기' 과정을 반복하면, 아무리 복잡한 임무라도 단계별로 착착 해결해 나갈 수 있게 됩니다.

주인장 이해

1. InstructPix2Pix에 text를 입력받아서 미래 frame인 subgoal 생성. (디퓨전을 통한 네이티브 이미지에 가까움)

(암튼 준비된 데이터로 subgoal을 잘 만들었는지 학습 - 픽셀 단위 loss)

2. policy는 language를 이해할 필요가 없음. 걍 목표 frame만 맞추면 됨. action을 k_test번 만큼 수행.

(레이블이 있어서 그걸 잘 수행했는지에 대해서 loss를 줌.)

3. 1 2 를 반복하면서 최종 goal에 도달할때까지 반복

InstructPix2Pix는 현재 상태에서 subgoal을 잘 만들도록 학습이 되고

policy는 매순간 최적의 선택을 하도록 학습이 됨,

비판할점

policy가 잘못 학습되었다면 k_test번 수행 하는동안 subgoal에서 더 멀어질 단점이 있음.

최적의 state에 도달했는데 끝난줄모르고 또 subgoal을 만들어서 멀어질 위험이 있음