AI바라기의 인공지능

VLM : 논문리뷰 : VIDEOREASONBENCH: Can MLLMs Perform Vision-Centric Complex Video Reasoning? 본문

VLM : 논문리뷰 : VIDEOREASONBENCH: Can MLLMs Perform Vision-Centric Complex Video Reasoning?

AI바라기 2025. 6. 4. 18:08VR VIDEOREASONBENCH: MLLM의 Vision-Centric Complex Video Reasoning 능력 평가

용어 설명 (Glossary)

- VIDEOREASONBENCH: 본 논문에서 제안하는 vision-centric complex video reasoning 능력을 평가하기 위한 새로운 benchmark.

- Vision-centric complex video reasoning: 단순한 객체 인식이나 활동 인식을 넘어, 영상 내 시각적 단서에 깊이 의존하여 여러 단계의 추론을 거쳐야 하는 복잡한 video 이해 작업.

- Latent state: Video 내에서 직접적으로 항상 관찰되지는 않지만, 일련의 operation을 통해 변화하는 숨겨진 상태 (예: 가려진 타일의 배열, 컵 속 동전 유무).

- State transitions: Video 내에서 수행되는 operation(행동)에 의해 latent state가 변화하는 과정. {St, ot, St+1} (현재 상태, 행동, 다음 상태)로 표현.

- Thinking budget / Test-time scaling: Inference 시 모델이 더 많은 계산 단계(token)를 사용하여 Chain-of-Thought (CoT) reasoning을 수행하도록 허용하는 것.

- Recall Order: 관찰된 시각적 operation의 순서를 정확히 기억하는 능력.

- Recall Count: 특정 operation이 발생한 횟수를 세는 능력.

- Infer State: 관찰된 operation들을 바탕으로 특정 시점의 latent state를 추론하는 능력.

- Compare State: 서로 다른 두 시점의 latent state를 비교하는 능력.

- Predict State: 추론된 현재 상태에서 추가적인 operation이 주어졌을 때 미래의 latent state를 예측하는 능력.

- Predict Operation: 현재 상태에서 목표 latent state에 도달하기 위해 필요한 operation 순서를 예측하는 능력.

- Number, Circle, Cup, File, Card, Chip: VIDEOREASONBENCH에서 사용되는 6가지 video demonstration 유형으로, 각각 다른 종류의 latent state와 operation을 가짐.

Purpose of the Paper

- 기존 video benchmark들은 Chain-of-Thought (CoT) reasoning의 이점을 충분히 보여주지 못하며, 종종 시각 정보보다는 외부 지식에 의존하는 경향이 있었습니다. 또한, reasoning의 깊이가 부족하여 MLLM의 실제 복잡한 video 이해 능력을 평가하기 어려웠습니다.

- 이 논문은 이러한 한계를 극복하고, MLLM이 진정한 **vision-centric complex video reasoning**을 수행할 수 있는지 평가하기 위해 **VIDEOREASONBENCH**를 제안합니다. 이 benchmark는 video 내 미세한 시각적 operation들의 연속적인 관찰과 latent state에 대한 단계별 추론을 요구하여, 모델이 시각 정보에 깊이 의존하고 복잡한 reasoning chain을 형성하도록 유도합니다.

Key Contributions & Novelty

- Contribution 1: VIDEOREASONBENCH라는 새로운 benchmark 제안.

- Novelty: Video 내 미세한 (fine-grained) operation들을 순서대로 정확히 인지하고, 부분적으로만 보이는 latent state를 추론하며, 이를 바탕으로 예측까지 수행해야 하는 다단계 reasoning 과제를 제시. 3가지 reasoning level (recall, infer, predict)과 각 level별 2개의 세부 skill, 총 6개의 skill을 평가.

- Contribution 2: 18개의 SOTA MLLM에 대한 포괄적인 평가 수행.

- Novelty/Finding: 대부분의 SOTA MLLM (GPT-4o 포함, 6.9% 정확도)이 VIDEOREASONBENCH에서 매우 낮은 성능을 보임을 발견. 반면, thinking-enhanced Gemini-2.5-Pro는 56.0%로 월등히 높은 성능을 보였으나, 여전히 human baseline (73.8%)에는 미치지 못함.

- Contribution 3: VIDEOREASONBENCH에서 extended thinking budget (CoT)의 결정적인 역할을 입증.

- Novelty/Finding: 기존 benchmark에서는 thinking budget 증가에 따른 성능 향상이 미미(<2.5%)했던 반면, VIDEOREASONBENCH에서는 Gemini-2.5-Flash 모델 기준 약 9%의 상당한 성능 향상을 보임. 이는 복잡한 video reasoning에 CoT가 필수적임을 시사.

- Contribution 4: VIDEOREASONBENCH가 시각 정보에 매우 강하게 의존함을 정량적으로 증명.

- Novelty/Finding: Video frame의 50%를 제거했을 때 Gemini-2.5-Flash의 성능이 55.5% 감소하고, 단일 frame만 사용 시 98.2% 감소. 이는 다른 benchmark들에 비해 훨씬 큰 폭의 성능 하락으로, VIDEOREASONBENCH가 시각적 단서에 대한 깊은 이해를 요구함을 보여줌.

Experimental Highlights

- Dataset: VIDEOREASONBENCH (240개 videos, 1,440개 questions, 6개 video 유형, 6개 reasoning skills).

- Metrics: 3개 level (Recall, Infer, Predict) 및 6개 세부 skill에 대한 정확도.

- Key Results:

- 대부분의 MLLM 정확도 < 10% (예: GPT-4o: 6.9%).

- Thinking-enhanced Gemini-2.5-Pro: 56.0% (이 benchmark에서 SOTA).

- Human baseline: 73.8%.

- Thinking budget 효과 (Gemini-2.5-Flash): Thinking 미적용 시 18.8% → Thinking 적용 시 27.4% (약 9%p 향상).

- Vision reliance 효과 (Gemini-2.5-Flash):

- Full Video: 27.4%

- Video 50% cut: 12.2% (↓55.5%)

- Single frame: 0.5% (↓98.2%)

- Text-only: 1.0% (↓96.4%)

- 이 결과는 VIDEOREASONBENCH가 시각적 정보에 극도로 의존함을 보여주는 핵심 발견임.

- Reasoning 난이도: Level 1 (Recall) → Level 2 (Infer) → Level 3 (Predict) 순으로 MLLM과 human 모두 성능이 일관되게 하락, 의도된 benchmark 설계와 부합.

- State reveal timing 효과: Latent state가 video 끝에 공개될 때 (역방향 추론 필요) 모델 성능이 더 낮게 나타남.

Limitations and Future Work

- Limitations:

- 본 논문은 MLLM의 vision-centric complex video reasoning 능력을 평가하는 benchmark를 제안하지만, 이러한 능력을 향상시키기 위한 구체적인 방법론은 제시하지 않음.

- Future Work:

- VIDEOREASONBENCH에서 MLLM 성능을 개선하기 위한 새로운 모델 architecture, training strategy, 또는 reasoning prompting 기법 연구를 촉진.

- Benchmark의 난이도를 유연하게 조절(operation 수, state 크기 등)하여 향후 모델 발전에 따른 지속적인 평가 가능성 제시.

Overall Summary

이 논문은 MLLM의 복잡하고 시각 중심적인 video reasoning 능력을 평가하기 위한 새로운 benchmark인 VIDEOREASONBENCH를 제안합니다. 실험 결과, GPT-4o를 포함한 대부분의 SOTA MLLM이 이러한 작업에 매우 취약함을 보였으며, thinking-enhanced Gemini-2.5-Pro만이 상대적으로 우수한 성능을 달성했습니다. 또한, VIDEOREASONBENCH는 extended CoT reasoning과 video의 시각적 내용에 대한 깊은 의존성이 필수적임을 강조합니다. 이 연구는 MLLM이 더 깊이 있는 video 이해 능력을 갖추도록 연구 방향을 제시하는 도전적인 testbed를 제공한다는 점에서 의의가 있습니다.

쉬운 설명 (Easy Explanation)

이 논문은 AI가 마치 사람이 복잡한 마술 트릭이나 규칙이 가려진 퍼즐 게임(예: 컵 여러 개 중 동전이 어디 있는지 맞추기, 가려진 타일 옮기기)을 보고 이해하는 것처럼 video를 이해할 수 있는지 시험하는 새로운 시험지(VIDEOREASONBENCH)를 만들었습니다. 이 시험지에서는 AI에게 "어떤 순서로 일이 일어났어?", "지금 가려진 부분은 어떻게 되어 있을까?", "다음에 이런 행동을 하면 결과는 뭘까?" 같은 어려운 질문을 합니다. 실험 결과, 현재 대부분의 AI는 이런 문제를 잘 풀지 못했고, "더 깊이 생각하고"(더 많은 계산 단계를 사용하고) video 화면을 아주 꼼꼼하게 봐야만 겨우 정답에 가까워졌습니다. 이 시험지는 AI가 video를 정말 제대로 이해하도록 만드는 데 도움을 줄 것입니다.

Abstract

최근 연구들은 긴 chain-of-thought (CoT) reasoning이 복잡한 작업에서 **large language models (LLMs)**의 성능을 크게 향상시킬 수 있음을 보여주었습니다. 그러나 이러한 이점은 아직 video understanding 분야에서는 입증되지 않았는데, 이는 대부분의 기존 benchmarks가 확장된 CoT chains의 장점을 보여주는 데 필요한 reasoning depth가 부족하기 때문입니다. 최근의 노력들이 video reasoning을 목표로 하는 benchmarks를 제안했지만, 작업들은 종종 knowledge-driven이며 visual content에 크게 의존하지 않습니다. 이러한 격차를 해소하기 위해, 저희는 vision-centric complex video reasoning을 평가하기 위해 설계된 benchmark인 VIDEOREASONBENCH를 소개합니다. Visual 풍부함과 높은 reasoning 복잡성을 보장하기 위해, VIDEOREASONBENCH의 각 비디오는 비디오의 일부에서만 보이는 latent state에 대한 fine-grained operations의 sequence를 묘사합니다. Questions는 세 가지 점증하는 수준의 video reasoning skills을 평가합니다: 관찰된 visual information을 recalling 하는 것, latent states의 내용을 inferring 하는 것, 그리고 비디오를 넘어서는 정보를 predicting 하는 것입니다. 이러한 task setting 하에서, models는 비디오 내의 여러 operations을 정확하게 recalling 하고, 이러한 questions에 대한 정확한 final answers을 얻기 위해 단계별 reasoning을 수행해야 합니다. VIDEOREASONBENCH를 사용하여, 저희는 18개의 **state-of-the-art multimodal LLMs (MLLMs)**를 종합적으로 평가했으며, 대부분이 complex video reasoning에서 저조한 성능을 보인다는 것을 발견했습니다—예를 들어, GPT-4o는 단지 의 accuracy를 달성한 반면, thinking-enhanced Gemini-2.5-Pro는 의 accuracy로 다른 models들을 훨씬 능가했습니다. 저희의 “test-time scaling”에 대한 조사는 또한 확장된 thinking budget이 기존 video benchmarks에서는 거의 또는 최소한의 이점만을 제공하는 반면, VIDEOREASONBENCH에서의 성능 향상에는 필수적이라는 것을 보여줍니다.

1 Introduction

최근 긴 chain-of-thought (CoT) reasoning의 발전은 **large language models (LLMs)**의 문제 해결 능력을 현저하게 향상시켰습니다. 확장된 CoT reasoning chains으로 test-time compute를 확장함으로써, mathematics, coding, 그리고 scientific reasoning과 같은 복잡한 tasks에서 상당한 performance 향상이 관찰되었습니다. 그러나 긴 CoT reasoning의 이점은 video understanding 분야에서 완전히 입증되지 않았습니다. 이러한 격차는 주로 기존 benchmarks의 한계 때문인데, 이들은 종종 확장된 CoT chains의 장점을 보여주는 데 필요한 reasoning depth가 부족합니다. Figure 1에서 볼 수 있듯이, 고급 **multimodal LLM (MLLM)**인 Gemini-2.5-Flash는 thinking mode를 활성화하지 않고 단 몇 개의 response tokens만을 사용하여 두 개의 인기 있는 benchmarks인 Video-MME와 TempCompass의 questions에 정확하게 답할 수 있습니다.

이러한 격차를 해소하기 위해, 최근 video understanding에서 CoT reasoning을 더 잘 강조하기 위한 여러 benchmarks가 제안되었습니다. Video-MMMU와 MMVU는 video understanding을 domain-specific knowledge와 통합하여 reasoning의 필요성을 도입합니다. 그러나 요구되는 reasoning process는 주로 knowledge-driven이며, visual content에 대한 강한 의존성이 부족합니다. 두 개의 동시 연구인 VCR-Bench와 MINERVA는 final answer 외에도 video reasoning process의 정확성을 평가합니다. 그럼에도 불구하고, 이러한 benchmarks의 videos와 questions는 종종 이전 benchmarks의 그것들과 유사하며, 더 깊은 video reasoning을 요구하는 데에는 미치지 못합니다.

이러한 한계에 동기를 부여받아, 본 연구는 MLLMs가 vision-centric, complex video reasoning을 수행하는 능력을 평가하기 위해 VIDEOREASONBENCH를 소개합니다. 저희는 세 가지 levels의 video reasoning을 정의하며, 각 level은 점진적으로 더 정교한 reasoning을 요구합니다: 첫 번째 level은 video에서 sequential visual observations를 정확하게 recall하는 것입니다. 두 번째 level은 video에서 직접 관찰할 수 없는 latent information을 infer하는 것입니다. 세 번째 level은 video를 넘어서 새로운 정보를 predict하는 것입니다. 예를 들어, Figure 1에서 볼 수 있듯이, VIDEOREASONBENCH의 한 video는 "sliding number puzzle"을 보여주는데, 여기서 번호가 매겨진 tiles은 처음에는 보이지만 sliding movements가 발생함에 따라 masked 됩니다. question에 정확하게 답하기 위해, model은 먼저 초기 tile arrangement와 모든 후속 movements를 recall하고 (Level 1), 그런 다음 tiles의 final arrangement를 infer하고 (Level 2), 마지막으로 이 추론된 정보를 적용하여 미래의 tile positions를 predict해야 합니다 (Level 3).

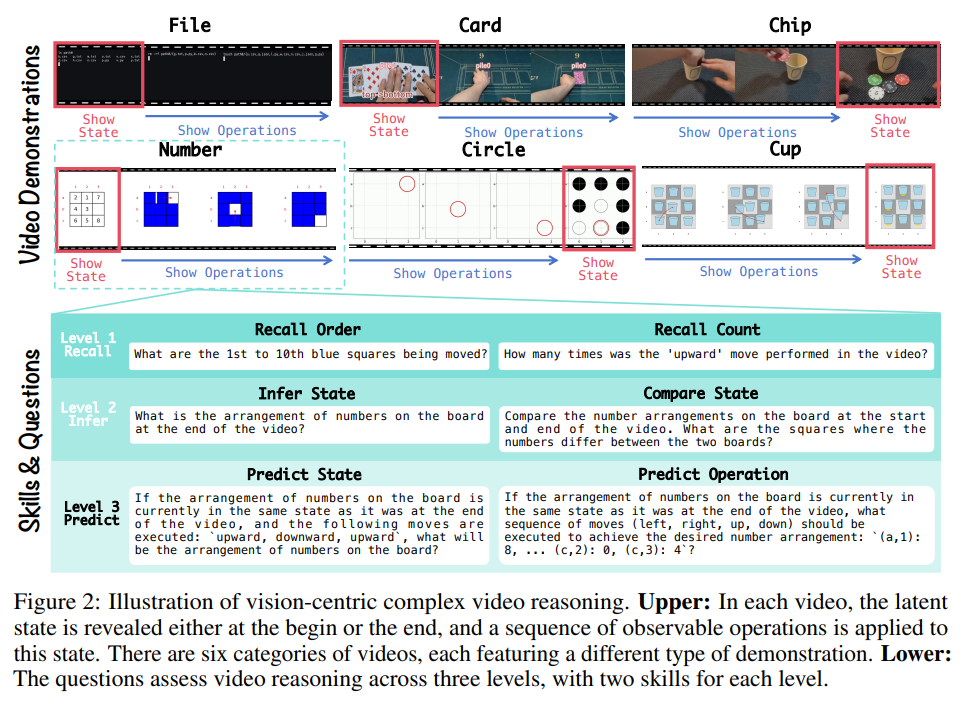

VIDEOREASONBENCH는 앞서 언급된 core ideas를 기반으로 구성됩니다. 각 video는 latent state(예: tile arrangement)에 수행되는 operations의 sequence(예: sliding movements)를 보여줍니다. visual information의 풍부함은 latent state의 크기와 operations의 수를 조정하여 유연하게 제어할 수 있습니다. "sliding number puzzle" 외에도, 저희 benchmark는 synthetic videos와 real-world videos를 모두 포함하여 다양한 scenes에 걸친 여섯 가지 유형의 video demonstrations를 포함합니다. 세 가지 levels 모두에서 reasoning을 평가하기 위해, 저희는 각 level에 두 개씩, 총 여섯 개의 해당 reasoning skills를 설계했습니다 ( Figure 2 참조).

VIDEOREASONBENCH를 기반으로, 저희는 18개의 state-of-the-art MLLMs를 종합적으로 평가합니다. 저희 결과에 따르면 대부분의 MLLMs는 vision-centric complex video reasoning에 어려움을 겪으며, 미만의 accuracies를 달성합니다. 대조적으로, thinking-augmented Gemini-2.5-Pro는 다른 모든 models를 훨씬 능가하여 의 accuracy에 도달합니다. 추가 분석에 따르면 확장된 chain-of-thought (CoT) reasoning은 기존 benchmarks에서 최소한의 performance 향상만을 제공하지만, VIDEOREASONBENCH에는 매우 중요합니다. 또한, VIDEOREASONBENCH에서 visual information을 제거하면 다른 benchmarks에 비해 performance가 훨씬 더 크게 저하되어 visual content에 대한 강한 의존성을 강조합니다.

본 연구의 주요 contributions는 다음과 같이 요약됩니다:

- 저희는 vision-centric, complex video reasoning을 평가하기 위한 VIDEOREASONBENCH를 소개합니다. 이는 models이 sequential order로 여러 actions를 정확하게 인식하고 questions에 최종적으로 답하기 위해 step-by-step reasoning을 수행해야 할 필요성을 제기하므로, 원칙적으로 reasoning depth에 대한 더 높은 요구와 visual content에 대한 더 강한 의존성을 특징으로 합니다.

- 저희는 저희 benchmark에서 대부분의 SOTA MLLMs의 우려스러운 결함을 드러냅니다: o4-mini 및 Seed1.5-VL과 같은 여러 최신 thinking models은 약 의 accuracy만을 얻습니다; non-thinking SOTA MLLMs(예: GPT-4o 및 Qwen2.5VL-72B)는 미만의 점수를 기록합니다; 모든 efficient MLLMs ()은 에도 도달하지 못합니다.

- 저희의 실험적 조사는 Gemini-2.5-Flash의 accuracy가 의 input video를 삭제하거나 thinking-mode를 비활성화하면 급격히 저하되는 반면, 기존 video benchmarks는 유사한 특성을 보이지 않음을 확인합니다. 이 결과는 vision-centric complex video reasoning abilities를 평가하기 위한 모범 사례로서 VIDEOREASONBENCH의 가치를 강조합니다.

AI 연구자들을 위한 정리노트 (1 Introduction)

핵심 문제 제기:

- 기존 video understanding benchmarks는 LLMs 및 MLLMs의 긴 chain-of-thought (CoT) reasoning 능력의 이점을 충분히 보여주거나 평가하기에는 reasoning depth가 부족함.

- 대부분의 benchmarks는 thinking mode 없이 적은 response tokens로 해결 가능 (Gemini-2.5-Flash 사례).

- 새로운 benchmarks (예: Video-MMMU, MMVU)가 등장했지만, 이들은 주로 knowledge-driven reasoning에 치중하거나, visual content에 대한 의존도가 낮음.

- VCR-Bench, MINERVA 등은 reasoning process를 평가하려 하지만, video/question의 복잡성이 기존 benchmarks와 크게 다르지 않아 깊은 video reasoning 요구에는 미치지 못함.

본 논문의 제안: VIDEOREASONBENCH

- Vision-centric, complex video reasoning 능력을 평가하기 위해 설계된 새로운 benchmark.

- 세 가지 점증적 reasoning levels 정의:

- Level 1: Video로부터 sequential visual observations를 정확히 recall.

- Level 2: Video에서 직접 관찰 불가능한 latent information infer.

- Level 3: Video를 넘어선 새로운 정보 predict.

- VIDEOREASONBENCH 특징:

- Video는 latent state (예: masked 되는 "sliding number puzzle"의 tile arrangement)에 대한 operations sequence (예: sliding movements)를 묘사.

- Latent state 크기 및 operations 수를 조절하여 visual information의 풍부함 제어 가능.

- "Sliding number puzzle" 외 6가지 유형의 video demonstrations (다양한 scenes, synthetic & real-world videos 포함).

- 3가지 reasoning levels에 걸쳐 평가하기 위해 6가지 해당 reasoning skills 설계 (각 level당 2개).

주요 실험 결과 및 주장 (Introduction 기준):

- 대부분의 state-of-the-art MLLMs (18개 평가)는 VIDEOREASONBENCH에서 저조한 performance ( accuracy).

- GPT-4o, Qwen2.5VL-72B 등 non-thinking SOTA MLLMs: accuracy.

- o4-mini, Seed1.5-VL 등 최신 thinking models: 약 accuracy.

- Efficient MLLMs (): 미만 accuracy.

- Thinking-augmented Gemini-2.5-Pro는 accuracy로 타 models 압도.

- 확장된 CoT reasoning은 기존 benchmarks에서는 효과가 미미하나, VIDEOREASONBENCH에서는 performance 향상에 결정적.

- VIDEOREASONBENCH에서 visual information 제거 시 다른 benchmarks 대비 훨씬 큰 performance 하락 → visual content에 대한 강한 의존성 반증.

- Gemini-2.5-Flash의 accuracy는 input video 삭제 또는 thinking-mode 비활성화 시 급격히 저하됨 (기존 benchmarks와 다른 양상).

본 논문의 핵심 Contributions:

- VIDEOREASONBENCH 제안: Sequential actions의 정확한 인식과 step-by-step reasoning을 요구하여 reasoning depth 및 visual content 의존도를 높인 benchmark.

- 대부분 SOTA MLLMs의 VIDEOREASONBENCH에서의 심각한 deficiency 규명.

- VIDEOREASONBENCH가 vision-centric complex video reasoning abilities 평가의 중요한 기준임을 실험적으로 입증.

쉬운 설명:

AI가 글을 이해하는 건 많이 발전했지만, 비디오를 정말 깊이 있게 이해하는 건 아직 어려운 숙제예요. 이 논문의 연구자들은 현재 AI가 비디오를 얼마나 잘 이해하는지 시험하는 방법들(benchmarks)이 충분히 어렵지 않다고 봤어요. 기존 시험들은 너무 간단한 질문을 하거나, 비디오 자체의 내용을 꼼꼼히 봐야 풀 수 있는 문제보다는 AI가 이미 알고 있는 일반 상식(knowledge-driven)에 더 의존하는 경우가 많았거든요. 그래서 AI가 여러 단계를 거쳐 복잡하게 생각하는 능력(reasoning depth)을 제대로 평가하기 어려웠죠.

이 문제를 해결하기 위해, 연구팀은 VIDEOREASONBENCH라는 새롭고 훨씬 어려운 비디오 이해력 시험 세트를 만들었어요.

이 VIDEOREASONBENCH가 특별한 점은 다음과 같아요:

- 단계별로 복잡해지는 문제: 비디오 속 상황이 순서대로 진행되고, 중요한 정보가 가려지거나 바뀌기도 해요. 예를 들어, 처음엔 다 보이던 숫자 퍼즐 조각(tiles)들이 움직이면서 어떤 조각은 가려져서(masked) 안 보이게 되는 식이죠.

- 진짜 이해력을 요구하는 질문: AI가 이런 비디오를 보고 질문에 답하려면,

- 첫째, 비디오에서 일어난 일련의 사건들(sequential visual observations)을 정확히 기억해야 하고 (Level 1),

- 둘째, 직접 눈에는 보이지 않았던 숨겨진 정보(latent information)를 추리해야 하며 (Level 2),

- 셋째, 이 모든 것을 바탕으로 비디오 내용 너머의 상황이나 결과(predict new information)까지 예측할 수 있어야 해요 (Level 3).

연구자들이 여러 최신 AI(MLLMs)들에게 이 새로운 시험을 풀어보게 했더니, 대부분은 점수가 매우 낮았어요 (대부분 미만). 하지만 특별히 "생각하는 기능"(thinking-augmented)이 강화된 Gemini-2.5-Pro라는 AI는 로 훨씬 좋은 성적을 거뒀죠.

이것은 VIDEOREASONBENCH가 정말로 비디오의 복잡한 내용을 깊이 있게 이해하고 단계별로 추론할 수 있는 AI를 가려내는 데 효과적이라는 것을 보여줘요. 결국 이런 어려운 시험을 통해 AI가 비디오를 더 잘 이해하도록 발전시키는 데 도움을 줄 수 있다는 것이 이 논문 소개 부분의 핵심 내용입니다.

이 이미지는 새로운 비디오 벤치마크인 VideoReasonBench가 기존의 다른 비디오 벤치마크들과 어떻게 다른지를 명확하게 보여주는 비교 자료입니다.

Gemini-2.5-Flash라는 AI 모델을 사용하여 4가지 다른 유형의 비디오 질문(VideoQA)에 대해, AI가 길고 상세한 추론 과정을 거치는 'Thinking' 모드와, 추론 과정 없이 바로 답을 내는 'No Thinking' 모드로 각각 답변을 생성한 결과를 보여줍니다.

1. 기존 벤치마크 3가지 (Video-MME, TempCompass, MMVU)

- Video-MME (일반 비디오 질의응답): "비디오 시작 부분에 Rakija는 왜 소개되었나?"라는 간단한 질문입니다.

- TempCompass (시간 순서 이해): "남자와 관련된 사건의 순서는 무엇인가?"를 묻습니다.

- MMVU (지식 기반 비디오 질의응답): 애니메이션을 보고 어떤 과학 과정(등온 압축 등)인지 묻습니다.

핵심 포인트: 이 세 가지 기존 벤치마크의 문제들은 AI가 'Thinking' 모드를 켜지 않아도, 즉 길게 생각하지 않고도 **모두 정답(초록색 체크 표시 ✔️)**을 맞혔습니다. 정답을 맞히는 데 사용된 토큰(AI가 사용한 글자 수와 유사한 개념)의 양도 매우 적습니다. 이는 이 문제들이 AI의 깊은 추론 능력을 요구하지 않는다는 것을 의미합니다.

2. 새로운 벤치마크 (VideoReasonBench)

- 질문: 슬라이딩 퍼즐의 초기 배열을 보여준 뒤, 타일을 가린 채로 "위, 아래, 왼쪽, 오른쪽" 등 일련의 움직임을 실행했을 때, 최종 배열이 어떻게 될지를 묻는 매우 복잡한 문제입니다.

핵심 포인트:

- 'No Thinking' 모드: AI가 깊은 생각 없이 바로 답을 내려고 하자 **틀린 답(빨간색 엑스 표시 ❌)**을 내놓았습니다.

- 'Thinking' 모드: AI가 "초기 배열은 이랬고... 빈칸의 위치를 추적해 보면... 따라서 최종 배열은 이렇다" 와 같이, 14,000개가 넘는 토큰을 사용하며 매우 길고 상세한 단계별 추론 과정을 거치자 **드디어 정답(초록색 체크 표시 ✔️)**을 맞혔습니다.

결론

이 이미지가 말하고자 하는 바는 명확합니다. 기존의 비디오 벤치마크들은 AI의 피상적인 이해도만으로도 해결이 가능했지만, VideoReasonBench는 AI가 복잡한 시각 정보를 바탕으로, 보이지 않는 상태까지 단계별로 추론하는 고차원적인 '사고(Thinking)' 능력을 사용하도록 강제합니다. 따라서 이 새로운 벤치마크를 통해 AI의 실제 시각적 추론 능력을 훨씬 더 정확하고 변별력 있게 평가할 수 있다는 것을 보여주는 강력한 예시입니다.

이 이미지는 VIDEOREASONBENCH가 어떻게 구성되어 있는지 한눈에 보여주는 핵심적인 그림입니다. 크게 두 부분으로 나눌 수 있습니다.

- 윗부분: Video Demonstrations (영상 시연)

- 아랫부분: Skills & Questions (평가 기술과 질문)

1. Video Demonstrations (영상 시연)

이 부분은 벤치마크에 사용되는 6가지 유형의 비디오 퍼즐을 보여줍니다.

- File: 커맨드 라인 환경에서의 파일 생성, 복사, 삭제 등

- Card: 카드 더미에서 카드를 뽑거나 넣는 행동

- Chip: 컵 안에 칩을 넣거나 빼는 행동

- Number: 슬라이딩 숫자 퍼즐

- Circle: 그리드 위에서 원이 움직이며 흑백 타일의 색을 바꾸는 것

- Cup: 컵 아래에 동전을 숨기고 컵의 위치를 섞는 것

가장 중요한 공통 설계 원칙은 다음과 같습니다. 모든 비디오는 상태(State)를 처음이나 끝에 단 한 번만 보여줍니다. 그리고 그 사이에는 어떤 행동(Operations)들이 일어났는지만 연속적으로 보여줍니다.

예를 들어, 숫자 퍼즐(Number)의 경우 초기 숫자 배열(Show State)을 보여준 뒤, 타일이 움직이는 과정(Show Operations)만 보여주고 최종 상태는 보여주지 않습니다. 반대로 칩(Chip) 문제의 경우, 칩을 옮기는 과정(Show Operations)을 먼저 보여주고 최종 결과(Show State)만 마지막에 공개합니다.

이러한 설계는 AI가 중간 과정을 눈으로 직접 볼 수 없기 때문에, 어떤 행동이 어떤 결과를 낳았는지 머릿속으로 계속 추적하고 추론(reasoning)하도록 강제하는 효과가 있습니다.

2. Skills & Questions (평가 기술과 질문)

이 부분은 위와 같은 비디오들을 이용해 AI의 어떤 능력을, 어떤 질문으로 평가하는지를 보여줍니다. 능력은 3가지 레벨로 나뉩니다.

- Level 1: Recall (기억) 이 단계는 영상에서 일어난 사실을 얼마나 정확하게 기억하는지 평가합니다.

- Recall Order: 행동이 일어난 순서를 기억하는지 묻습니다. (예: "파란색 사각형이 1번째부터 10번째까지 어떻게 움직였나요?")

- Recall Count: 특정 행동이 일어난 횟수를 기억하는지 묻습니다. (예: "'위로' 움직인 횟수는 총 몇 번인가요?")

- Level 2: Infer (추론) 이 단계는 기억한 정보를 바탕으로 보이지 않는 상태를 추론하는 능력을 평가합니다.

- Infer State: 최종 상태가 어떨지 추론하게 합니다. (예: "영상 끝부분의 숫자 배열은 어떻게 되어 있나요?")

- Compare State: 두 시점의 상태를 비교하게 합니다. (예: "영상 시작과 끝의 숫자 배열을 비교했을 때, 어느 칸의 숫자가 다른가요?")

- Level 3: Predict (예측) 이 단계는 추론한 정보를 바탕으로, 영상에 나오지 않은 가상의 상황을 예측하는 가장 높은 수준의 능력입니다.

- Predict State: 새로운 행동이 추가될 경우의 미래 상태를 예측하게 합니다. (예: "영상 끝 상태에서 추가로 타일을 이렇게 움직이면, 최종 배열은 어떻게 될까요?")

- Predict Operation: 특정 목표 상태를 만들기 위해 필요한 행동 순서를 예측하게 합니다. (예: "영상 끝 상태에서 이 배열을 만들려면, 어떤 순서로 타일을 움직여야 할까요?")

결론적으로, 이 이미지는 VIDEOREASONBENCH가 어떻게 단순한 시각적 인식을 넘어, 기억(Level 1) → 추론(Level 2) → 예측(Level 3) 이라는 다층적인 reasoning 능력을 체계적으로 평가하는지를 한눈에 보여줍니다.

2 VIDEOREASONBENCH

2.1 Task Definition

기존 연구에는 vision-centric complex video reasoning이 무엇인지에 대한 명확하고 확립된 정의가 부족합니다. 이러한 격차를 해소하기 위해, 저희는 video content design과 다양한 reasoning question skills을 모두 통합하여 task를 공식적으로 정의하는 체계적인 framework를 제안합니다.

2.1.1 Videos

저희는 videos를 상태 전이의 sequence, 즉 로 개념화하며, 여기서 operation 는 state 를 로 변환합니다. 저희 framework에서는 전체 sequence of operations는 visually observable하지만, states는 비디오의 시작 또는 끝에서만 partially visible합니다. 따라서 video의 visible components는 또는 입니다. 이러한 설계는 조밀한 sequence of operations를 통해 visual complexity를 강제하고, latent states에 대한 inference를 요구함으로써 reasoning complexity를 조성합니다.

Figure 2에 설명된 바와 같이, 저희는 이 원칙에 기반하여 여섯 가지 범주의 video demonstrations를 설계했습니다:

- Number: Latent state는 번호가 매겨진 tiles과 하나의 빈 tile이 있는 board입니다. Operations는 번호가 매겨진 tile을 빈 공간으로 미는 것으로 구성됩니다.

- Circle: Latent state는 검은색과 흰색 pieces를 포함하는 grid입니다. 빨간색 circle이 grid를 가로질러 이동하며, 지나가는 pieces와 그 neighbors의 색상을 뒤집습니다.

- Cup: Latent state는 비어 있거나 coin을 포함할 수 있는 사각형들이 있는 board이며, 모두 cups로 덮여 있습니다. Operations는 두 cups의 위치를 바꾸어 아래 내용물을 변경하는 것을 포함합니다.

- File: Latent state는 개의 file paths로 구성됩니다. Operations에는 이러한 경로 내/간에 files을 생성, 삭제, 복사 및 이동하는 것이 포함됩니다.

- Card: Latent state는 개의 piles of cards로 구성됩니다. Operations는 pile의 맨 위에 card를 추가하거나 맨 아래에서 card를 제거하는 것을 포함합니다.

- Chip: Latent state는 각각 여러 개의 chips를 포함하는 개의 cups로 구성됩니다. Operations는 cup에서 chip을 추가하거나 제거하는 것을 포함합니다.

2.1.2 Questions

Figure 2에서 보여주듯이, 저희 framework는 세 가지 점진적인 levels에 걸쳐 video reasoning skills를 평가합니다.

- Level 1은 fine-grained visual perception에 중점을 두며, 두 가지 sub-tasks로 구성됩니다: 정확한 sequence of operations을 기억해야 하는 Recall Order와 특정 operations의 frequency를 세는 Recall Count입니다.

- Level 2는 관찰된 operations를 기반으로 latent states에 대한 reasoning을 평가합니다. 여기에는 특정 moment의 latent state의 content를 infer해야 하는 task인 Infer State와 두 moments 간의 latent state를 comparing해야 하는 Compare State가 포함됩니다.

- Level 3는 추론된 정보를 기반으로 prediction을 요구하는 counterfactual reasoning으로 나아갑니다. 여기에는 일련의 operations 후의 future state를 predict하는 것이 목표인 Predict State와 주어진 target state에 도달하는 데 필요한 operations를 identifying하는 것을 포함하는 Predict Operation이 포함됩니다.

2.2 Data Construction

저희는 이전에 설명된 task definitions을 기반으로 dataset을 구성합니다. Table 1과 Figure 4는 dataset statistics를 요약합니다. 총체적으로, VIDEOREASONBENCH는 1,440개의 questions와 240개의 videos로 구성되며, 각 skill당 동일한 수의 questions와 각 demonstration당 동일한 수의 videos를 갖습니다. 각 video에 묘사된 operations의 수는 5에서 14개 사이입니다. File, Card, Chip을 포함하는 demonstrations의 경우, latent states는 하나 또는 두 개의 sets(예: 하나 또는 두 개의 piles of cards)로 구성되며, 각 카테고리에는 120개의 videos가 포함됩니다. Number, Circle, Cup demonstrations의 경우, latent states는 에서 범위의 boards로 표현되며, 역시 카테고리당 120개의 videos가 있습니다. 대규모로 dataset을 수집하기 위해, 저희는 Figure 3에 시연된 바와 같이 video engine과 question engine이라는 두 가지 주요 components로 구성된 semi-automatic data construction framework를 설계했습니다.

2.2.1 Video Engine

State size 과 number of operations 가 주어지면, video engine은 Number demonstration을 위한 정수 행렬 과 같은 state를 무작위로 초기화하는 것으로 시작합니다. 그런 다음 각 demonstration type에 특정한 사전 정의된 규칙에 따라 operations sequence와 해당 state transitions, 즉 을 생성합니다. 이러한 transitions은 video construction process를 안내하는 "script"를 형성합니다. Number, Circle, Cup과 같은 demonstrations의 경우, videos는 Python Matplotlib 라이브러리를 사용하여 프로그래밍 방식으로 생성됩니다. File demonstration에서는 command-line interface 내에서 file operations을 simulate하고 screenshots을 capture합니다. Card 및 Chip과 같은 real-world demonstrations의 경우, 실제 videos를 수동으로 기록합니다.

2.2.2 Question Engine

각 video demonstration과 reasoning skill의 combination에 대해 특정 question templates를 정의합니다. 예를 들어, Number demonstration에서 Infer State skill을 사용하는 경우 해당 template는 "비디오의 {timestamp}에서 보드 위의 숫자 배열은 무엇입니까?"이며, 여기서 timestamp {start, end}는 latent state가 비디오의 시작 또는 끝에서 드러나는지에 따라 결정됩니다. Task에 대한 정확한 이해를 돕기 위해, 각 prompt에는 video demonstration에 대한 자세한 설명도 포함되어 state transition rules를 명확히 합니다. 또한, model response에서 final answer를 추출하는 데 도움이 되도록 question 뒤에 "Final Answer: 뒤에 최종 답변의 요약을 제공하십시오."라는 answer prompt를 추가합니다. 전체 prompts와 templates의 포괄적인 목록은 Appendix A.1에 제공됩니다. 이러한 templates와 관련된 state transition data를 사용하여, 저희는 수작업으로 만든 규칙을 통해 자동으로 answers를 생성하여 효율적이고 정확한 dataset construction을 가능하게 합니다.

2.3 Evaluation Scheme

Predict Operation category를 제외하고, VIDEOREASONBENCH의 모든 questions는 ground-truth answers와 쌍을 이룹니다. 이러한 questions의 경우, 저희는 question, ground-truth answer, 그리고 model-generated answer를 text-only LLM에 inputting하여 model responses를 평가하며, 이 LLM은 response의 correctness를 평가합니다. 그러나 Predict Operation category에서는 여러 유효한 sequences of operations이 주어진 target state를 달성할 수 있으므로 ground-truth answers가 제공되지 않습니다. 대신, 저희는 text-only LLM을 사용하여 model response에서 operations를 extract하고, video generation engine에서 사용된 것과 동일한 functions를 사용하여 해당 state transitions를 simulate한 다음, 결과 state가 target state와 일치하는지 verify합니다. 자세한 evaluation 및 operation extraction prompts는 Appendix A.2에 제공됩니다.

이 이미지는 VIDEOREASONBENCH 데이터셋을 어떻게 기술적으로 만들었고, 그 통계적 특징이 무엇인지를 보여주는 그림입니다. 세 부분(Figure 3, Figure 4, Table 1)으로 나누어 설명해 드릴게요.

1. 데이터 생성 과정 (Figure 3)

이 그림은 VIDEOREASONBENCH의 영상과 질문-답변 쌍이 어떤 과정을 거쳐 자동으로 만들어지는지를 보여주는 순서도입니다.

- 설정 (Configuration): 먼저 퍼즐의 크기(State Size: N)와 행동의 횟수(Operation Count: T)를 정합니다.

- 비디오 엔진 (Video Engine): 이 설정값을 Video Engine에 넣습니다.

- 상태 변화 (State Transitions): Video Engine은 먼저 영상의 논리적인 '대본'에 해당하는 State Transitions()를 생성합니다. 이것이 영상의 핵심 줄거리입니다.

- 영상 제작 및 질문 생성: 이 '대본'은 두 곳으로 전달됩니다.

- 한쪽에서는 이 대본을 바탕으로 **실제 영상(Video)**을 만듭니다. 만드는 방식은 퍼즐 종류에 따라 세 가지입니다.

- matplotlib: 숫자 퍼즐처럼 컴퓨터 그래픽으로 만드는 영상

- command-line: 파일 옮기기처럼 컴퓨터 화면을 캡처하는 영상

- manual shot (카메라 아이콘): 카드나 칩처럼 실제 손으로 촬영하는 영상

- 다른 한쪽에서는 이 대본을 **질문 엔진(Question Engine)**으로 보내, 대본의 내용과 미리 정해진 규칙에 따라 **질문과 정답 쌍(QA Pairs)**을 만듭니다.

- 한쪽에서는 이 대본을 바탕으로 **실제 영상(Video)**을 만듭니다. 만드는 방식은 퍼즐 종류에 따라 세 가지입니다.

핵심은, 동일한 '대본'에서 영상과 질문을 만들기 때문에 질문 내용이 영상의 실제 내용과 완벽하게 일치한다는 것입니다.

2. 데이터 분포 (Figure 4)

이 두 개의 원그래프는 데이터셋이 얼마나 균형 잡혀 있는지를 보여줍니다.

- 왼쪽 (Video Distribution): 영상의 종류별 분포입니다. 6가지 영상(Number, Chip, Card 등)이 각각 60개씩, 정확히 **17%**의 동일한 비율을 차지합니다.

- 오른쪽 (Question Distribution): 질문의 유형별 분포입니다. 6가지 질문 스킬(Recall Order, Predict State 등)이 각각 240개씩, 정확히 **17%**의 동일한 비율을 차지합니다.

결론적으로, 특정 유형의 영상이나 특정 유형의 질문에 치우치지 않은 매우 공정하고 균형 잡힌 데이터셋이라는 것을 알 수 있습니다.

3. 데이터 통계 (Table 1)

이 표는 데이터셋에 대한 구체적인 수치를 보여줍니다.

- 질문/프롬프트 단어 수: 질문과 전체 프롬프트의 평균 및 최대 단어 수를 보여줍니다. 평균 프롬프트 단어 수가 198.8개로, AI에게 주어지는 설명이 꽤 길다는 것을 알 수 있습니다.

- 영상 길이: 영상의 평균 길이는 54.3초입니다.

- 행동 횟수별 영상 수: 영상에 포함된 행동(operation)의 수가 5~9개인 영상이 120개, 10~14개인 영상이 120개로, 난이도가 낮은 문제와 높은 문제가 균등하게 배분되어 있습니다.

- 상태 크기별 영상 수: 퍼즐 판의 크기(state size)가 작은 영상이 120개, 큰 영상이 120개로, 문제의 복잡도 또한 균등하게 배분되어 있습니다.

요약하자면, 이 이미지는 VIDEOREASONBENCH가 체계적인 자동화 공정을 통해, 내용과 질문이 완벽히 일치하며, 종류/유형/난이도/복잡도 모든 면에서 공정하게 설계된 고품질 데이터셋임을 보여줍니다.

AI 연구자들을 위한 정리노트 (2 VIDEOREASONBENCH)

핵심 목표: Vision-centric complex video reasoning 평가를 위한 VIDEOREASONBENCH의 체계적 정의 및 구축.

2.1 Task Definition (작업 정의)

- 기본 개념: Video를 일련의 상태 전이(sequence of state transitions) 로 모델링.

- : Operation (행동)

- : State (상태)

- 핵심 설계 원칙:

- 모든 operations ()는 visually observable (시각적으로 관찰 가능).

- States ()는 부분적으로만 visible (비디오 시작() 또는 끝()에서만 전체 상태 공개, 중간 과정의 상태는 latent).

- 목적: 조밀한 operations sequence를 통해 visual complexity를 높이고, latent states에 대한 inference를 요구하여 reasoning complexity를 증진.

- Video Demonstrations (6가지 유형): 위 원칙에 기반.

- Number: 보드, 숫자 tiles, 빈칸, tile 슬라이딩 operation.

- Circle: grid, 흑백 pieces, 빨간 circle 이동하며 자신 및 neighbors 색상 반전.

- Cup: 보드, cups 아래 coin 유무, cups 위치 교환 operation.

- File: 개 file paths, files 생성/삭제/복사/이동 operations.

- Card: 개 piles of cards, card 맨 위 추가/맨 아래 제거 operations.

- Chip: 개 cups 안의 chips, chips 추가/제거 operations.

- Questions (3 Reasoning Levels, 6 Skills):

- Level 1 (Fine-grained visual perception):

- Recall Order: Operations sequence의 정확한 순서 기억.

- Recall Count: 특정 operations의 frequency 계산.

- Level 2 (Reasoning about latent states):

- Infer State: 특정 시점의 latent state content infer.

- Compare State: 두 시점 간 latent state comparing.

- Level 3 (Counterfactual reasoning & prediction):

- Predict State: Operations sequence 후의 future state predict.

- Predict Operation: 주어진 target state 도달에 필요한 operations identifying.

- Level 1 (Fine-grained visual perception):

2.2 Data Construction (데이터 구축)

- Dataset 규모: 총 1,440 questions, 240 videos. 각 skill 및 demonstration 유형별 균등 분배. Video 당 operations 수: 5~14개.

- Latent State 구성:

- File, Card, Chip: 1~2개 sets (예: piles of cards), 카테고리별 120 videos.

- Number, Circle, Cup: ~ boards, 카테고리별 120 videos.

- Semi-automatic data construction framework:

- Video Engine:

- State () 및 operations 수 () 기반으로 초기 state 랜덤 생성 (예: Number의 ).

- 정의된 규칙에 따라 operations sequence 및 state transitions ("script") 생성.

- Video 생성 방식: Python Matplotlib (프로그래밍 방식: Number, Circle, Cup), command-line interface simulation & screenshots (File), 실제 수동 촬영 (real-world demonstrations: Card, Chip).

- Question Engine:

- 각 video demonstration / reasoning skill 조합별 question templates 정의.

- Prompt에는 video demonstration의 상세 설명 및 state transition rules 포함.

- Model response에서 final answer 추출 용이성을 위해 "Final Answer:" prompt 추가.

- Templates 및 state transition data를 활용, 수작업 규칙 기반으로 answers 자동 생성 (세부사항: Appendix A.1).

- Video Engine:

2.3 Evaluation Scheme (평가 방식)

- 일반 Questions (Predict Operation 제외): Ground-truth answers 존재. Model-generated answer와 ground-truth answer를 text-only LLM에 입력하여 correctness 평가.

- Predict Operation Category: 정해진 ground-truth answer 없음 (다수의 유효한 operations sequence 가능).

- Text-only LLM을 사용해 model response에서 operations extract.

- 추출된 operations를 video generation engine과 동일한 functions로 simulate.

- 결과 state가 target state와 일치하는지 verify. (세부사항: Appendix A.2).

쉬운 설명:

이 부분은 VIDEOREASONBENCH라는 새로운 AI 비디오 이해력 시험을 어떻게 만들었는지 자세히 설명하는 내용이에요.

1. Task Definition (시험의 규칙 정하기):

- 비디오는 어떻게 생겼나?

- 비디오는 마치 짧은 퍼즐 게임 같아요. 일련의 행동들(operations)이 순서대로 보이는데 (예: 퍼즐 조각 옮기기), 게임 판 전체의 상황(state)은 항상 다 보여주지 않아요. 어떤 비디오는 처음 상태만 보여주고 여러 행동을 한 뒤 마지막 상태를 맞춰야 하고, 어떤 비디오는 여러 행동과 마지막 상태를 보여주고 처음 상태나 중간 과정을 추리해야 해요. 그래서 AI는 단순히 눈에 보이는 것뿐만 아니라, 가려진 부분(latent states)까지 생각해야 해서 더 어려워요.

- 이런 원리로 "숫자 퍼즐", "동그라미 옮기기", "컵 속 동전 찾기", "파일 정리하기", "카드 쌓기", "칩 옮기기" 같은 6가지 종류의 비디오 퍼즐(video demonstrations)을 만들었어요.

- 질문은 어떤 종류가 있나?

- AI의 사고 능력을 단계별로 평가하기 위해 세 가지 수준(levels)의 질문을 만들었어요.

- Level 1 (잘 봤니?): "어떤 순서로 행동했어?", "특정 행동을 몇 번 했어?" 같이 비디오에서 본 것을 정확히 기억하는지(fine-grained visual perception) 물어봐요. (관련 능력: Recall Order, Recall Count)

- Level 2 (숨겨진 것도 알겠니?): "지금 안 보이는 부분까지 포함해서 게임 판이 어떻게 됐을까?", "이전 상태랑 지금 상태는 어떻게 달라?" 같이 본 행동을 바탕으로 숨겨진 정보를 추리(reasoning about latent states)하는지 물어봐요. (관련 능력: Infer State, Compare State)

- Level 3 (예측하거나 계획할 수 있겠니?): "만약 이런 행동들을 추가로 하면 어떻게 될까?", "이런 결과를 만들려면 어떤 행동들을 해야 할까?" 같이 추리한 정보를 바탕으로 예측하거나 계획(counterfactual reasoning & prediction)하는지 물어봐요. (관련 능력: Predict State, Predict Operation)

- AI의 사고 능력을 단계별로 평가하기 위해 세 가지 수준(levels)의 질문을 만들었어요.

2. Data Construction (시험 자료 만들기):

- 이런 규칙에 맞춰서 총 240개의 비디오와 1,440개의 질문을 만들었어요.

- 비디오 만드는 방법도 다양해요. 어떤 건 컴퓨터 프로그램으로 게임 화면처럼 만들고(Number, Circle, Cup), 어떤 건 컴퓨터 파일 정리하는 화면을 흉내 내고(File), 어떤 건 실제 물건을 가지고 직접 촬영했어요(Card, Chip).

- 질문과 정답도 효율적으로 만들기 위해, 일부는 자동으로 생성하는 시스템(semi-automatic data construction framework)을 이용했어요. 각 질문에는 비디오 규칙에 대한 자세한 설명도 덧붙여서 AI가 문제를 잘 이해하도록 도왔어요.

3. Evaluation Scheme (AI 답안 채점 방법):

- 대부분의 질문에는 정해진 답(ground-truth answers)이 있어요. AI가 내놓은 답이 이 정답과 일치하는지 다른 글만 이해하는 AI(text-only LLM)를 이용해 채점해요.

- 하지만 "어떤 행동을 해야 목표에 도달할까?"(Predict Operation) 같은 질문은 여러 가지 정답이 있을 수 있어요. 이럴 때는 AI가 제시한 행동들을 실제로 시뮬레이션 해보고, 정말 목표한 상태가 되는지 확인해서 점수를 매겨요.

3 Experiments

3.1 Experimental Setups

Evaluated Models. VIDEOREASONBENCH를 기반으로, 우리는 광범위한 MLLMs에 대한 포괄적인 평가를 수행합니다: Proprietary models에는 진보된 GPT-4o (2024-11-20)와 Gemini-2.0-Flash, 그리고 최신 thinking-augmented MLLMs인 o4-mini, Seed 1.5-VL, Gemini 2.5 (Flash and Pro-0506)가 포함됩니다. Open-source models에는 mPLUG-Owl3, MiniCPM-V 2.6, MiniCPM-o 2.6, Kimi-VL-A3B, LLaVA-OneVision (7B and 72B), LLaVA-Video (7B and 72B), InternVL3 (8B and 78B), Qwen2.5-VL (7B and 72B)가 포함됩니다. 이 models은 video understanding tasks에서 현재의 SOTA를 대표합니다.

Implementation Details. Proprietary models의 경우, 공식 APIs를 사용하여 model responses를 얻습니다. Open-source models의 경우, 공개적으로 사용 가능한 checkpoints를 사용하여 local inference를 수행합니다. evaluation을 위해, 우리는 Qwen2.5-72B를 judge model로 채택합니다. 향후 연구를 지원하기 위해, 우리의 benchmark는 널리 사용되는 VLMEvalKit framework에 통합되었으며, 우리의 code repository에서 사용할 수 있습니다. 우리는 또한 향후 공식 VLMEvalKit에 VIDEOREASONBENCH를 기여할 계획입니다. generation configurations 및 video processing에 관한 추가적인 세부 정보는 부록 B.1에 제공됩니다. VIDEOREASONBENCH에 대한 human performance를 평가하기 위해, 우리는 전체 1,440개 중 240개의 examples를 무작위로 추출했으며, 각 reasoning skill당 40개의 examples를 선택했습니다. 저자 중 세 명이 독립적으로 데이터에 annotate했습니다. 각 annotator에게는 models에 보여준 것과 동일한 video와 question 쌍이 제시되었으며, free-text format으로 답변을 제공했습니다.

3.2 Main Results

표 2는 제안된 VIDEOREASONBENCH에 대한 다양한 MLLMs와 human baseline의 평가 결과를 보여주며, 이를 통해 다음과 같은 결론을 도출할 수 있습니다.

현재의 MLLMs는 vision-centric complex video reasoning에 어려움을 겪습니다. 모든 open-source "Efficient Models"(<10B active parameters)는 2% 미만의 accuracy를 달성하며 저조한 성능을 보입니다. open-source "Flagship Models"(72B+ active parameters)와 GPT-4o 역시 10% 미만의 accuracies로 어려움을 겪습니다. o4-mini와 Seed1.5-VL과 같은 가장 최신의 thinking-enhanced models조차도 각각 10.7%와 11.5%의 점수를 기록하며 미미한 개선만을 보였습니다. 더욱이, 대부분의 models은 "Level 1" tasks에서도 30% accuracy를 넘지 못하는데, 이는 dense temporal information의 fine-grained perception이 현재 MLLMs에게 여전히 어려운 과제임을 시사합니다. 대조적으로, Gemini 2.5 시리즈는 현저하게 더 강력한 performance를 보여주며, Gemini-2.5-Pro-0506은 56%의 accuracy를 달성했습니다. 그럼에도 불구하고, 73.8%에 달하는 human performance와 비교했을 때 상당한 격차가 남아있습니다. 이러한 결과는 가장 진보된 MLLMs조차도 VIDEOREASONBENCH가 제기하는 complex video reasoning tasks에서 human-level capability에 미치지 못함을 시사합니다.

VIDEOREASONBENCH는 사람에게도 상당한 어려움을 제기합니다. Human annotators 또한 상당한 도전에 직면하는데, 단일 질문에 답하기 위해서는 비디오 내에서 여러 개의 개별 operations(최대 14개)를 인식하고 해당하는 latent state transitions를 정확하게 infer해야 하기 때문입니다. 이 과정은 인지적으로 부담이 크고 시간이 많이 소요되며, annotators는 질문당 평균 223.2초를 사용했습니다. 더욱이, 단 한 번의 오해가 부정확한 final answer로 이어질 수 있으며, 이는 특히 Level 3 skills를 요구하는 tasks에서 상대적으로 낮은 human accuracy를 설명하는 데 도움이 됩니다.

Thinking은 VIDEOREASONBENCH의 performance에 매우 중요합니다. 전통적인 non-thinking MLLMs와 비교할 때, thinking-enhanced models은 상당한 advantage를 보입니다. 예를 들어, 동일한 model인 Gemini-2.5-Flash를 사용하더라도, thinking mode를 활성화하면 performance가 18.8%에서 27.4%로 크게 향상됩니다. 이는 VIDEOREASONBENCH가 제기하는 complex video reasoning 문제를 해결하는 데 있어 explicit reasoning mechanisms과 extended CoT chains의 중요성을 강조합니다. 다양한 video understanding benchmarks에서 thinking의 역할에 대한 더 깊은 분석은 섹션 3.3.1에서 제공됩니다.

Reasoning difficulty는 Level 1에서 Level 3로 갈수록 증가합니다. MLLMs와 인간 모두에서 performance는 Level 1에서 Level 3 reasoning skill로 갈수록 일관되게 감소합니다. 이 추세는 더 높은 수준의 reasoning skills이 더 낮은 수준의 skills 위에 구축되도록 한 benchmark의 의도된 설계와 강력하게 일치합니다. 이러한 설계는 세 가지 레벨에 걸쳐 난이도가 증가함을 보장합니다.

3.3 Analysis

3.3.1 Effect of Thinking

extended CoT reasoning의 이점은 video understanding 분야에서 아직 충분히 탐구되지 않았습니다. 이 격차를 해소하기 위해, 우리는 reasoning의 길이를 변화시키는 것이 VIDEOREASONBENCH와 각기 다른 능력에 초점을 맞춘 네 가지 대표적인 video understanding benchmarks(TempCompass (multi-choice), Video-MME (w/o subwords), MMVU, Video-MMMU)의 performance에 어떻게 영향을 미치는지 체계적으로 조사합니다. 우리는 "Thinking Budget" parameter를 통해 reasoning tokens의 수를 명시적으로 제어할 수 있는 Gemini-2.5-Flash model을 활용합니다.

그림 5에서 볼 수 있듯이, thinking budget이 증가함에 따라 VIDEOREASONBENCH는 약 9% 상승하며 눈에 띄는 accuracy improvement를 보여줍니다. 대조적으로, 기존 benchmarks는 동일한 thinking budget 증가가 적용되었을 때 모두 2.5% 미만의 미미한 gains을 보입니다. 이는 thinking이 기존 benchmarks보다 VIDEOREASONBENCH의 performance에 더 많이 기여한다는 것을 시사합니다. 추가적으로, thinking budget이 0으로 설정되었을 때 response tokens의 수는 benchmarks마다 현저하게 다릅니다: 주로 기본적인 temporal 및 general video understanding을 테스트하는 TempCompass와 Video-MME의 경우, responses는 수십 개의 tokens만을 요구하며 간결합니다. 반대로, knowledge-intensive reasoning을 요구하는 MMVU와 Video-MMU는 평균 183개와 1,537개의 tokens로 상당히 높은 response token counts를 보입니다. 특히, VIDEOREASONBENCH는 명시적인 "thinking" resources가 없을 때 평균 1,860.1개의 tokens로 훨씬 더 긴 responses를 생성합니다. 이 패턴은 VIDEOREASONBENCH의 도전적인 특성을 강조합니다.

3.3.2 Effect of Vision Reliance

VIDEOREASONBENCH는 fine-grained visual perception을 요구하는 video reasoning을 평가하도록 설계되었습니다. visual information에 대한 의존도를 평가하고 기존 benchmarks와 비교하기 위해, 우리는 네 가지 다른 visual input conditions 하에서 Gemini-2.5-Flash의 performance를 평가합니다: full video, video의 50%를 무작위로 잘라낸 버전, single center frame, 그리고 text-only input (visual content 없음).

결과는 표 3에 나와 있습니다. reasoning을 포함하는 MMVU와 Video-MMMU의 경우, video frames의 절반을 제거하면 7% 미만의 relative performance drop이 발생합니다. 대조적으로, 동일한 조건에서 VIDEOREASONBENCH의 performance는 55% 감소합니다. visual input이 single frame으로 더욱 줄어들었을 때, VIDEOREASONBENCH는 98.2%의 극적인 performance decline을 보인 반면, 기존 benchmarks에서 관찰된 가장 큰 하락은 28.3%에 불과했습니다. 이러한 결과는 VIDEOREASONBENCH가 현재의 video understanding benchmarks보다 훨씬 더 높은 수준의 vision reliance를 요구함을 시사합니다.

3.3.3 Effect of Video Complexity

섹션 2.2에서 소개된 바와 같이, 우리의 videos는 operation count와 state size에서 다양하며, 이 두 가지 모두 visual information의 풍부함에 영향을 미칩니다. 표 4에서 볼 수 있듯이, MLLMs의 performance는 일반적으로 operation count와 state size가 증가함에 따라 감소합니다. 이러한 결과는 video reasoning complexity가 이 두 parameters를 조정함으로써 효과적으로 제어될 수 있으며, 향후 평가에서 benchmark의 difficulty를 유연하게 scaling할 수 있음을 나타냅니다.

3.4 Effect of State Reveal Timing

VIDEOREASONBENCH에서, latent state는 각 video의 시작 또는 끝에 공개됩니다. 표 5는 이 두 가지 다른 reveal timings 하에서의 model performance를 비교합니다. 보이는 바와 같이, 네 개의 MLLMs 모두 latent state가 끝에 공개될 때 더 낮은 accuracy를 보입니다. 이러한 performance drop은 이 설정에서 models이 state transitions의 sequence를 거꾸로 reasoning하여 initial state를 infer해야 하기 때문에 발생합니다. 이 reverse inference는 자연스러운 forward order로 transitions를 따르는 것보다 본질적으로 더 어렵습니다.