AI바라기의 인공지능

LLM : 논문리뷰 : CoAT: Chain-of-Associated-Thoughts Framework for Enhancing Large Language Models Reasoning 본문

LLM : 논문리뷰 : CoAT: Chain-of-Associated-Thoughts Framework for Enhancing Large Language Models Reasoning

AI바라기 2025. 2. 7. 13:59Overall Summary:

CoAT framework는 MCTS와 associative memory의 synergy를 통해 LLM reasoning 능력을 혁신적으로 향상시키는 새로운 접근 방식을 제시한다. Dynamic knowledge integration 및 iterative reasoning을 가능하게 함으로써 기존 LLM의 정적 inference 방식의 한계를 극복하고, accuracy, coherence, diversity 측면에서 superior performance를 입증했다. 향후 computational efficiency 개선 및 associative memory 고도화 연구를 통해 real-world application에서의 잠재력을 더욱 확장할 수 있을 것으로 기대된다. CoAT framework는 external real-time knowledge 통합 및 인간-유사 reasoning을 향한 중요한 발걸음을 내딛었다는 점에서 큰 의의를 가진다.

쉬운 설명:

CoAT framework는 사람의 뇌가 생각할 때처럼, 질문을 받으면 바로 답하는 대신, "연상 작용" 을 통해 답을 찾아가는 방식과 비슷합니다. 마치 Monte Carlo Tree Search (MCTS) 라는 길 찾기 알고리즘을 이용하여, 여러 갈래의 생각의 길을 탐색하고, 각 갈림길에서 얻은 새로운 정보 (associative memory) 를 통해 생각을 더욱 풍부하게 만드는 것입니다. 기존 LLM은 질문을 받으면 즉각적으로 답을 내놓는 "fast thinking" 방식이었지만, CoAT는 인간처럼 천천히 생각하고, 관련된 정보를 계속 찾아보면서 답을 찾아가는 "slow thinking" 방식을 모방한 것입니다. 이 덕분에 CoAT는 더욱 정확하고, 풍부하며, 다양한 답변을 생성할 수 있게 되었습니다.

CoAT 논문 학습 노트

Purpose of the Paper:

- 기존 LLM 연구는 대부분 'fast thinking' 접근 방식에 집중, 단일 쿼리 및 LLM 자체의 reasoning 능력에 의존.

- OpenAI-01 등장 이후 'slow thinking' 방식이 주목받았지만, 여전히 초기 입력 정보와 LLM의 논리적 reasoning 능력에 의존하는 한계 존재.

- 인간의 사고 과정처럼 끊임없이 지식을 연상하고 보충하는 능력을 LLM에 부여하고자 함.

- 기존 LLM inference 방식의 정적 한계를 극복, dynamic하고 iterative reasoning이 가능한 새로운 framework 제시 목표.

Key Contributions:

- CoAT (Chain-of-Associated-Thoughts) framework 제안:

- MCTS (Monte Carlo Tree Search) 알고리즘과 'associative memory' 메커니즘의 혁신적인 결합.

- MCTS의 구조적 탐색 능력과 associative memory의 adaptive learning capacity를 융합하여 LLM search space 확장.

- 다양한 reasoning pathways 탐색 및 real-time knowledge base 업데이트 가능.

- 기존 LLM inference의 정적인 한계를 극복하고, dynamic하고 iterative reasoning process 구현.

- Novelty: LLM inference 과정에 associative memory 메커니즘을 최초로 적용, 인간의 사고 방식 모방 시도.

- Associative Memory 메커니즘 개발:

- LLM reasoning 과정 중 dynamic하게 new key information 통합하는 메커니즘.

- 각 node에서 생성된 content에 기반하여 실시간으로 relevant knowledge retrieval 및 self-augmentation 수행.

- 기존 external knowledge augmentation 방식의 한계 (과도한 irrelevant information 포함, critical content 부족) 극복.

- Reasoning에 beneficial하고 historical content에 previously mentioned 되지 않은 associative content 생성 목표.

- Novelty: inference 과정 중간에 실시간으로 relevant knowledge를 주입하여 reasoning 효율성 및 quality 향상.

- Optimized MCTS 알고리즘 설계:

- Associative content와 generated content를 tree node search를 통해 체계적으로 통합하는 MCTS 알고리즘 최적화.

- Node value 평가 시 generated content quality와 associative content quality를 모두 고려하는 평가 방식 도입.

- MCTS search process 종료 조건 및 depth 제한 hyper-parameter (D) 도입하여 효율성 향상.

- Novelty: MCTS 알고리즘에 associative memory 개념을 효과적으로 통합하고, LLM reasoning에 특화된 방식으로 최적화.

- 실험적 검증:

- 다양한 generative 및 reasoning task에서 CoAT framework의 effectiveness 검증.

- Accuracy, coherence, diversity 측면에서 기존 inference 방식 대비 outperform 입증.

- 질적/양적 실험 결과를 통해 CoAT framework의 superior performance 입증.

- Novelty: CoAT framework의 성능을 다양한 task에서 rigorous하게 평가하고, state-of-the-art 성능을 입증.

Experimental Highlights:

- Qualitative Evaluation (Figure 5):

- Qwen2.5-32B + CoAT framework가 text volume 및 coverage 측면에서 가장 풍부한 content 생성.

- chatGPT, Qwen2.5-32B 대비 "Ethical and Regulatory Frameworks" category를 supernumerary category로 포함. (AI 연구에 중요)

- 각 category 내 content 또한 타 모델 대비 abundant.

- Result Highlight: CoAT framework가 rich associative knowledge를 효과적으로 활용하여 comprehensive하고 다양한 관점을 제공하는 답변 생성 입증.

- Quantitative Performance in RAG Generation:

- Datasets: HotpotQA, 2WikiMultiHopQA

- Metrics: Exact Match (EM), F1 score

- Baselines: NativeRAG, IRCoT, HippoRAG, LATS, KAG

- CoAT framework가 RAG task에서 baselines 대비 superior performance 달성.

- Result Highlight: CoAT framework의 associative memory 메커니즘이 extended knowledge 통합 및 reasoning 능력 향상에 효과적임을 입증.

- Quantitative Performance in Code Generation:

- Datasets: HumanEval, MBPP, HumanEval-X

- CoAT framework + base models (Qwen2.5-7B-Instruct, Qwen2.5-14B-Instruct)가 fine-tuned models (Qwen2.5-Coder-7B-Instruct, Qwen2.5-Coder-14B-Instruct) 대비 comparable performance 달성.

- Result Highlight: CoAT framework가 특정 domain에 fine-tuning 없이도 general-purpose LLM의 reasoning 능력을 향상시켜 code generation task에서도 경쟁력 있는 성능을 확보 가능함을 시사.

Limitations and Future Work:

- Computational Cost: MCTS 알고리즘 특성상 computational cost 증가 가능성 존재.

- Future Work: MCTS 알고리즘 효율성 개선 연구 필요 (e.g., pruning 기법, parallel processing).

- Associative Memory Quality: Associative memory quality가 reasoning performance에 critical하게 작용.

- Future Work: 보다 sophisticated associative memory 메커니즘 연구 필요 (e.g., knowledge graph 활용, external knowledge source 다양화).

- Generalization: 다양한 task 및 domain에서의 CoAT framework generalization 능력 추가 검증 필요.

- Future Work: 더욱 다양한 task 및 dataset에 대한 실험 확장 및 robustness 평가 필요.

- Real-world application: CoAT framework를 real-world application에 적용 및 effectiveness 검증 필요.

- Future Work: 실제 서비스 및 시스템에 CoAT framework 통합 및 end-to-end 성능 평가 필요.

Abstract

LLM 기술에 대한 연구는 빠르게 부상하고 있으며, 대부분 inference에 'fast thinking' 접근 방식을 사용합니다. 대부분의 LLM은 단일 쿼리와 LLM의 reasoning 능력을 기반으로 final result를 generate 합니다. 그러나 OpenAI-o1의 등장으로 'slow thinking' 기술이 increasingly attention을 받게 되었는데, 이는 해당 process가 인간의 사고 과정에 더 가깝기 때문입니다. 인간이 사고 과정에서 지속적으로 연관시키고 지식을 보충하는 능력에서 영감을 받아, 우리는 Monte Carlo Tree Search (MCTS) algorithm과 'associative memory'라고 불리는 새로운 핵심 information을 통합하는 dynamic mechanism 간의 innovative synergy를 도입하는 새로운 Chain-of-Associated-Thoughts (CoAT) framework를 개발했습니다.

MCTS의 체계적인 탐색 능력과 associative memory의 adaptive learning capacity를 결합함으로써, CoAT는 LLM search space를 크게 확장하여 framework가 다양한 reasoning pathways를 탐색하고 real-time으로 knowledge base를 dynamically update할 수 있도록 합니다. 이를 통해 framework는 이전의 inferences를 다시 방문하고 refine할 뿐만 아니라 evolving information을 adaptively incorporate하여 final output이 정확하고 포괄적임을 보장합니다. 우리 framework의 effectiveness를 validate하기 위해 광범위한 generative 및 reasoning tasks에 대한 extensive experiments를 수행했습니다. 이러한 experiments는 우리 framework가 accuracy, coherence 및 diversity에서 conventional inference processes보다 outperform 함을 보여주었습니다. Framework의 ability는 contextually relevant information results를 retain하면서 search space를 반복적으로 expand합니다.

1 Introduction

Large Language Models (LLMs)는 natural language processing의 초석으로 빠르게 자리 잡았으며, conversational agents부터 complex decision-making systems에 이르기까지 다양한 applications을 지원합니다. 그 operation의 중심에는 inference process가 있으며, 여기서 LLMs는 pre-trained stage에서 autoregressive learning algorithm에 의해 massive datasets로부터 학습된 패턴을 기반으로 contents를 generate 합니다. 대부분의 LLM (GPTs, Llamas, Qwens 등)은 LLM models의 pre-trained reasoning capabilities에 크게 의존하는 'fast thinking' 접근 방식을 inference에 사용합니다. 이 approach는 single query를 처리하여 final result를 생성합니다. 많은 tasks에 효과적이지만, 이 approach는 종종 nuanced, iterative reasoning 또는 new information에 대한 adaptation이 필요한 문제에서 어려움을 겪습니다.

최근의 발전은 'fast thinking'에 대한 대안을 탐색하기 시작했으며, human thinking processes와 더 closely align되는 'slow thinking' methodologies를 도입했습니다. 이 idea는 inference 중에 deliberate, iterative reasoning, 그리고 historical contents 또는 external knowledge의 integration을 emphasize합니다. 주목할 만한 프로젝트인 OpenAI-o1은 이 domain에서 significant interest를 불러일으켰으며, reasoning capabilities를 improve하기 위한 'slow thinking' frameworks의 potential을 보여주었습니다. 그러나 slow thinking은 단지 reasoning process를 더 작은 단계로 세분화하고 이미 generated된 것을 다시 생각하는 것을 포함합니다. process 전반에 걸쳐 여전히 initial input information과 LLM 자체의 logical reasoning abilities에 의존합니다.

우리는 human thinking 중에 지속적으로 연관시키고 지식을 보충하는 human ability에서 영감을 받아 Chain-of-Associated-Thoughts (CoAT) framework를 제안합니다. 우리가 아는 한, associative memory mechanisms은 LLM processes에서 human thought를 simulate하기 위해 처음 적용되었습니다. associative memory mechanism은 CoAT가 inference 중에 new key information을 dynamically incorporate하여 knowledge를 반복적으로 연관시키고 update하는 human ability를 mimic하도록 합니다. 또한, 우리는 MCTS algorithm의 routing strategy를 optimize하여 associative memory의 각 추가가 subsequent content generation에 대한 additional key information을 제공하도록 합니다. structured search와 adaptive learning 간의 이러한 synergy는 CoAT가 contextual coherence를 유지하면서 reasoning scope를 expand할 수 있게 하여 conventional LLMs의 limitations를 overcome합니다.

우리 framework의 effectiveness는 다양한 generative 및 reasoning tasks에 대한 extensive experiments를 통해 validated됩니다. 그 results는 우리 framework가 accuracy, coherence 및 diversity 측면에서 traditional models보다 significantly outperform함을 보여줍니다. inferences를 반복적으로 refine하고 evolving information을 integrate함으로써, 우리 CoAT framework는 precise and comprehensive한 outputs를 achieve하여 reasoning-oriented LLM frameworks에서 state-of-the-art를 발전시킵니다.

요약하자면, 우리 연구의 주요 contributions는 다음과 같습니다.

- 우리는 LLM reasoning을 enhance하기 위해 CoAT framework를 제안합니다. 우리 framework는 optimized MCTS algorithm을 사용하여 high-quality solution을 search하기 위해 LLM reasoning space를 expand합니다.

- 우리는 LLM reasoning process에 human-like associative and adaptive self-refinement capabilities를 부여하여 complex reasoning tasks를 effectively address합니다.

- 우리는 framework 내에서 optimal content generation path를 identify하기 위해 routing strategy를 optimized했으며, extensive qualitative and quantitative experimental results는 other inference approaches에 비해 superior performance를 demonstrate합니다.

이 논문은 다음과 같이 구성됩니다. Section 2에서는 LLM inference strategies에 대한 related work를 review합니다. Section 3에서는 CoAT framework의 design and implementation을 자세히 설명합니다. Section 4에서는 experimental results를 present하고, Section 5에서는 이 research의 implications와 potential future directions에 대한 insights와 함께 conclude합니다.

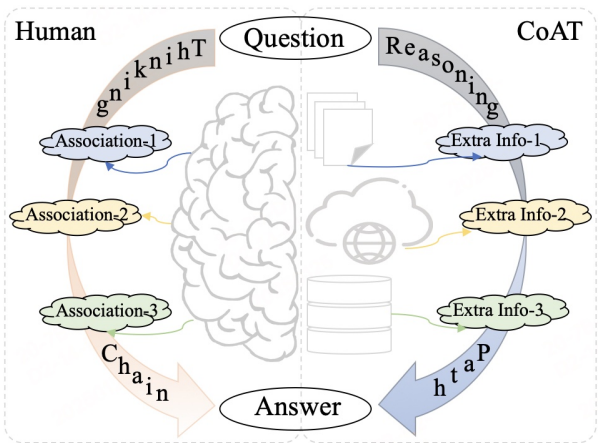

Figure 1: Left: Human thinking chain; Right: Associated thoughts chain. 이것은 우리 CoAT framework가 human associative mechanisms을 simulating하여 reasoning 중에 extra information을 지속적으로 supplement하도록 어떻게 inspired 되었는지를 illustrates합니다.

1 Introduction 정리 노트 (AI 연구자 대상)

핵심 요약

- 문제 제기:

- 대부분의 LLM은 "fast thinking" (단일 쿼리 기반) inference 방식을 사용.

- 이는 복잡한 추론이나 새로운 정보에 대한 적응에 취약.

- "Slow thinking"의 부상:

- OpenAI-o1 등의 등장으로 "slow thinking" (반복적, 점진적 추론) 방식이 주목받음.

- 하지만, 여전히 초기 입력 정보와 LLM 자체의 논리적 추론 능력에 의존.

- CoAT Framework 제안 (본 논문의 핵심):

- 인간의 연상(Association) 능력에서 영감을 받아 개발.

- Associative memory mechanism 도입: inference 과정에서 동적으로 새로운 핵심 정보를 통합.

- MCTS 알고리즘 최적화: associative memory 추가가 후속 내용 생성에 추가적인 핵심 정보를 제공하도록 라우팅 전략 개선.

- 이를 통해, 문맥적 일관성을 유지하면서 추론 범위를 확장 (기존 LLM의 한계 극복).

- 실험적 검증:

- 다양한 생성 및 추론 작업에서 기존 모델보다 성능 우수 (정확성, 일관성, 다양성).

- Contribution 요약:

- CoAT framework 제안 (MCTS 최적화, reasoning space 확장).

- LLM 추론 과정에 인간과 유사한 연상 및 적응적 자가 개선 능력 부여.

- 최적화된 라우팅 전략으로 최적의 콘텐츠 생성 경로 식별, 실험적 검증.

핵심 차별점

- Associative memory를 LLM inference에 최초 적용: 인간의 사고 과정을 모방하여 동적으로 지식을 업데이트하고 추론.

- MCTS와 Associative memory의 시너지: 구조화된 탐색과 적응적 학습을 결합하여 추론 범위와 정확도를 향상.

쉬운 설명 :

- 기존 LLM의 문제점: 대부분의 AI 모델(LLM)은 질문 하나를 받으면, 미리 학습된 내용을 바탕으로 빠르게 답을 내놓습니다 (fast thinking). 하지만, 복잡하게 생각하거나 새로운 정보를 반영해서 답을 수정하는 데는 약합니다.

- Slow thinking 등장: OpenAI에서 '천천히 생각하기(slow thinking)' 방식을 선보였습니다. 여러 단계를 거쳐 생각하고, 이전에 만든 답을 다시 검토하는 방식입니다. 하지만, 여전히 처음에 받은 질문과 AI 모델 자체의 능력에만 의존합니다.

- CoAT Framework: 이 논문에서는 사람이 생각하는 방식에서 아이디어를 얻었습니다. 사람은 어떤 것에 대해 생각할 때, 관련된 다른 기억들을 떠올리고(연상), 이를 바탕으로 생각을 넓혀갑니다. CoAT는 AI 모델이 추론 과정에서 새로운 정보를 계속 추가하고(associative memory), 이를 효과적으로 활용(MCTS 알고리즘 최적화)하여 더 정확하고 넓은 범위의 답을 찾도록 합니다.

- 쉽게 말하면, CoAT는 AI가 사람처럼 '생각의 꼬리를 물고' 더 똑똑하게 답을 찾도록 돕는 기술입니다.

Figure 2: CoAT framework의 Overview. Associative Memory (AM)는 reasoning 중 각 node에 added됩니다. "External Brain (EB)"은 reasoning results의 accuracy를 further improve하기 위한 optional measure입니다.

2 Related Work

Large Language Models (LLMs)의 development는 최근 몇 년 동안 significant advances를 보였으며, 특히 reasoning capabilities를 improving하는 데 중점을 두고 있습니다. 이 섹션에서는 LLM inference strategies, iterative reasoning frameworks의 integration, 그리고 associative memory mechanisms에 대한 key research를 reviews하며, 이 모든 것이 우리 Chain-of-Associated-Thoughts (CoAT)의 design에 inform합니다.

LLM Inference Strategies

Traditional LLMs (BERT, GPT-3 및 그 후속 모델(예: GPT-4))은 single-shot 또는 few-shot inference paradigm에 rely합니다. 이러한 methods는 fixed prompts를 사용하여 accurate responses를 provide하는 model의 ability를 emphasize하며, 종종 deeper reasoning이 필요한 scenarios에서 robustness가 부족한 outputs를 초래합니다. 이러한 limitations를 address하기 위해 researchers는 chain-of-thought (CoT) prompting과 interleaving retrieval with chain-of-thought (IRCoT)를 explored했으며, 이를 통해 LLM은 complex problems를 더 작은 sequential steps로 decompose할 수 있습니다. 이것은 reasoning quality를 improves하지만, model이 reasoning process 중에 previous inferences를 revisit하거나 refine할 수 없기 때문에 본질적으로 static remains입니다.

더 최근에는 self-consistency chain-of-thought (CoT-SC)와 같은 CoT의 variants가 multiple outputs를 sampling하고 가장 consistent solution을 selecting하여 reasoning에 diversity를 introduced했고, Graph-of-thought (GoT)는 solution paths를 more effectively search할 수 있는 search algorithms으로 improved되었으며, Tree-of-thought (ToT) prompting은 LLM에 의해 guided되는 DFS 또는 BFS search를 uses합니다. 그러나 이러한 methods는 underlying inference mechanism을 fundamentally alter하지 않으므로 dynamic and iterative reasoning processes의 further exploration을 위한 여지를 남겨둡니다.

'Slow thinking'의 concept은 traditional inference paradigms에 대한 alternative로 traction을 얻었으며, 시간이 지남에 따라 생각을 deliberate하고 refine하는 human ability에서 inspired되었습니다. OpenAI-o1은 이 space에서 pioneering framework였으며, complex problem solving and decision making과 관련된 tasks에 대한 iterative reasoning의 benefits를 demonstrating했습니다. LLM이 previous steps를 reassess하고 new information을 integrate하도록 함으로써, slow thinking frameworks는 adaptability and output quality를 improve합니다. 이러한 advancements는 static reasoning을 넘어 more dynamic, context-aware methodologies로 moving하는 potential을 highlight합니다.

Monte Carlo Tree Search in Inference

MCTS는 game playing 및 planning과 같이 uncertainty 하에서 decision making이 필요한 domains에서 long history of success를 가지고 있습니다. exploration과 exploitation의 balance를 맞추는 ability는 LLM reasoning을 enhancing하기 위한 compelling candidate가 됩니다. LLM-MCTS, LLM agent tree search (LATS) 및 reasoning via planning (RAP)와 같은 existing works는 MCTS를 specific AI systems에 integrated하여 search space exploration을 improve했지만, LLM에서의 application은 remains limited입니다. 우리 CoAT는 MCTS를 structured exploration뿐만 아니라 inference 중에 associative memory를 inserting하여 reasoning pathways를 iteratively refine하는 means로 leveraging함으로써 이 approach를 extends합니다.

External Knowledge Augmented Mechanisms

Augmented knowledge는 인간이 thinking할 때 related concepts 간의 connections을 형성하고 retrieve할 수 있도록 하는 external information retrieval process로, 다양한 machine learning models에 inspired되었습니다. Memory-augmented neural networks와 recurrent memory-based architectures는 long-term context retention이 필요한 tasks에서 effectiveness를 demonstrated했습니다. 그러나 이러한 systems는 종종 LLM inference 중에 evolving information에 adapt하는 flexibility가 lack합니다. Native Retrieval Augmented Generation (NativeRAG), Knowledge Augmented Generation (KAG) 및 hippocampal indexing RAG (HippoRAG)와 같은 recent advancements는 vector database 또는 knowledge graph에서 external knowledge를 input stage에 incorporating하여 이를 addressed했습니다. CoAT framework는 relevant information을 retrieves할 뿐만 아니라 new knowledge를 real time으로 updates and integrates하는 dynamic associative memory mechanism을 introducing하여 이 foundation을 builds upon합니다.

existing work가 LLM에서 reasoning and adaptability를 improving하는 데 significant strides를 이루었지만, key challenges는 remain합니다. Static inference strategies와 iterative mechanisms의 limited integration은 LLM이 complex, evolving tasks를 handle하는 ability를 restrict합니다. CoAT framework는 MCTS의 structured exploration과 associative memory의 adaptive capabilities를 combining하여 위의 limitations를 breaks through합니다.

다음 sections에서는 CoAT의 design and implementation을 detail하고 일부 tasks에서 superior performance에 대한 experimental evidence를 provide합니다.

2 Related Work 정리 노트 (AI 연구자 대상)

핵심 요약

이 섹션에서는 CoAT framework와 관련된 기존 연구들을 훑어보면서, CoAT가 기존 연구들의 한계를 어떻게 극복하고 차별점을 가지는지 강조합니다.

- LLM Inference Strategies:

- Traditional LLMs (BERT, GPT-3/4 등): Single-shot/few-shot 방식 → Deep reasoning 필요한 경우 한계.

- CoT, IRCoT: 문제 분해, sequential steps → 여전히 정적(static), 이전 추론 수정 불가.

- CoT-SC, GoT, ToT: 다양성/탐색 알고리즘 개선 → 근본적인 inference 메커니즘 변화는 없음.

- "Slow thinking" (OpenAI-o1): 반복적 추론, 새 정보 통합 → 여전히 초기 입력/LLM 자체 능력 의존.

- CoAT와의 차별점: 단순히 문제를 작게 나누거나, 이전 생성을 다시 보는 것을 넘어섭니다.

- Monte Carlo Tree Search (MCTS) in Inference:

- 기존 연구 (LLM-MCTS, LATS, RAP): 특정 AI 시스템에 MCTS 적용, 탐색 공간 개선 → LLM에 적용은 제한적.

- CoAT: MCTS를 구조적 탐색 + 추론 과정에서 Associative memory 삽입하여 반복적으로 추론 경로 개선.

- CoAT와의 차별점: MCTS를 단순 탐색 도구가 아닌, '연상 메모리'와 결합하여 추론을 정제하는 핵심 메커니즘으로 활용.

- External Knowledge Augmented Mechanisms:

- Memory-augmented neural networks, recurrent memory-based architectures: 장기 문맥 유지 → LLM 추론 중 변화하는 정보에 적응하는 유연성 부족.

- NativeRAG, KAG, HippoRAG: 입력 단계에서 외부 지식 통합 (벡터 데이터베이스, 지식 그래프) → CoAT는 입력 단계뿐만 아니라 추론 과정 전체에서 동적으로 지식 결합.

- CoAT와의 차별점: 외부 지식을 '가져오는' 것을 넘어, 실시간으로 새 지식을 업데이트하고 통합하는 동적 '연상 메모리' 메커니즘.

결론 (이 논문에서 강조하는 부분)

- 기존 연구들은 LLM의 추론 능력과 적응성을 개선하려는 노력을 해왔지만, 여전히 한계 존재.

- 정적인 추론 전략, 반복적 메커니즘의 제한적인 통합 → 복잡하고 변화하는 작업 처리 능력 제한.

- CoAT: MCTS의 구조적 탐색 + Associative memory의 적응적 능력 결합 → 이러한 한계 극복.

쉬운 설명:

- 기존 LLM 추론 방식의 문제점:

- 대부분의 LLM: 한 번에 답을 내놓거나(single-shot), 몇 가지 예시를 보고 답을 함(few-shot). 깊이 생각해야 하는 문제에는 약함.

- CoT, IRCoT 등: 문제를 작게 나누어 순서대로 해결. 하지만, 한 번 내린 결정을 바꾸기 어려움.

- CoT-SC, GoT, ToT 등: 여러 답을 만들고 그중 고르거나, 탐색 알고리즘 사용. 하지만, 생각하는 방식 자체를 바꾸지는 않음.

- "Slow thinking": 여러 번 생각하고, 새로운 정보도 반영. 하지만, 여전히 처음 받은 질문과 LLM 자체 능력에 의존.

- MCTS의 활용:

- 기존 연구: 게임처럼 경우의 수가 많은 문제에서 MCTS를 사용해서 최선의 수를 찾음. 하지만, LLM에 적용하는 경우는 드묾.

- CoAT: MCTS를 사용해서 가능한 답들을 탐색 + '연상 메모리'를 통해 새로운 정보를 계속 추가하면서 더 좋은 답을 찾아감.

- 외부 지식 활용:

- 기존 연구: 질문과 관련된 정보를 외부에서 가져와서(검색처럼) LLM에 입력.

- CoAT: 질문과 관련된 정보를 가져오는 것뿐만 아니라, AI가 생각하는 과정에서 떠오르는 새로운 정보('연상 메모리')를 실시간으로 추가하고 활용.

CoAT의 핵심: AI가 사람처럼 '생각의 꼬리'를 물고, 관련된 정보를 계속 떠올리면서(연상), 더 넓고 깊게 생각해서 똑똑한 답을 찾도록 하는 기술. 기존 연구들의 한계를 극복하고, 더 발전된 AI 모델을 만들기 위한 시도.

3 Method

인간의 cognitive processes 중에 associations를 형성하는 능력과 LLM의 reasoning capability를 enhancing하는 데 있어 MCTS algorithm의 demonstrated effectiveness에서 영감을 받아, 우리는 Figure 2와 같이 CoAT reasoning framework를 제안합니다. 이 framework는 association mechanism을 leverage하여 LLM이 reasoning process 중에 relevant information의 real-time retrieval과 self-augmentation을 수행할 수 있도록 합니다. 이 functionality의 realization은 tree node search를 통해 associative content와 generated content를 systematically integrates하는 optimized MCTS algorithm에 의해 underpinned됩니다. predefined rules에 따라 각 node에 precise values를 assigning함으로써, algorithm은 automatic association process를 facilitate하여 reasoning task를 completing합니다.

CoAT framework의 reasoning quality를 further enhance하기 위해, 우리는 associative content를 sourcing하기 위한 flexible mechanism을 designed했습니다. 이 mechanism은 model이 self-association을 수행하거나 "External Brain (EB)"이라고 하는 external knowledge sources를 통해 associative information을 retrieve할 수 있도록 합니다. external brain은 knowledge graph, vector database, LLM agents 및 web search engines와 같이 commonly used resources를 encompasses합니다.

"How should we view the role of artificial intelligence in contemporary interna-tional competition? Which countries hold the leading advantages in this field?"라는 query에 대한 CoAT framework의 detailed search process는 Figure 3에 shown되어 있습니다.

다음 subsections에서는 association memory mechanism과 optimized MCTS algorithm에 대한 detailed explanation을 provide합니다.

3.1 Associative Memory Mechanism

우리는 CoAT framework에 associative memory mechanism을 introduce합니다. 이는 novel external knowledge augmentation mechanism으로 간주될 수 있으며, LLM의 reasoning process가 각 node의 generated content에 따라 newly retrieved information을 real time으로 dynamically update and integrate할 수 있도록 합니다. Existing methods는 primarily extended knowledge를 initial stage에서 reasoning process에 incorporating하는 데 focus합니다. 그러나 이 approach는 overly broad knowledge를 incorporation하여 두 가지 significant drawbacks를 introduces할 수 있습니다. (a) inference efficiency를 compromises하는 irrelevant information의 excess, (b) critical content의 insufficient inclusion으로 ultimately inference quality를 degrading합니다. 대조적으로, inference process에 integrated된 우리의 proposed real-time association mechanism은 relevant knowledge를 ongoing inference와 dynamically aligning함으로써 이러한 issues를 effectively addresses합니다.

associative memory mechanism은 reasoning에 beneficial하고 historical contents에서 previously mentioned되지 않은 content를 generate합니다. associative content는 existing generated contents와 minimal redundancy를 exhibit해야 하며 reasoning process를 interfere하지 않도록 충분히 concise해야 합니다. 또한, associative content의 subject는 overall reasoning framework와 strong relevance를 maintain해야 합니다. 이러한 conditions가 satisfied되지 않으면 node의 associative content는 empty로 left될 수 있습니다. 위의 principle은 associative memory의 quality를 evaluating하기 위해 evaluation stage에서 applied됩니다.

node n_i의 associative memory를 generating할 때, "External Brain"은 inference results의 quality를 enhance하는 alternative approach로 serve할 수 있습니다. 그러나 이 approach는 inference efficiency를 reduce할 수 있습니다. 이 process는 다음과 같이 summarized될 수 있습니다.

AM(n_i) = EB 7→ LLM(Q | G(n_i)). (1)

여기서 G(n_i)는 node n_i의 generated content를 denotes하고, EB는 target LLM의 External Brain입니다.

그런 다음 node는 historical content와 all of its ancestral nodes에서 derived된 associative memories를 모두 reference할 수 있습니다. 그들의 historical content와 associative content는 함께 target LLM의 comprehensive thinking process를 constitute합니다. 각 node n_{i+1}의 generation process는 다음과 같이 formulated됩니다.

G(n_{i+1}) = LLM(Q | G(n_i) | AM(n_{1:i})). (2)

여기서 Q는 input query이고 AM(n_{1:i})는 reasoning trajectory에서 nodes n_1 ∼ n_i의 associative memories를 denotes합니다.

3.2 Optimized MCTS

MCTS algorithm의 standard process는 Selection, Expansion, Simulation, and Backpropagation의 four stages로 consists됩니다. selection stage에서 MCTS는 UCT algorithm (Upper Confidence bounds applied to Trees)을 applies하여 best node를 choose하고 trajectory에 adds합니다. node n의 UCT는 다음과 같이 calculated됩니다.

UCT(n) = V(n) + w * sqrt(ln(N(p)) / N(n)). (3)

여기서 N(n)은 node n에 대한 visits number, V(n)은 node n의 score value, w는 exploration weight, p는 n의 parent node입니다. episode의 end에 reached되면, back-propagation이 carried out되어 node n과 its parent nodes의 value를 update합니다.

traditional MCTS algorithm은 다양한 decision-making domains에서 significant success를 demonstrated했습니다. 최근 LLM의 advancements와 함께, more effective integration with LLM을 enable하기 위해 numerous novel variants of MCTS가 proposed되었습니다. LATS의 work는 Expansion 후에 Evaluation stage를 introduces하고 process의 end에 Reflection stage를 introduces합니다. evaluation stage는 expansion stage에서 generated된 content의 quality를 assesses하고, reflection stage는 outputs가 inputs를 correctly address하는지 determines합니다.

이러한 improvements를 building on하여, 우리는 expansion과 evaluation stages 사이에 human associative mechanism을 simulate하기 위해 Association stage를 propose합니다. optimized MCTS process는 Figure 4에 shown되어 있습니다. 결과적으로, associative content의 quality도 evaluation stage에서 assessed됩니다. evaluation criteria는 associative content의 quality와 expansion stage에서 generated된 content와의 correlation을 모두 encompass하며, excessive associations를 preventing하고 hallucinations를 mitigating하는 goal을 가집니다. 이제 각 node n의 evaluation value는 generated content value와 associative content value의 two components를 가집니다. 그리고 node value는 다음과 같이 calculated됩니다.

V(n) = F_g(Q, G(n)) + β * F_a(G(n), AM(n)). (4)

여기서 G(n), AM(n)은 각각 node n에서의 generated content와 associative content를 denotes합니다. F는 generation 및 association에 대한 evaluation function입니다. β는 associative content의 impact factor를 balance하는 weight입니다.

backpropagation stage에서, 우리는 leaf node에서 root node까지 simulation stage의 outcomes를 based on하여 trajectory를 따라 every node에 대한 visit counts와 quality evaluations를 update합니다. visit counts의 calculation은 C(n_{i+1}) = C(n_i) + 1로 formalized됩니다. 그리고 parent node n_p의 quality evaluation value는 its children nodes n_c^i와 함께 다음과 같이 updated됩니다.

V(n_p)* = (V(n_p) * C(n_p) + Σ_i^K V(n_c^i)) / (C(n_p) + K). (5)

여기서 K는 각 parent node의 candidate nodes number, C(n_p)는 n_p의 original visit counts입니다. updated된 node value V(n_p)*는 다음 selection stage에서 trajectory node를 choose하기 위해 UCT algorithm (Eq. 3.2)에서 used됩니다.

MCTS search process를 terminate할 시점을 more precisely determine하기 위해, 우리는 search trajectory의 leaf node에서 generated된 content를 evaluate하기 위해 specialized Reward Model (RM)을 trained했습니다. 특정 extreme cases에서 search process는 ambiguous state에 enter하여 inefficiencies를 leading할 수 있습니다. 이 issue를 mitigate하기 위해, 우리는 tree search의 maximum depth를 constrain하는 hyper-parameter (D)를 introduce합니다. search depth가 D를 surpasses하면 process가 halts되고, 그 point까지 obtained된 best inference result가 returned됩니다. 특히, D = -1로 setting하면 depth limitation이 removes되어 search가 optimal result가 identified될 때까지 continue될 수 있습니다. 위의 algorithm flow는 Algorithm 1로 summarized될 수 있습니다.

3 Method 정리 노트 (AI 연구자 대상)

핵심 요약

이 섹션에서는 CoAT framework의 핵심 메커니즘인 Associative Memory Mechanism과 Optimized MCTS를 자세히 설명합니다.

- CoAT Framework Overview (Figure 2 참조):

- 핵심 아이디어: LLM이 추론 과정에서 실시간으로 관련 정보를 검색하고 스스로를 보강(self-augmentation)할 수 있도록 하는 것.

- Associative Memory (AM): 각 추론 단계(node)에서 관련된 추가 정보를 동적으로 생성/통합.

- Optimized MCTS: 트리 노드 검색을 통해 AM과 생성된 내용을 체계적으로 통합, 자동 연상 프로세스(automatic association process)를 지원.

- External Brain (EB) (선택 사항): 외부 지식 소스(지식 그래프, 벡터 데이터베이스, LLM 에이전트, 웹 검색 엔진 등)를 활용하여 AM의 품질을 향상.

- 3.1 Associative Memory Mechanism:

- 기존 외부 지식 증강 메커니즘과의 차별점:

- 기존: 추론 초기 단계에 외부 지식 통합 → 광범위한 지식으로 인한 비효율성, 핵심 내용 누락 가능성.

- CoAT: 추론 과정에 실시간 연상 메커니즘 통합 → 진행 중인 추론과 관련 지식을 동적으로 정렬, 앞선 문제점 해결.

- AM 생성 원칙:

- 추론에 도움이 되고, 이전 내용에서 언급되지 않은 내용 생성.

- 기존 생성 내용과 중복 최소화, 간결성 유지.

- 전체 추론 프레임워크와 관련성 유지.

- (조건 미충족 시, 해당 노드의 AM은 비워둠.)

- AM 생성 공식:

- AM(n_i) = EB -> LLM(Q | G(n_i))

- n_i: 노드

- G(n_i): 노드 n_i에서 생성된 내용

- EB: External Brain (선택 사항)

- Q: 입력 쿼리

- 노드 생성 시, 이전 노드들의 내용과 조상 노드들의 AM을 모두 참조:

- G(n_{i+1}) = LLM(Q | G(n_i) | AM(n_{1:i}))

- AM(n_i) = EB -> LLM(Q | G(n_i))

- 기존 외부 지식 증강 메커니즘과의 차별점:

- 3.2 Optimized MCTS:

- 기존 MCTS와 차별점:

- Association Stage 추가: Expansion과 Evaluation 단계 사이에, 인간의 연상 메커니즘을 모방하는 단계 추가 (Figure 4 참조).

- Evaluation Stage 개선: 생성된 내용의 품질 + 연상 내용의 품질 및 관련성 평가 (과도한 연상, 환각 방지).

- Node Value 계산:

- V(n) = F_g(Q, G(n)) + β * F_a(G(n), AM(n))

- F_g: 생성 내용 평가 함수

- F_a: 연상 내용 평가 함수

- β: 연상 내용의 영향력 조절 가중치

- V(n) = F_g(Q, G(n)) + β * F_a(G(n), AM(n))

- Backpropagation:

- 방문 횟수 업데이트: C(n_{i+1}) = C(n_i) + 1

- 부모 노드 가치 업데이트: V(n_p)* = (V(n_p) * C(n_p) + Σ_i^K V(n_c^i)) / (C(n_p) + K)

- 종료 조건:

- Reward Model (RM): 생성된 내용 평가, 검색 종료 시점 결정.

- 최대 깊이 제한 (D): 비효율적인 탐색 방지 (D=-1: 제한 없음).

- 기존 MCTS와 차별점:

쉬운 설명:

- CoAT의 작동 방식:

- AI가 질문을 받으면, 답을 찾기 위해 여러 단계를 거쳐 생각합니다 (MCTS).

- 각 단계에서, 관련된 기억이나 지식(Associative Memory)을 떠올립니다.

- 떠오른 기억을 바탕으로 답을 조금씩 수정하고 발전시킵니다.

- 필요하면 외부 지식(External Brain)을 참고할 수도 있습니다.

- Associative Memory (AM)가 중요한 이유:

- 기존 AI는 질문과 관련된 정보를 처음에만 참고했습니다. 그래서 너무 광범위한 정보를 보거나, 중요한 정보를 놓칠 수 있었습니다.

- CoAT는 AI가 생각하는 중간중간에 계속 관련된 정보를 떠올리고(AM), 이를 바탕으로 생각을 업데이트합니다. 그래서 더 정확하고 관련성 높은 답을 찾을 수 있습니다.

- Optimized MCTS:

- MCTS는 여러 가지 가능한 답들을 탐색하는 알고리즘입니다.

- CoAT는 MCTS를 개선하여, 각 단계에서 AM을 활용하고, 생성된 답과 AM의 품질을 함께 평가합니다.

- 너무 엉뚱한 방향으로 생각이 뻗어나가지 않도록(환각 방지) 조절합니다.

- CoAT의 장점: AI가 사람처럼 '생각의 꼬리'를 물고, 관련된 정보를 계속 떠올리면서, 더 넓고 깊게 생각해서 똑똑한 답을 찾도록 돕는 기술입니다.

1. 인풋 : 질문

2. 루트노드가 질문인 셈

3. 일단 1개 이상의 자식 노드를 만들고 선택하고 또 1개 이상의 자식노드를 만들고 선택하고 리프노드까지 반복하면서 한번의 경로를 얻음.

4. 리프 노드까지 생성된 것을 보고 AM 을 생성하게 함.

5. AM을 바탕으로 leaf노드의 점수를 매기고 그 위의 경로에 있는 node들 업데이트.

6. 반복.

7. 어느정도 반복했다면 최종답은 가장 좋은 경로로 선택.